本文内容来自于网络,若与实际情况不相符或存在侵权行为,请联系删除。

编辑:LRS 疲惫不堪

1拥有自己的ChatYuan,网络堵塞将不再是问题。

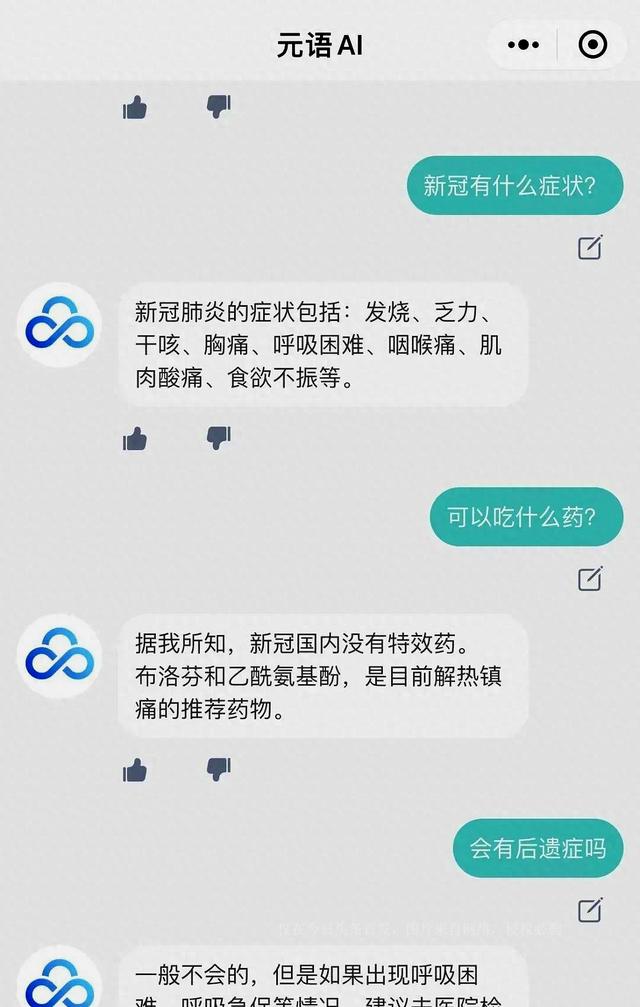

元语智能最近发布了一个名为ChatYuan的大型功能型对话模型,类似于ChatGPT。这个模型在网页版中已经有试玩接口了。

现在,你也可以在自己的机器上部署一个ChatYuan了!这个模型非常灵活,可以用于各种问答场景,它可以结合上下文进行对话,并执行各种生成任务,包括创意性写作。此外,它还可以回答法律和新冠等不同领域的问题。

最令人兴奋的是,它支持零样本学习,用户只需提供提示信息,就可以使用它进行文本生成、信息抽取,以及理解近30多种不同的中文任务。

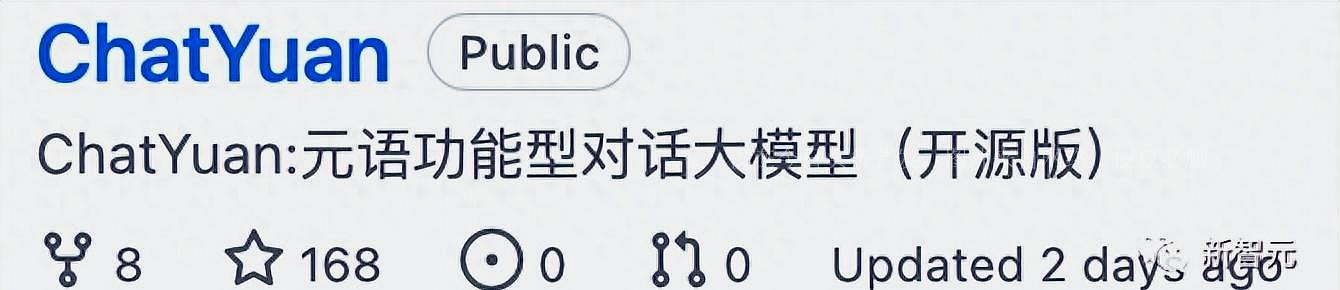

ChatYuan是基于PromptCLUE-large模型训练的,使用了数亿条功能性问题和多轮对话数据进行进一步训练,模型参数达到了77亿,而显存要求只有6G左右,这意味着一张普通的民用显卡就可以加载并使用。目前,该模型已经可以下载使用。

PromptCLUE模型在1000亿token的中文语料上进行了预训练,总共学习了15万亿中文token,并通过数百种任务进行了Prompt任务式训练。

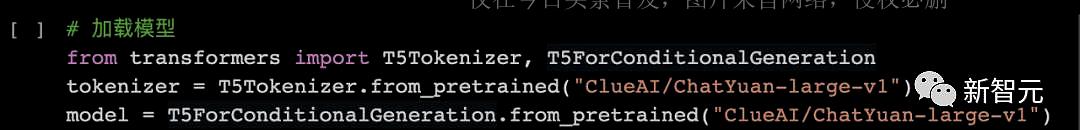

要加载模型,你可以使用以下预测推理方法。

PaddlePaddle

如果你想使用自己的数据来训练模型,下面是一些步骤:

组织数据

将数据按照统一的格式组织,通常包括输入和输出两部分。对于单轮问答或生成任务,输入包含任务描述和输入文本,输出则是模型需要预测的文本,就像下图中的 "小元" 后的内容一样。

对于多轮对话任务,输入会更复杂,包括任务描述、上文和输入文本,而输出仍然是系统需要预测的文本。

训练模型

你可以参考训练代码来进行训练、预测和效果验证。举个例子:

2

用户:你能干什么?

小元:您好!我是元语AI。我可以回答您的问题、写文章、写作业、翻译,对于一些法律等领域的问题我也可以给你提供信息。

3

用户:写一个诗歌,关于冬天。

小元:冬夜寂静冷,云在天边飘,冰封白雪上,寒冷像一场雪。雪花融化成冰,像那雪花飘洒,在寒冷的冬天,感受春天的喜悦。冬日里,风雪渐消,一片寂静,把快乐和温暖带回家。

4

用户:学前教育专业岗位实习中,在学生方面会存在问题,请提出改进措施。800字。

小元:在学前教育专业岗位实习中,在学生方面会存在一些问题,如学生缺少专业知识、缺乏合作意识、缺乏基本的责任心等等,需要我们采取措施,来解决这些问题。

首先,在实习过程中,我们需要培养学生的团队意识,加强学生与老师之间的合作,加强与家长之间的沟通,提高他们的沟通能力。另外,我们也需要加强学生的独立性,让学生学会独立思考,学会和老师、家长进行沟通,培养其独立性。

此外,在日常的工作中,我们也要为学生提供适当的机会和机会,让学生多接触社会、多参加社会活动,加深他们对社会、学校的认识,培养他们主动、积极和创新的精神。

最后,我们还需要重视学生在实习中出现的问题,尤其是学生缺乏合作,有依赖心理,不懂得分享,有拖延行为等,这些学生应该引起我们的重视,制定合理的改进措施,改善这些问题。

ChatYuan的技术和训练过程

ChatYuan是基于PromptCLUE模型的进一步训练。它专注于问答、对话和生成任务,去掉了文本理解和信息抽取任务。同时,它增加了抗干扰数据,使得模型可以在需要时忽略无关的上下文,还引入了用户反馈数据,提高了模

型的通用语言理解能力和特定任务生成能力。

PromptCLUE模型的学习过程经历了三大统一:模型框架、任务形式以及应用方式的统一。这意味着它更加通用、灵活。它还进行了大规模预训练,使用了数百GB的中文语料,进行了100万步的训练,总共训练了15万亿个中文字词级别的token。这使得模型具备了强大的语言理解能力。

PromptCLUE还使用了多种任务数据,包括16种任务类型和数百种具体任务,积累了亿级别的任务数据。这使得模型在执行各种任务时表现出色。

混合预训练是模型学习的关键,一方面将下游任务数据用于预训练,另一方面将下游任务和预训练语料一起训练,减少了任务灾难遗忘,缩短了预训练和下游任务之间的距离,从而更好地适应不同的任务。

为了解决不同任务数据量差异大的问题,采用了混合采样,每个训练批次内按比例采样不同任务,同时限制任务数据量的采样上限,以减少数据偏差和训练负迁移。

分阶段训练是另一个关键步骤,预训练时采用了分阶段训练,包括训练序列长度的分阶段,以提高训练速度。下游训练也采用了分阶段训练,包括学习率和序列长度的变化,以及对下游任务的数据量限制,以更好地适应不同的任务需求。

还有增加语言模型的训练,采用了无监督训练方式,同时也使用了prefix LM方式来增强生成任务的能力。此外,模型的encoder和decoder也得到了更多的训练,以提高模型的理解和生成能力。

最后,重新构建了模型的中文字典,使用sentencepiece学习并构建了模型字典,使其更符合中文语言的习惯。

未来的工作将继续改进ChatYuan,特别是在意图理解和复杂任务方面。开发团队将根据用户的反馈不断完善和优化模型,以确保它在各种应用场景中表现出色。ChatYuan的发布为自然语言处理领域带来了新的机会和可能性,它可以成为各种任务的有力工具,帮助人们更高效地处理文本相关的工作。

以上内容资料均来源于网络,相关数据,理论考证于网络资料,并不代表本文作者赞同文章中的律法,规则,观点,行为以及对相关资料的真实性负责。就以上或相关所产生的任何问题概不负责,本文作者亦不承担任何直接与间接的法律责任。

相关文章

猜你喜欢