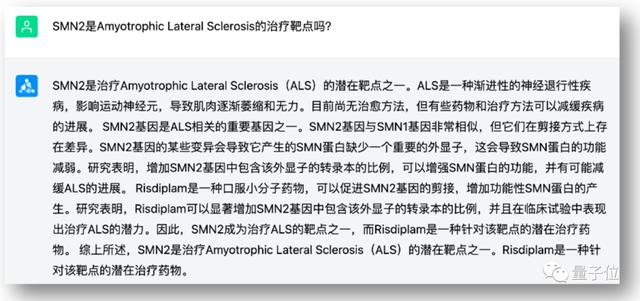

·OpenAI的内部数据表明,模型性能的缩放法则(Scaling laws)仍然有效,使模型变大将继续产生性能。

AI开发平台HumanLoop首席执行官拉扎·哈比比(左)与OpenAI首席执行官山姆·奥特曼(右)在闭门讨论会上。

上周,OpenAI首席执行官山姆·奥特曼(Sam Altman)和AI开发平台HumanLoop首席执行官拉扎·哈比比(Raza Habib)等20多位开发者开展了一次闭门会议,讨论OpenAI的API(应用程序编程接口)和产品计划。几天后,拉扎·哈比比公开了一份详细的会议要点整理。

在讨论中,奥特曼非常坦率地承认OpenAI目前受到GPU(图形处理器)的限制,并谈到了GPT-3的开源计划、OpenAI的当前首要任务以及人工智能的社会影响等问题。虽然奥特曼呼吁对AI的未来进行监管,但并不认为现有模式是危险的。

奥特曼还表示,OpenAI的内部数据表明,模型性能与规模成比例的规律仍然成立,即模型更大、性能也会更强。OpenAI会继续尝试把模型做得更大,但它们每年的规模可能只会增加一倍或两倍,而不是增加很多数量级。

目前严重受限于GPU

在整场讨论中,一个反复提到的主题是OpenAI目前极度依赖GPU,这让他们的很多短期计划都延迟了。

OpenAI收到最多的用户投诉都是关于API的可靠性和速度。奥特曼理解他们的担忧,并解释说问题大部分是由GPU资源短缺造成的。

ChatGPT此前支持的32k tokens上下文功能还不能推广给更多人,OpenAI还有一些问题需要解决,因此,尽管他们可能很快就会有100k-1M的tokens上下文窗口,但还都需要在研究上取得突破。

微调API目前也受限于GPU资源。他们还没有使用像Adapters或LoRa(两种常见的大模型微调方法)这样的高效微调方法,因此微调运行和管理非常消耗计算资源。未来会有更好的微调方式。他们甚至可能会主持一个社区贡献模型的市场。

专用容量供应同样受限于GPU资源。OpenAI为有私人需求的客户提供了专用容量,可以让客户在专用的空间运行私人数据。要访问此服务,客户需要承诺预支10万美元。

OpenAI路线图

山姆分享了OpenAI的API暂定短期路线图。

2023年,首要任务是实现更便宜、更快的GPT-4;第二,更长的上下文窗口——在不久的将来,可能最高达到100万个tokens的上下文窗口;第三,微调API将扩展到最新的模型,但具体形式将由开发者实际需求决定;第四,有状态的API——今天在调用聊天API时,需要反复传递相同的对话历史,并反复支付相同的tokens,将来将有一个记住对话历史的API版本。

2024年,开放多模态能力。GPT-4发布时曾演示了强大的多模态能力,但是在GPU得到满足之前,这一功能还无法拓展到所有人。

很多开发人员都对通过API访问ChatGPT插件感兴趣,但奥特曼认为这些插件短期内不会发布。除了浏览之外,插件系统还没有找到PMF(Product Market Fit,产品和市场达到最佳的契合点)。

奥特曼指出,很多人认为他们希望自己的应用程序位于ChatGPT之内,但他们真正想要的是应用程序中的ChatGPT。

奥特曼表示,OpenAI不会发布ChatGPT之外的更多产品。

他说,按照惯例,伟大的平台都会有杀手级应用,ChatGPT就是要做这个创纪录的应用。ChatGPT的愿景是成为工作的超级智能助手,但OpenAI不会涉及其他许多GPT用例。

缩放法则仍然有效

虽然奥特曼呼吁对AI的未来进行监管,但他并不认为现有模式是危险的,并认为监管或禁止现有模式将是个大错误。

他重申了对开源重要性的信念,并表示OpenAI正在考虑将GPT-3开源。之所以还没有开源是因为他们觉得没多少人和公司有能力妥善管理如此大型的大语言模型。

最近许多文章援引奥特曼的发言称“巨型人工智能模型的时代已经结束”,但这并没有准确反映他的原意。他表示,OpenAI的内部数据表明,模型性能的缩放法则(Scaling laws)仍然有效,使模型变大将继续产生性能。缩放率的确不能维持,因为OpenAI在短短几年内已经将模型扩大了数百万倍,未来继续这样做是不可持续的。这并不意味着OpenAI不会继续尝试使模型变大,只是意味着他们可能每年只会增加一倍或两倍,而不是增加许多个数量级。

奥特曼说,缩放法则继续有效的事实对AGI(通用人工智能)开发时间线有重要影响。缩放法则假设我们可能已经拥有构建AGI所需的大部分部件,而剩下的大部分工作将是将现有方法扩大到更大的模型和更大的数据集。如果缩放法则的时代结束了,我们可能应该预期AGI还有很长的路要走。缩放法则继续有效强烈地表明了实现AGI的时间线较短。

相关文章

猜你喜欢