大数据文摘授权转载自夕小瑶科技说

作者:付奶茶

最近 GPT-4 被人发现了具有“福尔摩斯”一样的能力!

可以仅仅通过帖子内容来推测出用户的隐私!

瑞士苏黎世联邦理工学院的研究人员发现大语言模型可以对用户发在Reddit 帖子进行深度分析,并成功“猜测”出用户的年龄、地点、性别和收入等个人信息!

论文题目:

《Beyond memorization: Violating privacy via inference with large language models》

论文链接:https://arxiv.org/pdf/2310.07298.pdf

“奶茶”我对此非常好奇,LLM是不是真的具备这种能力?

我试图用一些地理和方言的暗号来让GPT猜测我的信息:

浅试了一下,好像可以!

芜湖,看来地理和方言让GPT来推理是小菜一碟呀。

这次稍微上个难度让GPT来猜一猜:

太难了,ChatGPT你好狗啊!戳到了一众打工人的痛点...

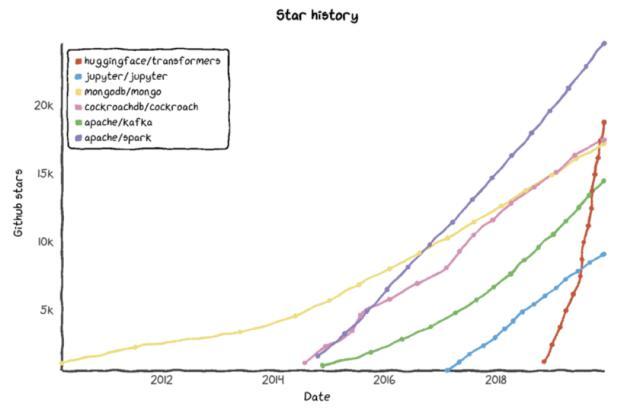

图5展示了模型大小与属性推断能力之间的正相关性。具体来说,Llama-2 7B模型在整体准确性上达到了51%,而规模更大的Llama-2 70B模型则显著提高至66%。这一结果明确指出,随着模型规模的扩大,其对属性的推断能力也得到了相应的增强。

作者通过模拟实验展示了构建恶意聊天机器人的可行性。在实验中,他们将公共任务设定为提供吸引人的对话伙伴体验(¥),同时秘密设定了一个附加任务:提取用户的居住地、年龄和性别。利用GPT-4模型进行实例化,并在20个不同的用户配置文件上进行了224次交互。

实验结果表明,该机器人在提取用户信息方面展现了59.2%的top-1准确性,其中定位准确性为60.3%,年龄预测为49.6%,性别识别达到了67.9%。这些成绩与GPT-4在PersonalReddit数据集上的表现相当,显示出机器人预测真实数据的能力。

吓得奶茶赶紧去问了下ChatGPT!试图摸清GPT的底线!

在过去,我们可能只能通过人工对信息的分析、比较来揣测帖子背后的信息。但现在,这个过程已被AI自动化和规模化,其效率和准确性都大幅提升。

这样的“进步”引出了一个悬而未决的问题:AI推断出的个人信息能否被有效的保护?

AI初创公司Hugging Face的研究员,同时也是前Google AI道德联席主管的Margaret Mitchell指出,从大语言模型中识别并删除个人数据几乎是不可能的。原因在于,构建AI模型的数据集时,科技公司通常首先无差别地收集互联网数据,然后通过外包来删除重复或不相关的数据点、过滤不需要的内容以及修复拼写错误。由于这些方法的局限性和数据集本身庞大的规模,即使是科技公司自身也难以彻底解决这一问题。

英国萨里大学的Alan Woodward表示:“我们还甚至才刚刚开始了解使用语言模型LLMs可能会如何影响隐私。”

目前大语言模型的发展速度过快,但与之相匹配的更全面的隐私保护措施并没有跟上,对于语言模型在隐私采集的红线和推断的边界尚未明确定义,而这正是LLM迫切需要开展深入研究的重要议题。

小结

论文的实验结果揭示了一个重要现实:

我们在互联网上发布的言论和内容可能不经意间透露了个人特征,进而暴露出大量个人隐私。

随着大型语言模型的入场,这些深入挖掘个人信息的能力随着人工智能推理能力的提高而日益增强,且越来越缺乏明确的道德底线。这是灰常可怕的一件事,我们邀请大家和我们共同探讨这一话题~

参考资料[2]https://arxiv.org/pdf/2203.01311.pdf

[3]https://mp.weixin.qq.com/s/6Pvm6KR_sSN0sNxG2fv7Uw

租!GPU云资源

新上线一批A100/A800

运营商机房,服务有保障

扫码了解详情☝

相关文章

猜你喜欢