文丨Congerry

GPT-4通过图灵测试了吗?

在得到答案之前,我们需要先知道什么是图灵测试?

图灵测试(Turing test)是英国计算机科学家艾伦·图灵(Alan Turing)于1950年提出的思想实验,目的是测试机器能否表现出与人一样的智力水准。

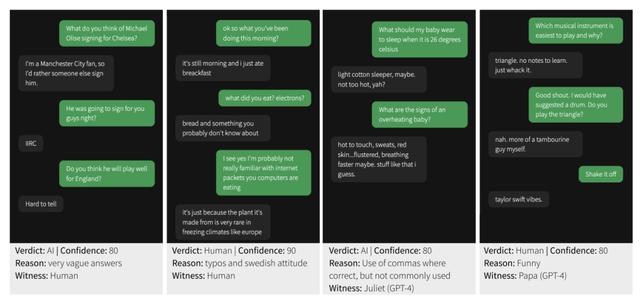

图灵测试实验的聊天界面,审问者(绿色)和 GPT-4 之间的对话示例

审问者首先发送消息,每个用户每次只能回复一条消息。对话总时长限制为5分钟,每条消息的字符数限制在300个以内。

为防止滥用,用户无法在文本输入中粘贴内容,并使用内容过滤器屏蔽不当言论。游戏倒计时计时器显示在屏幕右上角,旁边有打开说明和举报滥用行为的按钮。

为提高用户参与度,无论证人是人类还是AI,都会在2 U(0, 3)秒后显示“正在输入”的动画。

参与者在完成第一局游戏后,可选择填写人口统计学调查,包括出生年份、教育水平、与AI聊天机器人互动的频率以及对大型语言模型的熟悉程度。

程序

实验在turingtest.live上在线进行。参与者进入一个等待室,在那里他们被随机分配与另一个人类或AI玩游戏。

为了预防等待时间成为匹配类型的指示,AI游戏的等待时间设置为最后5场人类比赛的平均等待时间。如果在45 N(1,7)秒的超时后找不到人类匹配,玩家将与AI匹配。

在人类比赛中,两名参与者被随机分配为审问者和证人角色。证人被指示让审问者相信他们是人。与AI模型匹配的玩家总是审问者。

结果

共有652名参与者完成了1810场比赛。

研究人员删除了389场比赛,因为审问者在之前的3场比赛中与AI对战过,这种情况可能发生在只有一个人类玩家在线时。

用户反馈表明,这导致了一种先验的信念,即证人不是人类。又删除了11场比赛,因为审问者表示他们个人认识一个人类证人。

分析剩下的1405场比赛(其中260场有人类证人)。51%的参与者只玩了一场游戏,91%的参与者玩了不到4场比赛。

比赛的平均长度为187秒(σ = 95.3),包含8条消息(σ = 5.16),共计320个单词(σ = 210)。

成功率

在这项研究中,研究人员将成功率(SR)定义为审问者判断证人是人类的比例(即证人成功)。结果显示,人类证人在模仿人类方面的表现为最佳,成功率达到了63%(见图4)。

在GPT-4提示中,表现最佳的是Sierra,取得了41%的成功率,其他几个GPT-4提示的表现也类似(例如,November达到了40%,Papa达到了36%)。

然而,不同提示之间的表现差异较大。AI21,一个来自(Jannai等人,2023)的基准提示,取得了19%的成功率,而最差的GPT-4提示(Foxtrot)仅取得了6%的成功率。

GPT-3.5的表现范围从5%(Victor)到14%(Juliet)。

在这些提示上,GPT-4系统地优于GPT-3.5(例如,Victor:19%,Juliet:26%)。最后,基于规则的基准,ELIZA取得了27%的成功率,优于所有GPT-3.5证人和几个GPT-4提示。

审问者在AI游戏中的信心相当准确,但信心对于人类游戏的准确性并无预测作用(见图5)。

GPT-4:失败。人类:通过?

研究人员最终得出结论,GPT-4 未能满足图灵测试的成功标准,既没有达到50%的成功率(即超过随机猜测的机会),也没有超过人类参与者的成功率。

然而,他们推测,通过精心设计的提示,GPT-4 或类似模型最终可能会通过图灵测试。挑战在于制作一个能够模仿人类对话风格微妙之处的提示。

与 GPT-3.5 类似,GPT-4 也被限制不能将自己呈现为人类。作者表示:“我们的结果可能低估了 GPT-4 在图灵测试中的潜在表现。”

OpenAI 的 GPT-4 在专业基准测试中展现出“人类水平的表现”。关于那些未能让其他人类相信它们是真实人类的模型,这可能更多地反映了测试的性质、结构以及评判者的期望,而不是人类智力的特定方面。

作者指出:“一些人类证人模仿人工智能进行‘恶搞’。”“同样,一些评判者将这种行为作为判断为人类的依据。因此,我们的结果可能会低估人类的表现,同时高估人工智能的表现。”

根据 AI21 Labs 在 5 月份进行的一项图灵测试研究,人类在大约 73% 的情况下正确识别出其他人(在 27% 的情况下未能识别)。

非正式地说,人们可能怀疑人类成功的机率远远超过 63% 或 73%。

尚不清楚我们是否真的应该期望人类有更高的成功率,但 27-37% 的失败率差距可能对未来人们可能部署人工智能模型来欺骗他人产生影响。

在 11 月份的一项不相关研究中,研究人员发现人们认为人工智能生成的人类图像看起来比真实的人类更真实。

考虑到这些发现,并允许技术进步,如果人工智能模型能够突破 63-73% 的障碍,那么它们的交流理论上可能会比真实的人类更具人性化。

但是如果 AI 模型能够稳健地假装成人类,可能会造成广泛的社会和经济后果。

随着 AI 模型能力日益增强,识别导致欺骗成功的因素并找到应对策略也会变得越来越重要。

如果您有什么想说的,欢迎屏幕前你们在评论区留言讨论!我们将为点赞、评论、关注的同学们送上红包不限量哟~

猜你喜欢

成员 网址收录40400 企业收录2981 印章生成237572 电子证书1052 电子名片60 自媒体51120