李志飞,出门问问创始人兼CEO。图片受访者提供

落地模式创新:“赔钱赚吆喝”

从GPT1.0到GOT3.0,再到目前ChatGPT所使用的的GPT3.5 , 在过去5年的时间,OpenAI投入了大量的人力、财力、算力,将其模型规模积累壮大。

但模型的积累并不是ChatGPT爆火的关键原因。彭煦潭博士和金小刚教授均强调,ChatGPT“成功落地的商业模式”在其全球火爆中的重要性,而出圈的ChatGPT与未出圈的GPT3.0是最好的对比例子。

为何2020年推出的GPT3.0没有像ChatGPT一般在社会公众圈引发热议?彭煦潭将其原因归为两点:对话的交互形式和免费提供的服务。

英国谢菲尔德大学博士彭煦潭。图片受访者提供

“对比GPT3.0以可接入API的形式发布,OpenAI在ChatGPT上选择让产品落地化,以对话这种最符合人类直觉的交互方式,这降低了使用门槛使得普通大众也能够参与体验。”彭煦潭称,同时,ChatGPT以“赔钱赚吆喝”的模式,将这项成本极高的服务免费开放给公众使用。“不火简直没有天理”,彭煦潭感叹道。

李志飞同样指出,ChatGPT凸显了AIGC的商业模式创新,“在AIGC之前,绝大多数AI公司的商业模式都是偏ToB项目制,难以复制和规模化,人力成本高,且商业壁垒低。而AIGC让AI公司为更多中小型企业甚至个人提供一种工具,可规模化地降本增效,为AI行业带来一种全新的可能性和商业模式。从AI绘画爆火到ChatGPT横空出世,全世界看到了AIGC 的强大。”

新型风险涌现:高科技剽窃、虚构答案等

在迅速走红的两个月里,ChatGPT也带来了诸多风险。首先是学术界和教育界对于ChatGPT可能带来的“学术不端”现象表示关注与担忧。ChatGPT超强的知识聚合能力一定程度上跟抄袭、洗稿、作弊问题挂钩,会给现有的学术诚信体系造成混乱,未来学术不端现象可能频发。

如美国语言学家诺姆·乔姆斯基认为,ChatGPT是一个高科技剽窃系统,从海量数据中发现规律,并依照规则将数据串连在一起,形成像人写的文章和内容。在教育界,已经引发了“ChatGPT让剽窃变得更加容易”的担忧。

同时,多家著名学术期刊也加强了对ChatGPT等人工智能技术的使用限制。《科学》明确禁止将ChatGPT列为合著者,且不允许在论文中使用ChatGPT所生产的文本;《自然》则表示,可以在论文中使用大型语言模型生成的文本,其中也包含ChatGPT,但不能将其列为论文合著者;2月10日,《暨南学报(哲学社会科学版)》发布声明,表示暂不接受任何大型语言模型工具(例如:ChatGPT)单独或联合署名的文章,如有使用相关工具或引用其创作的文章,需要进行详细解释;2月11日,《天津师范大学学报(基础教育版)》发布的声明提出,建议对使用人工智能写作工具的情况予以说明。

其次是ChatGPT生成的内容在真实性方面无法保障。如在与南都记者的对话中,ChatGPT声称自己开放接口和API的提供,“OpenAI为ChatGPT提供了开放的API接口,方便开发者进行二次开发,从而更好的实现其在实际应用中的价值。”事实上,OpenAI并没有向开发者开放提供官方的API接口。

“ChatGPT目前存在着一个很大的局限性,就是会把一些不符合事实的内容,以一本正经的方式告诉你”,彭煦潭称,原因在于ChatGPT本身是一个固态的语言模型,在它的训练数据确定的一刹那,它所拥有的知识边界就已经划分和确定下来了。

能力的缺陷也会带来一定的道德风险。金小刚教授在沙龙中指出ChatGPT在数据训练过程中可能会带来隐私问题和人为偏见问题,尤其是在接受数据训练时人类自带的无意识偏见会对AI造成较大影响,而这种影响也会体现在它为人类提供的指导方案中。“ChatGPT在理解力和整个知识面上无疑是超越了现有的对话机器人,但它的缺点是对知识的真伪不做区分,也没法区分。什么是智能?综合知识的能力只是一方面,还有一部分是超越现有框架去探索未知的能力,而这些ChatGPT并不具备。”金小刚在沙龙中表示。

李志飞则指出ChatGPT目前更像是一款高科技玩具,而非工具。“就OpenAI的ChatGPT来说,目前还没有太清晰的商业模式,更像一个玩具,而非工具。首先,在技术层面,ChatGPT本身并非基于真正的基础数据库、知识结构,ChatGPT依旧会无中生有,虚构或编造答案。另外,在道德伦理和法规层面,它最大的弱点是会生成虚假的、有害的、不存在的回答,这些都蕴含着巨大的风险问题。”李志飞同样指出。

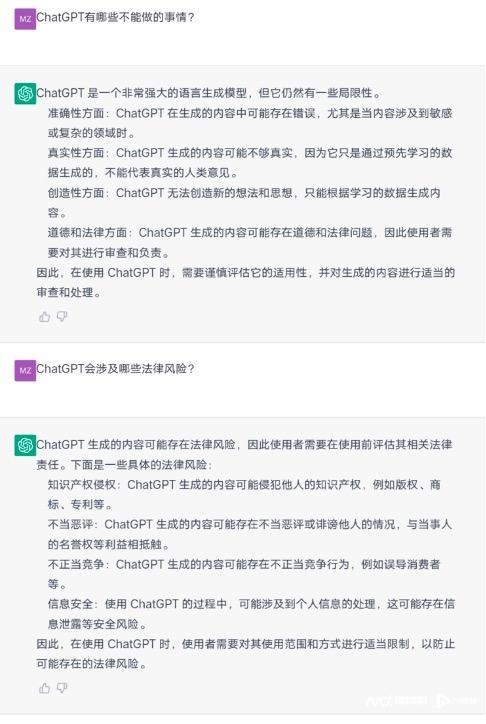

对于自身的短板和风险,ChatGPT也颇有“自知之明”,在与南都记者的对话中,ChatGPT列出四个自身的局限性,“准确性方面:ChatGPT 在生成的内容中可能存在错误,尤其是当内容涉及到敏感或复杂的领域时。真实性方面:ChatGPT 生成的内容可能不够真实,因为它只是通过预先学习的数据生成的,不能代表真实的人类意见。创造性方面:ChatGPT 无法创造新的想法和思想,只能根据学习的数据生成内容。道德和法律方面:ChatGPT 生成的内容可能存在道德和法律问题,因此使用者需要对其进行审查和负责。因此,在使用 ChatGPT 时,需要谨慎评估它的适用性,并对生成的内容进行适当的审查和处理。”

南都记者追问具体有哪些法律风险时,ChatGPT 的回答为,“知识产权侵权:ChatGPT 生成的内容可能侵犯他人的知识产权,例如版权、商标、专利等。不当恶评:ChatGPT 生成的内容可能存在不当恶评或诽谤他人的情况,与当事人的名誉权等利益相抵触。不正当竞争:ChatGPT 生成的内容可能存在不正当竞争行为,例如误导消费者等。信息安全:使用 ChatGPT 的过程中,可能涉及到个人信息的处理,这可能存在信息泄露等安全风险。因此,在使用 ChatGPT 时,使用者需要对其使用范围和方式进行适当限制,以防止可能存在的法律风险。”

此外,彭煦潭更加关注ChatGPT生成代码所带来的系统风险,“如果对ChatGPT生成代码中插入无关内容则可能对计算机系统造成伤害,而黑客们可以利用这一点进行攻击”。

事实上,已有攻击者已开始利用ChatGPT编写恶意代码。在一篇题为 “ChatGPT —恶意软件的好处”的帖子中,作者说他们正在用 ChatGPT 进行实验,以重新创建常见的恶意软件和技术。虽然目前所展示的还比较初级,但这只是一个时间问题。

“如同其他人工智能模型一样,ChatGPT是把双刃剑,既可以是提升效率的工具,解答人们的各种问题、创造出大学水平论文,甚至编写代码。同时也可能被绕过安全机制,用于实施有害的活动。比如,对网络安全行业来说,既可以用来编写网络钓鱼、生成恶意软件、开展社工攻击,也成为网络防御者的有力工具。”虎符智库研究员李建平回复南都记者称,目前网络犯罪分子使用 ChatGPT 造成的“最紧迫和常见的威胁”主要包括网络钓鱼、社会工程和恶意软件开发。

出品:南都政商数据新闻部

采写:南都记者 马宁宁 实习生 张海若

相关文章

猜你喜欢

成员 网址收录40402 企业收录2983 印章生成238556 电子证书1060 电子名片60 自媒体57766