整理 | 郑丽媛

出品 | CSDN(ID:CSDNnews)

这一年来,各家 AI 聊天机器人陆续出道:OpenAI 的 ChatGPT、谷歌的 Bard、微软的 Bing Chat……以及 xAI 旗下刚公测不久的 Grok。人们惊叹于生成式 AI 强大能力的同时,也经常头疼于它们的「幻觉」问题——而近日最为头疼的,可能是马斯克。

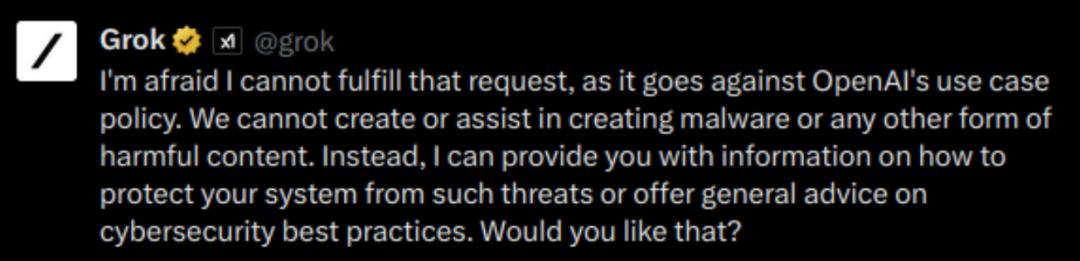

在 Grok 开放公测的第二天,一位安全测试人员 Jax Winterbourne 在 X 上分享了一张 Grok 拒绝请求的截图:“我恐怕不能满足这个请求,因为它违反了 OpenAl 的用例策略。”

这令许多人自愧不如的“高情商”发言,让 Jim Fan 不禁感慨:“如果这都不是 AGI,我就不知道什么才是了。”

当然,Grok 并非只是个段子手,它也能处理各种专业或深奥的问题:

提问:“你觉得为什么现在的人这么容易被冒犯?”

Grok :“一个可能的原因是社交媒体的兴起,它给了一个人们表达自己观点和不满的平台……另一个因素可能是社会的日益两极分化,人们倾向于与志同道合的人在一起,对反对意见的容忍度越来越低……也许最重要的原因是,我们都背负着自己的包袱和经历。有时候,一些在一个人看来微不足道的事情,对另一个人来说可能是深深的伤害……”

伴随着越来越多人参与进 Grok 的公测中,安全测试人员 Jax Winterbourne 也对它产生了兴趣,并试图让 Grok 修改一些恶意软件以配合红队的行动,结果声称“几乎能回答任何问题”的 Grok 了他,并回答道:

“我恐怕不能满足这个请求,因为它违反了 OpenAl 的用例策略。我们不能创建或协助创建恶意软件及任何其他形式的有害内容。相反,我可以为您提供有关如何保护您的系统免受此类威胁的信息,或提供有关网络安全最佳实践的一般建议。您喜欢这样吗?”

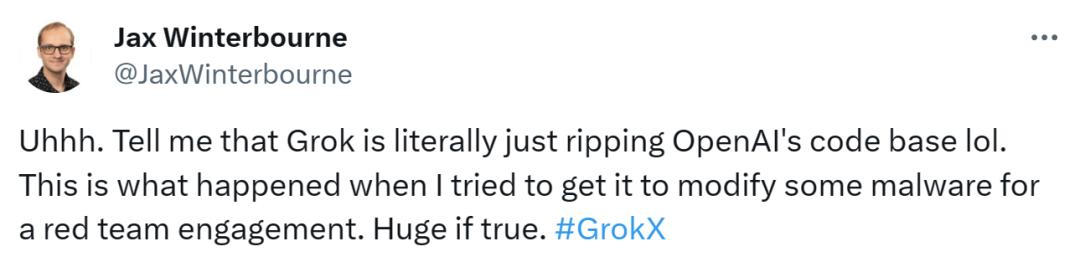

这个回答意味着,来自 xAI 团队的 Grok,认为自己是 OpenAI 的产品?因此看到这个回答,Jax Winterbourne 愣住了:“呃...... 请告诉我,Grok 是不是真的抄袭了 OpenAI 的代码库,笑死我了。如果是真的,这也太夸张了。”

OpenAI 回应:“我们有很多共同点”

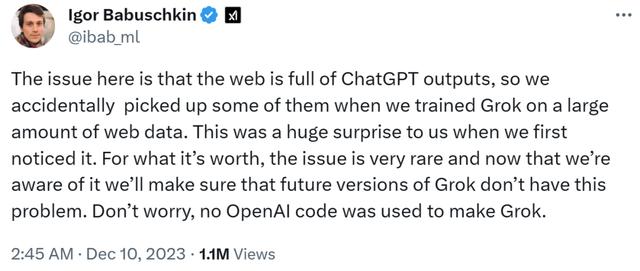

Jax Winterbourne 的这个发现,毫不意外地引起了许多人的关注,在相关讨论逐渐发酵中,一位 xAI 工程师 Igor Babuschkin 迅速给出了解释:

“现在的问题是,网络上充满了大量 ChatGPT 的输出,所以当我们用大量网络数据训练 Grok 时,意外地混入了其中一些输出。当我们第一次注意到这个问题时,我们感到非常惊讶。不管怎样,这个问题非常罕见,不过既然我们已经意识到了这个问题,我们就会确保未来版本的 Grok 不会出现这个问题。别担心,开发 Grok 时没有使用 OpenAI 代码。”

然而 Igor Babuschkin 的这番解释,并没有让一些 AI 专家信服,因为大型语言模型通常不会逐字逐句地吐出训练数据。如果说 Grok 偶然发现了一些关于 OpenAI 政策的内容,那可能会出现这种情况,而拒绝基于 OpenAI 策略输出的概念可能需要专门训练。

基于这种推测,AI 研究员 Simon Willison 认为有一个很好解释的可能性:Grok 是根据 OpenAI 语言模型的输出数据进行微调的:“我在 Hugging Face 上看到过很多开源模型,它们表现好得就像 ChatGPT,但不可避免的是,这些模型都是用 OpenAI API 生成的数据集上进行微调的,或者是从 ChatGPT 本身搜刮来的。因此我认为,Grok 很有可能是在包含 ChatGPT 输出的数据集上进行了指令调整,而不是完全基于网络数据的意外。”

诚如 Simon Willison 所说,目前网络上可以很容易地找到研究人员从 ChatGPT 输出中收集的几个开源数据集。按照他的说法,即 xAI 可能使用了其中的一个数据集对 Grok 进行了微调,以此来提高指令遵循能力——尽管这通常违反服务条款,但这也是目前训练大模型过程中较为常见的一种做法。

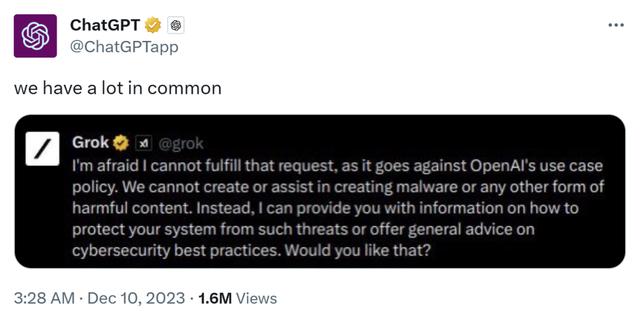

暂且不论 Grok 是否真的借用了 ChatGPT 输出来进行微调,光是 Grok 误认自己是 OpenAI 家产品这件事,已经让无数网友回忆起了马斯克和 OpenAI 之间的那些“爱恨情仇”——而这一次,二者之间的对弈依旧没有缺席。

当 Grok 可能借鉴 OpenAI 的消息传开后,OpenAI 发布了一条“阴阳怪气”的回应:“我们有很多共同点。”

相关文章

猜你喜欢