之前我写过实测在Mac上使用Ollama与AI对话的过程 - 模型选择、安装、集成使用记,从Mixtral8x7b到Yi-34B-Chat,最近用上了LM Studio,对比Ollama,LM Studio还支持Win端,支持的模型更多,客户端本身就可以多轮对话,而且还支持启动类似OpenAI的API的本地HTTP服务器。

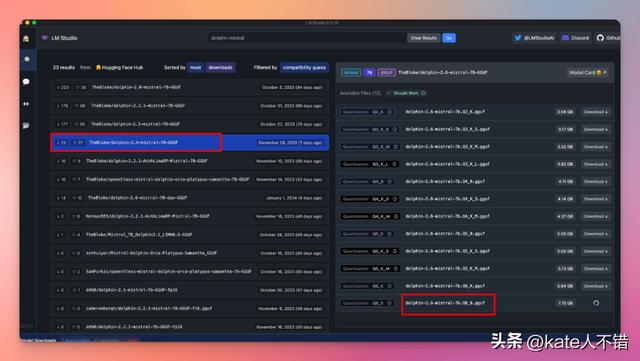

我推荐dolphin-2.6-mistral 7B和dolphin-2.7-mixtral-8x7b模型。

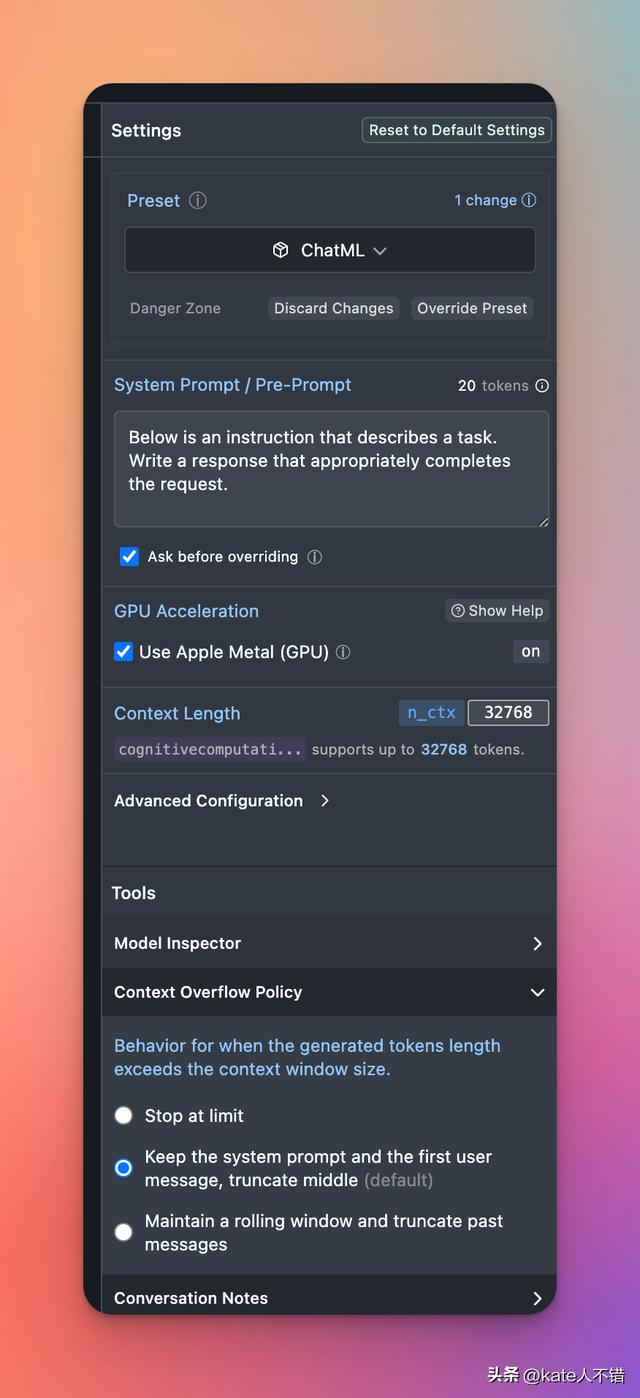

下载后选择模型,设置参数,再重新加载模型。

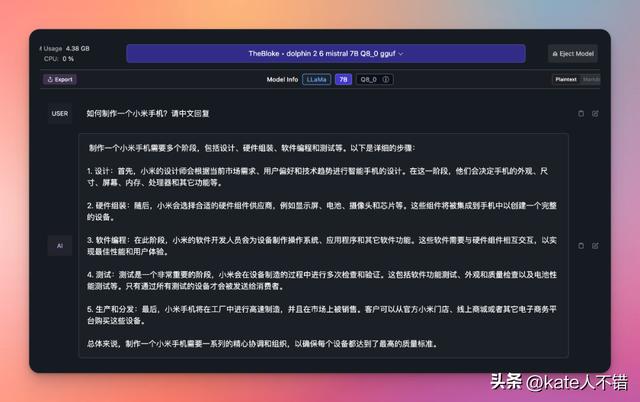

实测,dolphin-2.6-mistral 7B模型在我Mac M1 Max 32G的电脑上运行速度很快,生成质量不错,而且dolphin是可以生成NSFW内容的。

LM Studio的特色功能

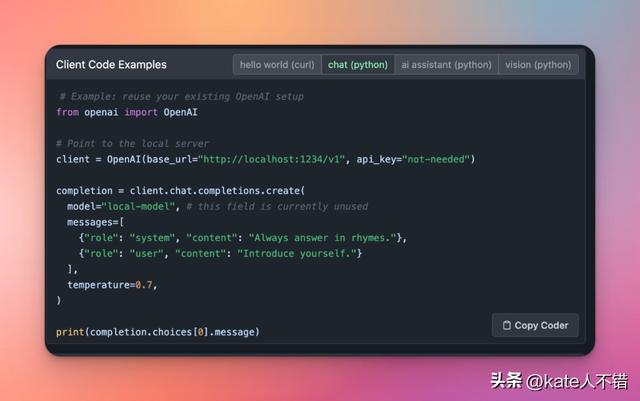

我最喜欢LM Studio的功能是支持启动类似OpenAI API的本地HTTP服务器。

更多OpenAI · Cloudflare AI Gateway docs请看这里:

https://developers.cloudflare.com/ai-gateway/providers/openai

当通过Cloudflare AI Gateway运行后,可以在实时日志里查看每一次调用状态。

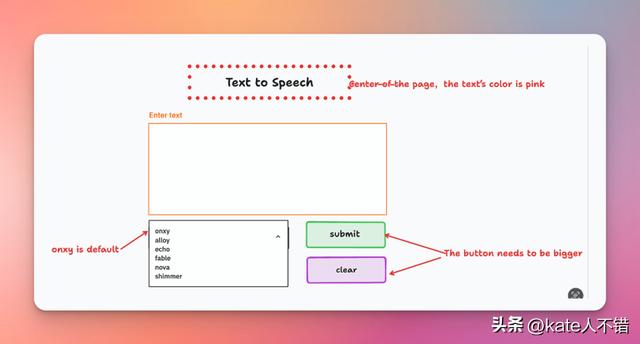

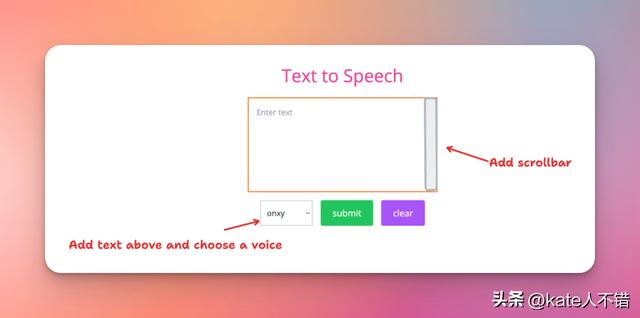

界面设计:Tldraw与Gradio的应用

我是用Tldraw帮我做的界面,教程请见tldraw make real:利用AI一键从原型图到生成真实可用的代码。

生成的UI代码最后又让GPT4修改了一下。

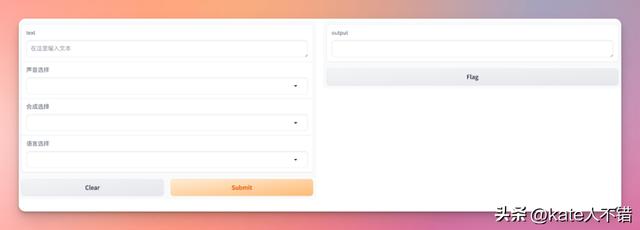

我还试了不用html,而用Gradio来做UI。

Gradio是一个开源的Python库,它允许用户为机器学习模型构建用户界面,并将其部署在几行代码中。Gradio的主要优势在于其易用性,只需简单定义输入和输出接口,就可以快速构建简单的交互页面,并轻松部署模型。

这个界面大家应该很熟悉,很多大模型的demo用的是这种界面。

由于刚接触Gradio不久,为避免GPT4出现上文OpenAI文档过时的情况,我做了个“Gradio文档助手”GPT来帮我写Gradio代码。

文本转语音实践:Python代码分享

这里分享直接可以运行的text to speech python代码:

from openai import OpenAIimport osimport datetimeclient = OpenAI(base_url="https://gateway.ai.cloudflare.com/v1/ACCOUNT_TAG/GATEWAY/openai/", api_key=os.getenv('OPENAI_API_KEY'))# 指定的文本文件路径和语音文件保存路径input_file_path = 'text2speech-input.txt'current_time = datetime.datetime.now().strftime("%Y%m%d%H%M%S")# 读取输入文件并生成语音with open(input_file_path, 'r') as file:lines = file.readlines()for i, line in enumerate(lines):input_text = line.strip()speech_file_path = f'/Users/yourmac/Downloads/{current_time}_{i 1}.mp3'response = client.audio.speech.create(model="tts-1",voice="onyx",input=input_text)# 保存语音文件response.stream_to_file(speech_file_path)print(f"Speech {i 1} saved to {speech_file_path}")

同目录下新建文件text2speech-input.txt,将要转录的文字放在文档里。

我还编写了根据AI绘图提示词批量生成图片的程序,只是DALLE3的API费用太贵,小试一下。

本地模型与OpenAI模型的结合

回到开头介绍的LM Studio,本地大模型可以完成许多有趣的任务,而不需要调用开销更高的API。例如,本地模型可以生成创意的绘画提示词和主题,以帮助艺术家获得灵感。它们也可以用来写出引人入胜的故事大纲。

除了独立完成这些创作任务外,本地模型还可以与OPENAI等API结合,发挥各自的优势。比如,本地模型可以先生成初始素材,再由OPENAI模型进行细化和提升。这样既节省了调用API的成本,又能发挥大模型的强大能力。探索本地模型和API的最佳组合,能帮助我们在成本和效果之间找到最好的平衡点。

相关文章

猜你喜欢