编辑 孙远明

近日,一路狂飙的ChatGPT陷入多事之秋。

先是意大利封杀ChatGPT,限制OpenAI处理本国用户信息。接着,三星导入ChatGPT不到20天,便曝出机密资料外泄。此后,又有消息传出ChatGPT停止注册,开始大面积封号。

负面消息不断,ChatGPT怎么了?

欧洲多国要“封杀”ChatGPT?

意大利封杀ChatGPT的消息来得很突然。

3月31日,意大利个人数据保护局宣布,即日起暂时禁止使用聊天机器人ChatGPT,并表示已对ChatGPT背后的OpenAI公司展开调查。

该机构称,尽管根据OpenAI发布的条款,ChatGPT针对的是13岁以上的用户,但并没有年龄核实系统来验证用户年龄。

意大利个人数据保护局说,3月20日ChatGPT平台出现了用户对话数据和付款服务支付信息丢失情况。此外平台没有就收集处理用户信息进行告知,缺乏大量收集和存储个人信息的法律依据。意大利个人数据保护局还表示,已暂时限制ChatGPT使用意大利用户的个人数据。

据了解,意大利封禁ChatGPT所援引的法律工具是欧盟《通用数据保护条例》(GDPR),除了大型互联网公司,GDPR也能拿来监管新出现的人工智能公司。法国和爱尔兰的隐私监管机构已经与意大利的同行联系,以了解更多关于禁令的依据。

西班牙的监管机构也表示,虽然暂未收到任何关于ChatGPT的投诉,但不排除未来会进行调查。

值得注意的是,欧洲的隐私监管机构往往独立于政府,在隐私保护上权力很大。意大利和德国的政府都不支持封禁ChatGPT,意大利副总理批评了本国监管机构的决定,称其 “过度”;德国政府发言人则对媒体称,没有必要禁止ChatGPT。

3月31日,OpenAI曾表示,其在训练人工智能系统时积极致力于减少个人数据。瑞典的隐私监管机构则表示,没有计划禁止ChatGPT,也没有与意大利的监管机构联络。

多家企业限制员工使用ChatGPT

对ChatGPT的警惕不只局限在国家层面。

综合多家媒体报道,三星电子引入聊天机器人ChatGPT不到20天,便曝出机密资料外泄。三起机密资料外泄案件中,其中两起与半导体设备有关,另一起于内部会议有关。

具体为:案件一,三星设备解决方案部门的职员A在半导体设备测量资料库下载软件时,发现源代码出现错误,便将有问题的部分复制到ChatGPT中寻找解决方案。案件二同样发生在设备解决方案部门,职员B将用于识别产品良率的程序代码输入进ChatGPT,要求其优化代码。案件三是该部门的职员C为了制作会议记录,将手机上的会议内容转换为文档,之后将文档输入进ChatGPT。

据传前两起案件已分别导致三星公司的半导体设备测量资料、产品良率等机密内容录入到ChatGPT的学习资料库中。三星表示,为了避免这种情况再次发生,他们已经告知员工谨慎使用ChatGPT。如果后面仍发生类似事故,将考虑禁止在公司内网上使用ChatGPT。

据报道,限制员工使用的不止三星。数据安全服务Cyberhaven检测到并阻止了其客户公司160万名员工中4.2%的人将数据输入ChatGPT的请求,因为存在泄露机密信息、客户数据、源代码或监管信息的风险。此外,摩根大通也已经限制员工使用ChatGPT;亚马逊、微软和沃尔玛也已向员工发出警告,要求员工谨慎使用生成式 AI 服务。

ChatGPT大面积封号?

就在ChatGPT遭遇封杀和泄密的同时,一场大规模的封号又忽然到来。

4月2日,各个社交平台都流传着这样的消息:ChatGPT官方大面积封号,尤其针对亚洲用户。

根据搜集反馈,并非所有账号都受到影响:有些可以顺利登录,有些只能登录手机端,有些手机和PC端都无法登录。

有部分网友猜测,OpenAI此次出现大规模封号的原因可能在于,一是许多账号是用程序批量注册的,一台机器用一个IP在短时间内注册了大量账号;二是出现API滥用的情况,例如,在不支持的地区使用了ChatGPT API,或者利用多个账号获取API并对外提供服务。另有分析称,也可能是由于访问量过大造成的技术问题所致,OpenAI此前曾出现过宕机问题。

针对这个问题,ChatGPT也作了回答。

尽管如此,但ChatGPT的大规模封号行动似乎已经开始了。

据市场统计,已有数百万用户的账号受到了影响。在新用户注册方面,目前注册网页已经无法进入,更为关键的是很多收码平台近期已经关闭。

无法忽视的数据安全问题

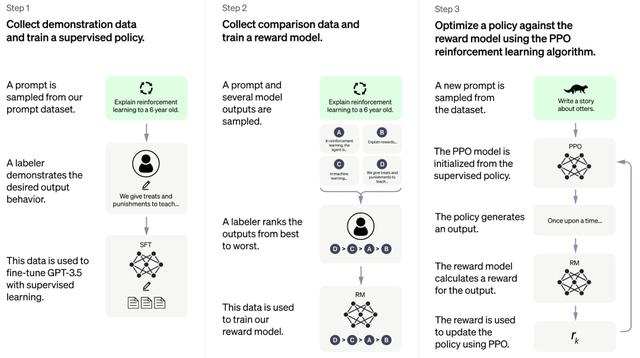

ChatGPT的成功,离不开大数据的帮助。庞大的数据训练,造就了ChatGPT强大功能,但这也意味着,ChatGPT实际上在不断地接触各种对话,其中可能包含相关的敏感信息。每次对话,都有数据被泄露的风险。

据界面新闻,ChatGPT引发的数据安全包括了三方面的隐患。首先是ChatGPT获取数据合法性的问题。训练像ChatGPT这样的大型语言模型需要海量自然语言数据,其训练数据的来源主要是互联网,但开发商OpenAI并没有对数据来源做详细说明,数据的合法性就成了一个问题。

其次,是ChatGPT使用过程造成的数据泄漏问题。用户为了完成某项任务或达到某个目的,在使用ChatGPT过程中,可能会输入一些敏感数据、商业秘密甚至是机密信息,稍不留神,就会造成数据泄漏。

最后,是ChatGPT的数据可能被恶意使用。OpenAI首席技术官米拉·穆拉蒂(Mira Murati)曾表示,可能会有人利用ChatGPT自然语言编写的能力,编写恶意软件,从而逃避防病毒软件的检测;利用ChatGPT的编写功能,生成钓鱼电子邮件;利用ChatGPT的对话功能,冒充真实的人或者组织骗取他人信息等。

多家企业已着手网络安全的搭建

许多安全专家预测,网络犯罪分子开始使用AI聊天机器人编写恶意软件并执行其他恶意活动只是时间问题。

据报道,在此背景下,已经有公司着手进行网络安全的搭建。比如,微软推出一款新的人工智能对话工具Security Copilot(安全副驾),能够帮助网络安全团队防止黑客攻击,并且在遭遇攻击后进行处置。

据介绍,安全副驾使用了AI专业厂商OpenAI公司研发的GPT-4语言模型,以及网络安全领域的专业数据。

国内方面,4月4日,绿盟科技在投资者互动平台表示,公司多年来持续重视人工智能领域研究投入,绿盟科技天枢实验室在安全攻防、安全运营、GPT内容识别等领域开展类GPT技术的研究,此外,基于公司多年积累的攻防知识、运营数据与威胁情报,将在今年第三季度发布基于类ChatGPT技术的智能安全服务机器人,全面实现对安全运营的智能化支撑。

3月29日,在360 主办的 2023 数字安全与发展高峰论坛上,周鸿祎发布了360版本的“ChatGPT”。周鸿祎也预计,未来,人工智能大语言模型有可能实现自我进化,自动更新系统和自我升级,或者指数级进化能力,人类将会面临不可预知的安全挑战。

眼下,或许对于网络安全厂商来说,如何搭建GPT时代的安全网络已成为新的课题和挑战。

综合看看新闻、、、界面新闻、蓝鲸财经等

相关文章

猜你喜欢