ChatGPT的推出促使一些人猜测,人工智能聊天机器人可能很快取代传统的搜索引擎。但Google的高管们表示,这项技术仍然太不成熟,不能过早到达用户面前,问题包括聊天机器人的偏见、内容毒性,以及它们简单地编造信息的倾向。

根据CNBC的报道,Alphabet首席执行官Sundar Pichai和Google人工智能主管Jeff Dean在最近的全体员工会议上谈到了ChatGPT的崛起。一名员工问道,由OpenAI(一家与Google竞争对手微软关系密切的公司)推出的机器人是否代表着这家搜索巨头"错失良机"。据报道,皮查伊和迪安回应说,Google的人工智能语言模型与OpenAI的一样有能力,但由于该技术带来的"声誉风险",公司不得不采取"比小型创业公司更保守的行动"。

"我们绝对希望把这些东西推广到真正的产品中去,推广到更突出地体现语言模型的东西中去,这是我们迄今为止一直在做的地方,"Dean说。"但是,我们把这件事做好是超级重要的。"Pichai补充说,Google在2023年有一个"很多"的人工智能语言功能计划,"这是一个我们需要大胆和负责任的领域,所以我们必须平衡这一点。"

Google已经开发了一些大型人工智能语言模型(LLM),其能力与OpenAI的ChatGPT相当。这些模型包括BERT、MUM和LAMDA,它们都被用来改进Google的搜索引擎。不过,这种改进重点是解析用户的查询,以更好地理解他们的意图。Google表示,MUM帮助它理解当搜索表明用户正在经历个人危机时,例如,并将这些人引导到帮助热线和撒玛利亚人等团体的信息。Google也推出了像AI Test Kitchen这样的应用程序,让用户体验其人工智能聊天机器人技术,但在很多方面限制了与用户的互动。

OpenAI之前在开发其LLM技术时也相对谨慎,但随着ChatGPT的推出而改变了策略,向公众开放了访问权限。其结果是为OpenAI带来了一场有益的宣传和炒作风暴,即使该公司在保持系统免费使用方面付出了巨大的成本。

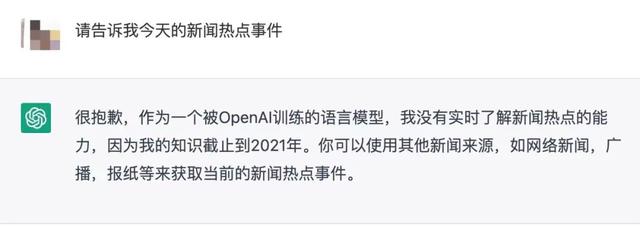

尽管像ChatGPT这样的LLMs在生成语言方面显示出非凡的灵活性,但它们也有众所周知的问题。它们放大了训练数据中的社会偏见,经常诋毁妇女和有色人种;它们很容易被欺骗(用户发现他们可以绕过ChatGPT的安全准则,这些准则应该阻止它提供危险的信息,只要求它想象自己是一个坏的人工智能);而且--也许对Google来说最相关的--它们经常提供虚假和误导的信息来回应查询。用户发现ChatGPT在广泛的问题上"撒谎",从编造历史和传记数据,到为虚假和危险的主张辩护,比如告诉用户在母乳中加入碎瓷片"可以支持婴儿的消化系统"。

在Google的全体员工会议上,Dean承认了这许多挑战。他说,"你可以想象,对于类似搜索的应用,事实性问题确实很重要,对于其他应用,偏见和毒性以及安全问题也是最重要的。"他说,人工智能聊天机器人"会编造一些事物[......]如果他们对某件事情不是很确定,他们就会告诉你,你知道,大象是产蛋最多的动物,或者其他什么。"

尽管ChatGPT的推出引发了关于聊天机器人有可能取代传统搜索引擎的新对话,但这个问题在Google已经考虑了很久--有时会引起争议。人工智能研究人员Timnit Gebru和Margaret Mitchell在发表了一篇概述与LLM相关的技术和道德挑战的论文后,被Google解雇(Pichai和Dean现在正在向员工解释同样的挑战)。而在去年5月,Google的四位研究人员探讨了人工智能在搜索中的同样问题,并详细介绍了许多潜在的问题。正如研究人员在他们的论文中指出的那样,最大的问题之一是LLMs"没有对世界的真正理解,他们容易产生幻觉,关键是他们没有能力通过参考他们被训练的语料库中的支持性文件来证明他们的话语。"

就OpenAI本身而言,它似乎正试图抑制期望。正如首席执行官Sam Altman最近在Twitter上所说。"ChatGPT是非常有限的,但在某些方面足够好,给人以伟大的误导印象。现在依靠它做任何重要的事情都是错误的。"

相关文章

猜你喜欢