原创 Synced 机器之心 2023-04-16 13:05 发表于北京

机器之心分析师网络

作者:王子嘉

一文带你了解Transformer 大家族。

最近,大语言模型军备战争占据了朋友圈的大部分篇幅,关于这些模型能做什么和有什么商业价值,已经有很多文章探讨。然而,作为一个在人工智能领域浸淫多年的小小研究员,我更关注的是这场军备竞赛背后的技术原理,以及这些模型是如何工程化并造福人类的。相比于看这些模型怎样赚钱和工程化以便为更多人带来好处,我更想探索的是这个现象背后的原因,以及在 AI 取代人类之前,我们这些研究员还能为实现 “被 AI 取代然后光荣退休” 做些什么。

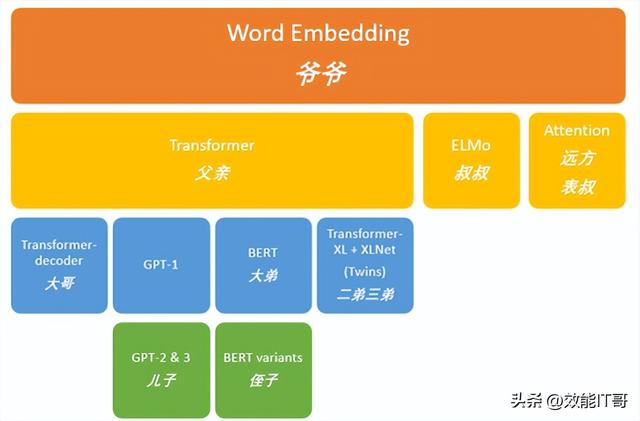

三年前,当 GPT-3 在技术界掀起轩然大波时,我曾尝试以史书的方式剖析 GPT 背后的庞大家族。我按时间顺序梳理了 GPT 背后的技术脉络(图 1),并试图解释 GPT 的成功背后的技术原理。今年,GPT-3 的小儿子 ChatGPT 似乎更加聪明,能够用聊天的方式与人交流,这让更多人了解了自然语言处理领域的最新进展。在这个历史性的时刻,作为 AI 史官,我们或许应该花些时间回顾一下最近几年发生了什么。第一篇文章是以 GPT-3 作为起点,所以这个系列其实是对于后 GPT 时代的记录(后 GPT 书),而在探索 GPT 家族的变化时,我意识到大多数故事都与 Transformer 有关,因此这篇文章的名字就是 Transformer 世家。

图 3. 早期照片 - Attention 与 RNN 强强联合(source: Attention for RNN Seq2Seq Models (1.25x speed recommended) - YouTube)

此时,作为骄傲的皇族直系亲属,Transformer 不认可这种依附他人的工作方式,在论文 “Attention is all you need”(你只需要注意力机制就够了)[5] 中提出了自己独立的方式, 将 “注意力机制” 加了一个字变成了 “自注意力机制”,只用注意力机制就能生成那串数字。我们用中医开药来说明这个变化。最开始的 Attention 机制可以说是每种材料的剂量,但是最终去拿药的时候,药品是存在 RNN 或者 LSTM 这种采药者手里的,我们开出的药方当然也要基于药房(RNN、LSTM)里有什么药。Transformer 做的只是将采药权要了回来(加入了 value 矩阵),然后换了一种开药方的方式(加入 key 和 query 矩阵)。此时,Source 可以看作一个中药铺子的储物箱,储物箱里的药品由地址 Key(药品名)和值 Value(药品)组成,当前有个 Key=Query(药方)的查询,目的是取出储物箱里对应的 Value 值(药品),即 Attention 数值。通过 Query 和储物箱内元素 Key 的地址进行相似性比较来寻址,之所以说是软寻址,指的是我们不只从储物箱里面找出一中药物,而是可能从每个 Key 地址都会取出内容,取出内容的重要性(量的多少)根据 Query 和 Key 的相似性来决定,之后对 Value 进行加权求和,这样就可以取出最终的 Value 值(一副中药),也即 Attention 值。所以不少研究人员将 Attention 机制看作软寻址的一种特例,这也是非常有道理的 [6]。

从此之后,Transformer 正式开始带领家族走向繁荣。

Transformer 继位

其实从图 1 也可以看出,transformer 就是爷爷家族里子嗣最旺盛的一支了,也证实了当年”Attention is all you need” 这个题目狂的确实有理有据。虽然刚刚讲过他提出的自注意力机制是什么,前面那篇文章 (从 word2vec 开始,说下 GPT 庞大的家族系谱 ) 已经详细讲过 transformer 的演化过程了,这里还是快速给新来的同学回顾一下 transformer 这个架构到底是什么。

简单来说,我们可以将 Transformer 看作一个 “演员”,对这个 “演员” 来说,编码器就像是演员的记忆,负责将台词转化为一个中间表示(抽象成脑海里我们不知道是什么的东西,也就是演员的理解),而解码器则像是演员的表演,负责将脑海里的理解转化成荧幕上的展示。这里面最重要的自注意力机制则充当了演员的专注力,能够自动调整演员在不同位置的注意力,从而更好地理解所有台词,使其在不同的情境中表演得更加自然流畅。

更具体一点来说,我们可以将 Transformer 看作一个大型 “语言处理工厂”。在这个工厂中,每个工人(编码器)都负责处理输入序列中的一个位置(比如说一个字),对其进行加工和转换,然后将其传递给下一个工人(编码器)。每个工人都有一份详细的工作说明书(自注意力机制),其中详细描述了如何处理当前位置的输入以及如何与前面的位置建立关联。在这个工厂中,每个工人都可以同时处理自己的任务,因此整个工厂可以高效地处理大量的输入数据。

Transformer 一登场,直接因为其强大的实力和两个争气的儿子(BERT 和 GPT)毫无悬念的夺下皇位。BERT (Bidirectional Encoder Representations from Transformers) [1] 继承了 Transformer 的 Encoder 部分,赢得了前半程比赛,但是因为其限制性,在通用性上输给了 GPT。老实的 GPT (Generative Pre-trained Transformer)[7-10] 继承了 Decoder 部分,老老实实从头学起,学习人类的交流方式,最终在后半程实现了了反超。

当然,Transformer 的野心显然不止于此,”Attention is all you need”,指的并不只是 NLP 领域。在介绍 GPT 和 BERT 之间的恩怨情仇之前,先看看他们老当益壮的父亲都做了些什么吧。

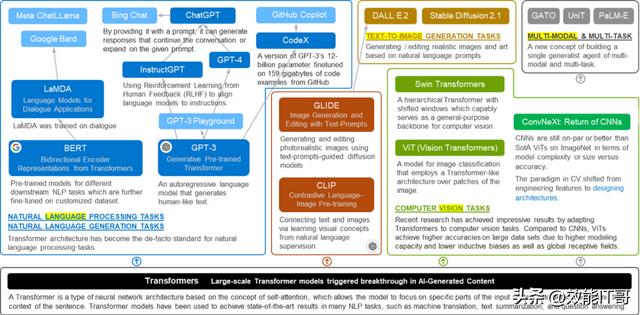

新族谱 - 诸侯林立

“父亲,时代变了。我们家族会因为我的努力,走上真正的辉煌。”

——Transformer

在了解了 Transformer 的机制之后,我们可以来看看在 Transformer 的强力发展下,Transformer 世家现在发展到什么程度了(新族谱)。从前面的 “演员” 例子可以看出,Transformer 代表了一种符合人类逻辑的学习方式,因此它不仅可以处理文字,还可以处理图像。图 2 总结了 Transformer 世家强大的家族背景。除了让 GPT 和 BERT 在最开始的 NLP(自然语言处理)领域继续开疆裂土外,Transformer 还开始涉足计算机视觉领域。它的小儿子(谷歌提出的 ViT 等)也在这个领域发光发热。2021 年,Vision Transformer 迎来了大爆发,一大批基于 Vision Transformer 的工作席卷了计算机视觉任务。自然而然地,作为一个世家,Transformer 家族总会互通有无,连接文本和图像(AI 作画)的 CLIP 应运而生。2022 年底,Stable Diffusion 在 ChatGPT 之前风光无限。除此之外,CLIP 还为 Transformer 世家打开了多模态的新大门。除了文字和图像,文字是否也能做音乐,是否也能画图?多模态和多任务 Transformer 也应运而生。总之,每个领域都是一个诸侯,一个 NLP 领域白手起家的 Transformer,在努力发展后成了可以分封诸侯的 “周王”。

诸侯林立,当是盛世。

图 5. ViT 如何处理图片(source: Are Transformers better than CNN’s at Image Recognition? | by Arjun Sarkar | Towards Data Science)

在那之后,各种基于 Transformer 的模型层出不穷,而且在相应的任务上都取得了超越 CNN 的成绩。那 Transformer 的优势是什么呢,我们先回到电影的例子上,看看 Transformer 和 CNN 的区别:

想象你是一位导演,要拍摄一部电影,你需要给演员安排好位置,把不同的元素放在合适的位置上,比如说,将演员放在适当的背景下,使用合适的光线,使整个画面看起来和谐美观。对于 CNN 来说,它像是一个专业的摄影师,会逐像素地拍摄每一帧画面,然后从中提取出一些边缘、纹理等低层次特征。然后,它将这些特征组合起来,形成更高层次的特征,例如人脸、动作等,最终得到一帧画面。随着电影的进行,CNN 会不断重复这个过程,直到完成整部电影的拍摄。

而对于 ViT 来说,它像是一个艺术指导,会把整个画面看作是一个整体,考虑到背景、光线、颜色等因素,为每个演员分配合适的位置和角度,创造出一个完美的画面。然后,ViT 会把这些信息汇总成一个向量,并使用多层感知器对它们进行处理,最终得到一帧画面。随着电影的进行,ViT 会不断重复这个过程,直到完成整部电影的创作。

回到图像处理任务上,假设我们有一张 224x224 像素的猫的图片,我们想要用一个神经网络对它进行分类。如果我们使用传统的卷积神经网络,它可能会采用多个卷积层和池化层来逐渐缩小图像的大小,最终得到一个较小的特征向量,然后通过全连接层进行分类。这种方法的问题是,在卷积和池化的过程中,我们会逐渐丢失图像中的信息,因为我们不能同时考虑所有像素点之间的关系。此外,由于卷积和池化层的顺序限制,我们无法进行全局的信息交互。相比之下,如果我们使用 Transformer 和 self-attention 机制来处理这个图像,我们可以直接将整个图像视为一个序列,并对它进行 self-attention 计算。这种方法不会丢失任何像素点之间的关系,并且可以进行全局的信息交互。

此外,由于 self-attention 计算是可并行化的,因此我们可以同时处理整个图像,大大加快了计算速度。举个例子,假设我们有一个句子:“I like to eat ice cream”, 其中包含 6 个单词。现在假设我们正在使用一个基于自注意力机制的模型来理解这个句子,Transformer 可以:

最小化每层的总计算复杂度:基于自注意力机制的模型中,我们只需要计算每个单词与所有其他单词之间的注意力权重,这样每一层的计算量只取决于输入长度而不是隐藏层的大小。在这个例子中,输入长度为 6 个单词,因此每一层的计算复杂度只取决于这 6 个单词的数量。最大化可并行化的计算量:基于自注意力机制的模型可以同时计算每个单词与其他所有单词之间的注意力权重,因此计算可以高度并行化,从而加速模型的训练和推断。然而,ViT 需要大规模数据集和高分辨率图像才能发挥其全部潜力 ,因此,虽然 Vision Transformers 在 CV 领域表现不凡,CNN 在计算机视觉领域的应用和研究仍然更为广泛,并且在目标检测和分割等任务中具有优势 。

但是没关系,你做的已经够好了,你父亲涉足 CV 的初衷也不是为了取代 CNN,他有更宏大的目标。

这个目标的基础,就是前面我说的 “此外”。

初露峥嵘 - CLIP [13]

前面我说过,Transformer 还有更宏大的目标,那就是 “大模型”,超级超级大的模型。除了我在前一篇文章里说的 transformer 可以更好地获得全局信息外,更小的计算复杂度和更好的并行度成为了支撑大模型的基础。

2021 年,除了 Vision Transformer 有了长足进展以外,GPT 那一支还在紧锣密鼓的筹备 GPT3.5,闲不下来的劳模 Transformer 又引领了一个新的高潮 —— 连结文本和图像。这个高潮也为 “大模型” 计划打响了除 NLP 领域外的第一枪。而此时,Transformer 在视觉任务上的缺点,在这里反而变成了优势。”ViT 需要大规模数据集和高分辨率图像才能发挥其全部潜力 “如果换个说法,就是 “ViT 可以处理大规模数据集和高分辨率图像”。

老规矩,先说 CLIP 是什么。

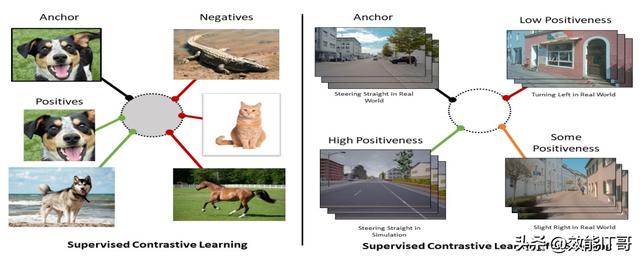

CLIP 的全称是 Contrastive Language-Image Pre-Training,很明显其基本思想就是传统 CV 领域里的对比学习 (Contrastive learning)。当我们学习新知识时,我们会阅读不同的书籍和文章,获取大量的信息。但是,我们并不是只记住了每个书籍或文章中的所有单词和句子。相反,我们会试图找到这些信息之间的相似性和区别。例如,我们可能会注意到在不同的书中,某个主题的描述方式和关键概念的表述方式可能会有所不同,但它们所描述的概念本质上是相同的。这种寻找相似性和区别的方式就是对比学习的基本思想之一。我们可以将每本书或文章看作不同的样本,而相同主题的书籍或文章可以被视为来自同一类别的不同实例。在对比学习中,我们会训练模型来学习如何区分这些不同类别的样本,以此来学习它们的相似性和区别。

接下来更学术一点,假设你想训练一个模型来识别汽车品牌。你可以有一组带标签的汽车图像,每个图像都有一个品牌标签,例如 “奔驰”、“宝马”、“奥迪” 等等。在传统的监督学习中,您可以将图像和品牌标签一起输入模型,并让模型学习如何预测正确的品牌标签。

但在对比学习中,你可以使用未标记的图像来训练模型。假设你有一组未标记的汽车图像,你可以将这些图像分为两组:正样本和负样本。正样本是同一品牌的不同角度的图像,而负样本是不同品牌的图像。接下来,就可以使用对比学习来训练模型,以便将同一品牌的正样本彼此靠近,而将不同品牌的负样本彼此远离。这样,模型可以学会从图像中提取品牌特定的特征,而不必明确地告诉它每个图像的品牌标签。

很明显,这是一个自监督学习模型,CLIP 也是一个类似的自监督学习模型,只不过它的目标是将语言和图像联系起来,从而使计算机能够理解文本和图像之间的关系。

想象你正在学习一组词汇表,其中每个单词都有其定义和相应的图像。对于每个单词和其对应的图像,你可以将它们视为一对(pair)。你的任务是找出这些单词和图像之间的相互关系,即哪些单词与哪些图像匹配,哪些不匹配。

如图 6 所示,对于对比学习算法而言,这些单词和图像对就是所谓的 “anchor”(锚定样本)和 “positive”(正样本)。“anchor” 指的是我们想要学习的对象,而 “positive” 则是与 “anchor” 匹配的样本。与之相对的是 “negative”(负样本),即与 “anchor” 不匹配的样本。

在对比学习中,我们将 “anchor” 和 “positive” 组成一对,并尝试将它们区分开来。同时,我们也会将 “anchor” 和 “negative” 组成一对,并尝试将它们区分开来。这个过程可以理解为是在寻找 “anchor” 和 “positive” 之间的相似性,以及在排除 “anchor” 和 “negative” 之间的相似性。

图 8. Stable Diffusion 过程。首先是上面的箭头,一张图片被不断加入噪声,最后变成纯噪声图,然后走下面的箭头,逐渐消除噪声,然后重建最开始的图片。(图源:From DALL・E to Stable Diffusion: how do text-to-image generation models work? | Tryolabs)

值得注意的是,Stable Diffusion 中的扩散过程是一种随机的过程,因此每次生成的图像都会有所不同,即使是相同的文本描述。这种随机性使得生成的图像更加多样化,同时也增加了算法的不确定性。为了让生成的图像更加稳定,Stable Diffusion 使用了一些技巧,如在扩散过程中加入逐步增加的噪声,以及使用多次重构过程来进一步提高图像质量。

Stable Diffusion 在 DALL-E 的基础上有了很大的进步:

分辨率:stable diffusion 可以生成高达 1024×1024 像素的图像,而 DALL-E 目前只能生成 256×256 像素的图像。速度:stable diffusion 需要进行多次迭代才能生成图像,因此速度较慢。DALL-E 则可以一次性生成图像,因此速度较快。灵活性:stable diffusion 可以对现有的图像进行扩画、修补和变化,而 DALL-E 只能从文本提示生成图像。真实性:stable diffusion 可以生成更真实和细致的图像,尤其是在复杂和抽象的描述下。DALL-E 则可能生成一些不符合物理规律或常识的图像。这也是为什么 DALL-E-2 也将扩散模型加入到其模型中去了。

潜伏的强者 - GPT3.5 [18]

& Instruct GPT [19]

在其他诸侯把改革开展的如火如荼的时候,GPT 这一支也一直在默默努力着。开头说过,GPT-3 刚发布的时候已经有很强的能力了,但是使用方式不那么 “非技术人员友好”,所以掀起的浪花都是在技术界,这些本就不算很热烈的浪花,又因为它不低的收费而日益消散。

Transformer 十分不满意,GPT 想了想,那就改革!

第一个响应改革号召,迈出第一步的是 GPT 3.5:

“我比较笨,想不出什么好办法改革,那就先把基础打牢吧。”

于是,GPT3.5 基于 GPT-3 ,使用了一种叫做 Text Code 的训练数据,即在文本数据的基础上,增加了一些编程代码的数据。简单来说,就是用了更大的数据集。这样可以使模型更好地理解和生成代码,提高模型的多样性和创造性。Text Code 是一种基于文本和代码的训练数据,它是由 OpenAI 从网上收集并整理的。它包括两部分:文本和代码。文本是一些用自然语言描述的内容,如文章、评论、对话等。代码是一些用编程语言编写的内容,如 Python、Java、HTML 等。

Text Code 训练数据可以使模型更好地理解和生成代码,提高模型的多样性和创造性。例如,在编程任务中,模型可以根据文本描述生成相应的代码,并且代码具有较高的正确性和可读性。在内容生成任务中,模型可以根据代码描述生成相应的文本,并且文本具有较高的一致性和有趣性。Text Code 训练数据也可以使模型更好地处理多语言,多模态,多领域的数据和任务。例如,在语言翻译任务中,模型可以根据不同语言之间的对应关系,进行准确和流畅的翻译。在图像生成任务中,模型可以根据文本或代码描述,生成相应的图像,并且图像具有较高的清晰度和逼真度。

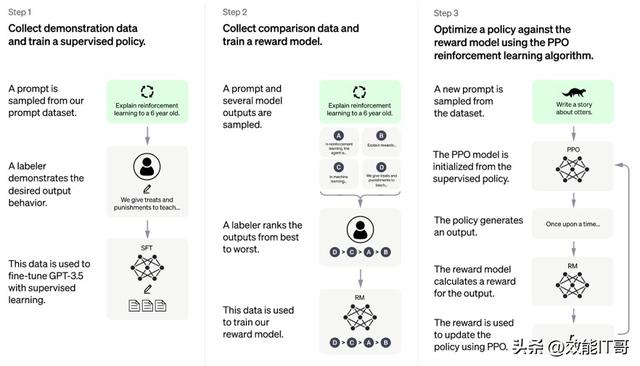

第二个响应号召的是 Instruct GPT,他发现了新的问题:

“要想跟人类打成一片,我们就需要更有效的听取他们的意见。”

于是,出现了大名鼎鼎的新晋外援,也就是 RLHF 训练策略。RLHF 是一种基于强化学习的训练策略,它的全称是 Reinforcement Learning from Human Feedback。它的核心思想是在训练过程中,给模型提供一些指令,并根据模型的输出给予奖励或惩罚。这样可以使模型更好地遵循指令,提高模型的可控性和可信度。其实 GPT-3.5 也有人类反馈(Human Feedback),那加入了强化学习(Reinforcement learning)之后,发生了什么改变呢?

GPT3.5 的人类反馈是直接用于微调模型的参数,而 Instruct GPT 的 RLHF 是用于训练一个奖励模型,然后用这个奖励模型来指导模型的行为。GPT3.5 的人类反馈是基于单个输出的评价,而 Instruct GPT 的 RLHF 是基于多个输出之间的比较。GPT3.5 的人类反馈只进行了一次,而 Instruct GPT 的 RLHF 可以进行多次迭代,不断收集新的比较数据,训练新的奖励模型,优化新的策略。也就是说,更少的人力投入,但是给模型带来了更大的收益。

图 11. SAM 模型架构

至于结果,前面提到的其强大能力已经证实了这个想法的可行性。但是,不得不提的是,虽然 SAM 确实不再需要重新训练模型,但是像 chatGPT 刚推出时一样,他还是有一些限制的。在论文的 Limitation 部分,作者页明确指出了 SAM 的一些局限性和不足,比如在细节、连通性、边界等方面的缺陷,以及在交互式分割、实时性、文本提示、语义和全景分割等任务上的挑战,同时也承认了一些领域专用工具的优势。

举个例子,我在 demo 里做了两个简单的测试:一个是医疗图像领域的病灶检测,因为病灶太小了,很难检测到;第二个是人像切割,切出来的人像乍看不错,但是发丝还是不是很自然,仔细看还是能看出来切割痕迹。

当然,这毕竟是一个很好的开始,这小哥俩创业未半,还在努力,要啥自行车?所以,这场夺嫡的结果如何,还是让我们拭目以待吧!

总结

Transformer 世家的庞大家族显然不是这一篇文章可以说明的,当谈到基于 Transformer 的成果时,我们可以看到这个领域的持续创新:Vision Transformer(ViT)展示了 Transformer 在计算机视觉领域的成功应用,它可以直接处理图像像素数据,不需要手工特征工程。DALL-E 和 CLIP 则将 Transformer 应用于图像生成和图像分类任务,展示了它在视觉语义理解中的优越表现。Stable Diffusion 则提出了一种稳定的扩散过程,可以对概率分布进行建模,这可以应用于图像分割、生成等任务。这些成果共同揭示出 Transformer 模型的广泛应用前景,让我们不得不承认,未来某一天,可能真的”Attention is all you need”。

总之,我们可以从这些成果中看到人工智能领域持续创新的活力。无论是 GPT 还是 BERT,还是 Vision Transformer、DALL-E、CLIP、Stable diffusion 等,这些成果都代表着人工智能领域的最新进展。

而大考(ChatGPT)当前,现在的情景大概是这样的:

学霸们这学期好好上课,翻开书本就能回想起当时那节课老师说这个知识点时的音容笑貌,甚至开始规划下学期的学习计划。

伪学霸们天天到课,占据前排,打开课本却是一脸懵逼,开始跟学渣们一起 “一天一本书,一周一学期”,唯一的区别就是课本不是全新的,对课本内容还有一点点记忆,不算是在完全的学习新知识。

至于真正的学渣们……

“知识来,知识来,知识从四面发八方来”

其实我倒觉得,不管是伪学霸还是学渣,都应该在期末考面前保持冷静,看看这学期讲了什么,找学霸们借一下笔记,甚至可以选择缓考。对学霸们来说,快是水到渠成的。对伪学霸和学渣们来说,快是有害的。

在人工智能领域的竞争中,持续创新是至关重要的。因此,作为研究员,我们应该密切关注这个领域的最新发展,并且保持谦虚和开放的心态,以促进人工智能领域的不断进步。

参考文献

[1] Mikolov, Tomas; et al. (2013). "Efficient Estimation of Word Representations in Vector Space". arXiv (https://en.wikipedia.org/wiki/ArXiv_(identifier)):1301.3781 (https://arxiv.org/abs/1301.3781) [cs.CL (https://arxiv.org/archive/cs.CL)].

[2] Mikolov, Tomas (2013). "Distributed representations of words and phrases and their compositionality". Advances in neural information processing systems.

[3] Matthew E. Peters, Mark Neumann, Mohit Iyyer, Matt Gardner, Christopher Clark, Kenton Lee, & Luke Zettlemoyer. (2018). Deep contextualized word representations.

[4] Bahdanau, Dzmitry, Kyunghyun Cho, and Yoshua Bengio. "Neural machine translation by jointly learning to align and translate." arXiv preprint arXiv:1409.0473 (2014).

[5] Vaswani, Ashish, et al. "Attention is all you need." Advances in neural information processing systems 30 (2017).

[6] attention 机制及 self-attention (transformer). Accessed at: https://blog.csdn.net/Enjoy_endless/article/details/88679989

[7] Radford, Alec, et al. "Improving language understanding by generative pre-training." (2018).

[8] Radford, Alec, et al. "Language models are unsupervised multitask learners." OpenAI blog 1.8 (2019): 9.

[9] Brown, Tom, et al. "Language models are few-shot learners." Advances in neural information processing systems 33 (2020): 1877-1901.

[10] GPT-4 (openai.com)

[11] Devlin, Jacob; Chang, Ming-Wei; Lee, Kenton; Toutanova, Kristina (11 October 2018). "BERT: Pre-training of Deep Bidirectional Transformers for Language Understanding". arXiv:1810.04805v2 [cs.CL].

[12] Dosovitskiy, Alexey, et al. "An image is worth 16x16 words: Transformers for image recognition at scale." arXiv preprint arXiv:2010.11929 (2020).

[13] Radford, Alec, et al. "Learning transferable visual models from natural language supervision." International conference on machine learning. PMLR, 2021.

[14] Zheng, Laura, Yu Shen, and Ming C. Lin. "Exploring Contrastive Learning with Attention for Self-Driving Generalization."

[15] Reddy, Mr D. Murahari, et al. "Dall-e: Creating images from text." UGC Care Group I Journal 8.14 (2021): 71-75.

[16] Ramesh, Aditya, et al. "Hierarchical text-conditional image generation with clip latents." arXiv preprint arXiv:2204.06125 (2022).

[17] Rombach, Robin, et al. "High-resolution image synthesis with latent diffusion models." Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. 2022.

[18] Chen, Xuanting, et al. "How Robust is GPT-3.5 to Predecessors? A Comprehensive Study on Language Understanding Tasks." arXiv preprint arXiv:2303.00293 (2023).

[19] Ouyang, Long, et al. "Training language models to follow instructions with human feedback." Advances in Neural Information Processing Systems 35 (2022): 27730-27744.

分析师介绍:

本文作者王子嘉,戴尔科技集团首席技术官办公室人工智能科学家,英国帝国理工学院Al专业毕业,主要研究方向为计算机视觉、3D重建、AIGC等,重点关注在相关领域进行新技术的探索与创新,在新Al技术赋能的数据隐私保护以及AIGC技术在数据管理上的应用等方向上做过很多尝试与创新。于2019年加入戴尔科技集团,在此期间,已在相关领域发表论文5篇、专利139项。

关于机器之心全球分析师网络 Synced Global Analyst Network

机器之心全球分析师网络是由机器之心发起的全球性人工智能专业知识共享网络。在过去的四年里,已有数百名来自全球各地的 AI 领域专业学生学者、工程专家、业务专家,利用自己的学业工作之余的闲暇时间,通过线上分享、专栏解读、知识库构建、报告发布、评测及项目咨询等形式与全球 AI 社区共享自己的研究思路、工程经验及行业洞察等专业知识,并从中获得了自身的能力成长、经验积累及职业发展。

感兴趣加入机器之心全球分析师网络?点击阅读原文,提交申请。

阅读原文

相关文章

猜你喜欢

成员 网址收录40400 企业收录2981 印章生成237682 电子证书1054 电子名片60 自媒体53616