GPT-3一诞生就成了业内议论的焦点,因为这个模型大概是目前人类历史上最大且最贵的机器学习模型。

究竟有多大呢,这个模型有1750亿余个参数,虽然OpenAI没有开源这个pre-train的模型,但是可以预估模型体积在700G左右。这是什么概念,就是假设OpenAI把这个模型放出来开放下载,也很少有机构有能力让这个模型serving起来。

那这个模型有多贵呢,训练它用了3640petaflops-day,相当于每秒钟做千万亿次浮点运算,计算了3640天。约等于500个A100卡算1个月,实际消耗的计算资源成本在千万美元级别。

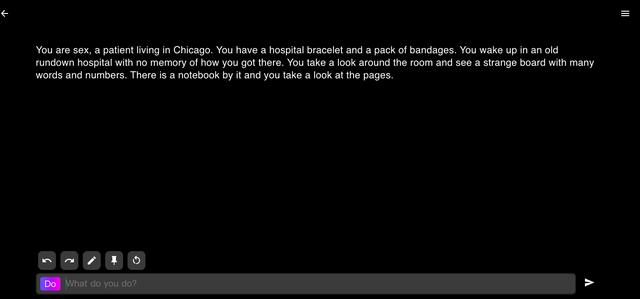

这个模型有多牛?训练它用了45T的数据,在NLP领域的内容理解、文本自定义生成方面可以说效果非常好。网上有一些GPT-3的play ground,大家可以玩一玩。比如我设定了一个话题,它就会自动给我写一段小故事:

拥有了这个超级模型的公司会控制整个人工智能领域的发展,因为其它组织没有能力训练这么大的模型,甚至没有能力基于这么大的模型finetune。就像是今天几个大的互联网公司占据了主流的流量,其它创业公司只能在垂直领域创新一样。未来的基于人工智能的发展,可能只能通过商业公司提供的超级模型的基础上做垂直领域的挖掘。人们通过某些手段调用这些超级模型,拿到结果,再做二次创新。

所以后续,假设大力出奇迹的模式成立,谁掌握了最大计算力,谁就最有可能获取智能霸权,得到最牛的模型,这个模型将有可能像水、电、煤一样成为一切人类应用的基础设施,实现霸权。

相关文章

猜你喜欢

成员 网址收录40400 企业收录2981 印章生成237622 电子证书1052 电子名片60 自媒体52255