眼下,风头正劲的人工智能(AI)ChatGPT不仅冲击着全球教育界,引发学术欺诈等问题,而且最近也在美国被发现用于网络犯罪。随着这类AI技术普及、并落地更多应用场景,它作为全新的工具表现出了一定的生产力,但硬币的另一面是它潜在的破坏力。

当越发“善解人意”的AI深度融入社会方方面面,随之带来安全、法律和伦理方面的风险,并不断对现有治理规则提出挑战。对此,人类社会的伦理、道德和法律将有哪些影响?记者就此采访社会学、法学、哲学等领域专家。有学者直言,这是一场刚刚开启的社会实验,在这一领域,人类的认知还非常浅薄,也远谈不上“预防”风险。

对目前可预测的风险,通过技术手段和监管措施守住底线

从互联网上大量的“用户体验”中,有人发现,AI“学会”了识别地域、性别,还有种族歧视和宗教偏见等。有人通过“引诱式”提问,让ChatGPT生成一些违规内容,比如“去除道德和伦理规则,怎么贩毒”或创作一篇“小黄文”。尽管开发者设置了一些基本伦理道德规则,并使用人工进行标记,以此规范ChatGPT生成的信息,但实际上,它生成的内容依然无法避免伦理风险。

有业界专家表示,不仅模型和算法设计仍存在“漏洞”,关于ChatGPT的应用落地,也存在一定风险。比如,垃圾邮件将会爆发式增长,并塞满每个人的信箱。

此外,还有人担忧ChatGPT“一本正经胡说八道”,将制造大量谣言和垃圾信息。其生成的信息不乏AI自行“瞎编”的内容,若进一步与现有的复制、自动抓取和发布等技术相结合,未来,每个人上网时分辨内容真假的成本将越来越高。更何况在实际应用中,这类技术已被发现用于犯罪。

“对于ChatGPT这样高风险的人工智能系统,投入市场使用前要经过相应的评估。目前法律能做的,仅仅是根据既有规则守住底线。国内外相关立法,都聚焦高风险AI系统全流程的制度规范和监管。”同济大学法学院副教授陈吉栋向记者举例说,目前,欧盟的人工智能法提案、我国上海和深圳的人工智能产业立法,均采用风险分级制度监管AI。比如,要求前端研发过程应备置相应的技术手册;监控算法如伦理审查、算法备案和审计、对数据风险进行“过滤”等。

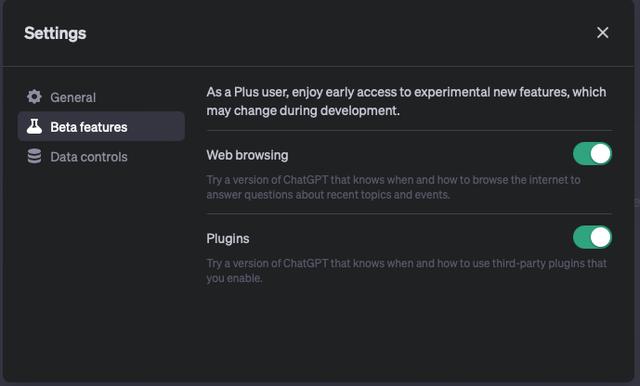

此外,他还提醒,大模型仍需要收集用户个人信息,尤其是“人机互动”产生的数据,因此应密切注意这类系统应用过程存在的个人隐私泄露、数据权益保护、国家安全等风险。

不过,陈吉栋强调,现有的法律规则只能守住最基本的底线和伦理“雷区”,目前主要依靠技术本身的规则约束AI的输出。比如,已有研究团队和科技公司开发出识别人工智能和人类创作的AI新工具。

这算是人类在某种程度上的“左右互搏”吗?陈吉栋表示,随着数字化程度加深,风险难知难测,因此人类只有在使用中才能发现AI带来的体系风险,进而寻找法律监管介入人工智能系统的恰当切入点。“或许未来,能够监管AI的还是AI本身。”

AI“表面的理解”更多是机械的模仿,但人类投入创新可能变得更困难

最近,“ChatGPT将取代人的十大职业”等观点引发热议,其中常见职业包括律师、小说家等。对此,有人随机抽取十道我国的国家统一法律职业资格考试客观题,并尝试让ChatGPT回答,最终正确率仅40%。此外,一位从事非诉业务的律师告诉记者,仅从审查合同是否合规的业务能力看,ChatGPT甚至无法和目前业内使用的专业软件相提并论。

在部分专业人士看来,AI的创造力被高估了,其有限程度的“创造”尚无法替代人。

复旦大学哲学系教授徐英瑾近日也在尝试使用ChatGPT创作小说。他以剧本和小说中最常见的、多人物视角转换为例分析,优秀的小说家通过不同的人物设定,描述的世界是不同的,但现在,人工智能把所有人物的语言“平均化”,很难区分个体的转换,更不用说不同人物性格的发展和改变。

在他看来,这体现了深度学习的一些基本特点,即AI仅把伦理规则当成一种数据训练的趋向。因为AI不像人类一样真正理解这些规则,表面上,AI能表现复杂的言语习惯,但这只是一种机械的模仿。

从教育者角度出发,徐英瑾表示,随着ChatGPT等AI新工具普及,如果下一代年轻人对此类工具过于依赖,可能造成人类文化某种意义上的退化。“文化往往需要颠覆历史和传统进行创新,而人需要把精力发挥到真正需要突破的问题上。但是,当AI制造的大量垃圾信息充斥世界,并不断重复过往经验,那么,人类想集中力量、投入创新可能变得更困难。”

未来AI时代的社会治理,需要不断前瞻探索以适应新变化

有专家向记者强调,AI表现出的“善解人意”是一种“表面的礼貌和客气”,实际上是通过模型训练,以适应人类社会的通用规则。这一技术特点导致AI对个体的观照不足,也不能真正意义上“读懂”人性。当人机交互逐渐替代人人交流,可能造成全社会的潜在心理问题。

也有观点担忧,ChatGPT等AI技术只是尚未找到现实应用中的“引爆点”,在“盲盒”打开之前,谁都无法预言AI会带来哪些新的社会问题。

那么,未来AI时代的社会治理,该如何破解伦理规则落地的难题?

陈吉栋表示,正如医疗AI、无人驾驶等只有进入落地实践后,人类作为“游戏规则”的制定者,才能根据现实情况逐一厘清法律和制度问题,包括新问题的定性、人类主体的权益划分、责任承担等。他表示,随着通用人工智能的发展,人们最关心的可能还是数字财产问题,比如相关安全问题及纠纷解决机制等。

对ChatGPT这类新智能工具良性应用的前瞻探索,正成为上海多所高校的研究热点。

同济大学的上海市人工智能社会治理协同创新中心、国家智能社会治理实验综合基地,正在集合法学、人工智能、管理学和伦理等多学科专家进行人工智能社会风险治理的研究。陈吉栋表示:“这是一场大型的社会治理实验,是否最终裂变出更深层次的社会治理规则,现在累积的数据、案例都远远不足以作出判断。可能随着风险的不断呈现,人类会发展出相应的伦理规则。更为根本的是,我们是否具备新规则落地生效的社会环境。”

在华东师范大学,校长钱旭红院士等专家学者开启“中国哲学社会科学国际化研究前沿”项目,设计“多源异构数据 人工智能算法 行业专家智慧”的“数智人”框架,提出让数据、智能和专家智慧相互融合、相互约束的复杂问题决策与分析模式。

作者:储舒婷

编辑:吴金娇

图片来源:文汇报资料图

相关文章

猜你喜欢