作者 | 王文广

出品 | 新程序员

自ChatGPT推出以来,不仅业内津津乐道并纷纷赞叹自然语言处理(Natural Language Processing, NLP)大模型的魔力,更有探讨通用人工智能(Artificial general intelligence,AGI)的奇点来临。有报道说Google CEO Sundar Pichai发出红色警报(Red code)并促使了谷歌创始人佩奇与布林的回归,以避免受到颠覆性的影响[1][2][3]。同时,根据路透社的报道,ChatGPT发布仅两个月就有1亿用户参与狂欢,成为有史以来用户增长最快的产品[4]。本文以ChatGPT为契机,介绍飞速发展的自然语言处理技术(如图1所示)。

图6 变换器网络架构[7]

该网络在当时并未引起轰动,仅仅如蝴蝶扇动了几下翅膀。但随着时间的推移却引发了蝴蝶效应,最终掀起了自然语言处理乃至人工智能的海啸。限于篇幅,这里简要介绍变换器网络的重要特点。

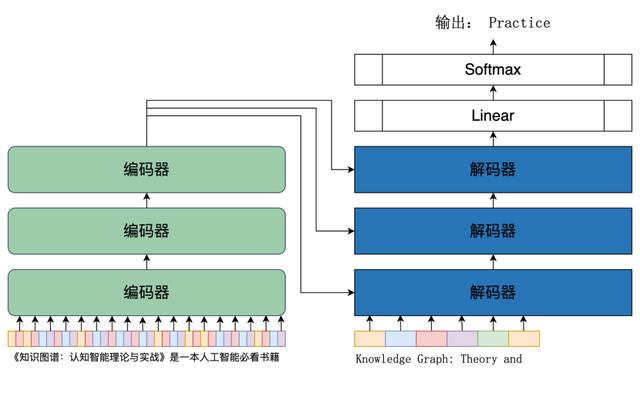

变换器网络完全依赖于注意力机制,支持极大的并行化。如图6所示,变换器网络由两部分组成,左边是编码部门,有N个编码器组成;右边是解码部分,由N个解码器组成。编码部分将输入序列(文本)进行编码,解码部分以自回归的方法不断解码下一个词元,最终完成从序列到序列的变换并输出。

图7展示了一个中文到英文翻译的序列到序列的实例——将中文“《知识图谱:认知智能理论与实战》是一本人工智能必看书籍”翻译为英文“Knowledge Graph: Theory and Practice of Cognitive Intelligence is a must read book on AI.”。翻译也是最典型的序列到序列的语言任务,事实上也正是这个任务在1949年开启了自然语言处理这门学科,同时在变换器网络的论文中,用的评测也正是翻译任务。

图9 自注意力实例,《知识图谱:认知智能理论与实战》图3-15(P124)[6]

值得一提的是,变换器网络是近5年自然语言处理乃至全部人工智能高速发展的最大功臣!近年来叱咤风云的BERT就是以变换器网络的编码器为基础的,而 GPT 则是以其解码器为基础的。

图10 自然语言大模型的奋进五载

机构方面,Google和DeepMind发布了BERT、T5、Gopher、PaLM、GaLM、Switch等等大模型,模型的参数规模从1亿增长到1万亿;OpenAI和微软则发布了GPT、GPT-2、GPT-3、InstructGPT、Turing-NLG 和 M-Turing-NLG等等大模型,模型的参数规模从1亿增长到5000亿;百度发布了文心(ERNIE)系列,包括 ERNIE,ERNIE2.0,ERNIE3.0,ERNIE 3.0-Titan,参数规模从3亿增长到2600亿。总体来说,随着模型的增长,有能力训练和发布大模型的在减少。除了上面提到的几家之外,其他的还有芯片大厂Nvidia靠充足的算力,大力出奇迹,国内的智源研究院和鹏程实验室等机构也发布了悟道、盘古等大模型,表现不俗。

大模型成本高昂,时间成本和经济成本都巨大。以模型参数为1750亿的GPT-3为例,用于训练模型的原始语料文本超过100TB(压缩包为45TB),包含了网页、书籍、英文维基百科等。原始语料文本经过处理后,形成了超过5000亿个词元(西方语言的词,中文的字等)的训练语料。GPT-3模型的训练和评估采用的算力是微软和OpenAI一起打造的超级计算集群,集群有28.5万核CPU,1万个V100 GPU,以及400Gbps的网络带宽。建造这个超级计算集群的费用超过20亿元。如果租用微软或其他云厂商的集群来训练GPT-3,训练一次GPT-3需要耗费估计从280万到540万美元不等(价格因不同云厂商而有所不同)。因训练花费不菲,在 GPT-3的论文《Language Models are Few-Shot Learners》中提到“发现了bug但由于训练费用问题而没有重新训练模型(Unfortunately, a bug in the filtering caused us to ignore some overlaps, and due to the cost of training it was not feasible to retrain the model.)”[11]。

算法的融会贯通自然语言处理在这五年的高速发展,除了模型越来越大,训练语料越来越多之外,核心还是多种不同类型的人工智能技术的高速发展,以及在自然语言处理领域将对这些技术的融会贯通。这些人工智能技术包括但不限于语言模型、对话系统(Conversational AI)、思维链(Chain of Thoughts)、强化学习(Reinforcement Learning)和人类反馈强化学习 (Reinforcement Learning from Human Feedback,RLHF)、情境学习(In-context learning)、无监督学习(Unsupervised Learning)等等。除此之外,算力的增长、大数据处理技术的发展也提供了必不可少的支撑。

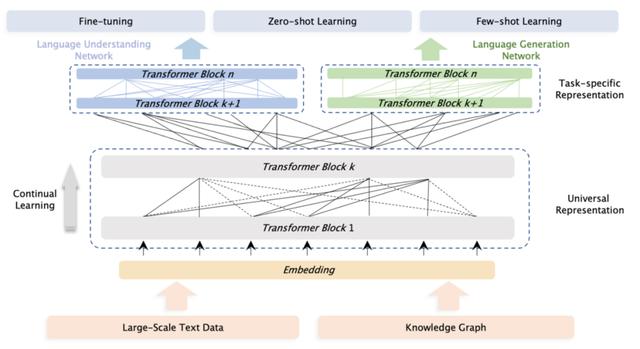

语言模型这里简要介绍三类代表性的语言模型,分别为BERT所使用的掩码语言模型、GPT系列所使用的自回归语言模型以及ERNIE系列所使用的引入了知识图谱等专家知识的语言模型。

掩码语言模型(Masked language model,MLM)是一种双向语言模型[6][8],模拟了人类对语言的认知的双向语言模型。一个例子是,人们快速读阅时,些许的字文错误并不会影响理解,这是由于人们会自动补全。掩码语言模型正是模拟了这一特点,比如对于“一枝红杏出墙来”这句话,将其一部分掩盖住后,原句变为“一枝红⬛出墙来”,如何判断“⬛”掩盖的部分?人们能够自然地意识到“⬛”掩盖的是“杏”。而掩码语言模型则是为了让模型能够像人一样“猜出”被掩盖的部分。BERT通过变换器网络的编码器来实现掩码语言模型。同时,如图11所示,BERT使用了多任务学习方法来从大规模语料中训练出模型,并在具体任务中进行微调(Fine-Tuning)。

图12 GPT模型架构及多任务训练示意图[9]

ERNIE在采用了 BERT 类似的模型架构之上,加入了知识图谱[6],使得模型能够用先验知识来更好地理解语义,其架构如图13所示[10]。还是以“一枝红杏出墙来”为例,ERNIE能够更好地理解“红杏”,并知道它是一种“植物”。也因此,相比于BERT和GPT,ERNIE能够在更小的模型下获得相对更好的效果。尤其值得一提的是,这点在中文场景中更加明显。

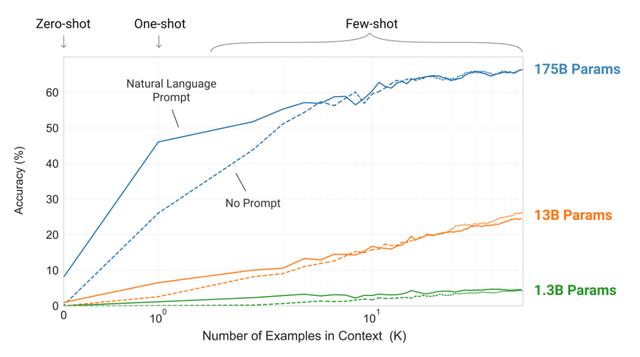

图14 情境学习实例,使用了ChatGPT

从图15可以看出,情境学习的预测结果在大模型的情况下效果表现得非常好,但在小模型的情况下表现糟糕。简单地说,大模型使得情境学习变得有用。这是由于情境学习依赖于语言模型所学习到的概念语义和隐含的贝叶斯推理,而这依赖于大规模预训练模型对潜在概念的学习,从文档级语料学习了长距离依赖并保持长距离的连贯性、思维链和复杂推理等等。也因此,情境学习在大模型之前罕见,可谓连实验室的玩具都谈不上。而在大模型的支撑下,在许多自然语言处理任务的基准测试(如LAMBADA文本理解测试集和TriviaQA问答测试集)中,情境学习相比其他模型也非常具有竞争力。

图19 训练ChatGPT的过程示意图[14]

正是这些技术的总和所展现出的强大能力,ChatGPT 为通用人工智能带来了曙光。许多业内大佬也纷纷为此站台,比如:

微软联合创始人比尔·盖茨在2023年1月11日的Reddit AMA(Ask Me Anything)的问答帖中对一些热门科技概念发表了看法,他表示自己不太看好Web3和元宇宙,但认为人工智能是“革命性”的,对OpenAI的ChatGPT印象深刻[15]。微软也准备再向OpenAI投资100亿美元,并表示旗下全部产品都接入ChatGPT以提供智能服务。

此前力推元宇宙的Meta的态度也有所改变,扎克伯格在2022年度报告投资者电话会议上表示“我们的目标是成为生成式人工智能的领导者(Our Goal is to be Leader in Generative AI)”[16]。面对投资者对元宇宙是否被抛弃的疑问,扎克伯格的回答是“今天专注于人工智能,长期则是元宇宙(AI today and over the longer term the metaverse)”(想想经济学家凯恩斯那句名言“长期来看,我们都死了”吧)。

Google创始人回归并全力支持类似 ChatGPT产品的开发,同时向Anthropic投资3亿美元。Anthropic由OpenAI的多名资深研究人员创立,其产品与OpenAI的类似,如Claude(ChatGPT)和(GPT-3)。

许多学者认为,通用人工智能到来的时间会加速,也许,2035年就是一个通用人工智能的“奇点”时刻。

也许有人认为夸大其词或危言耸听。毕竟,ChatGPT也仅仅展现了语言方面的能力,对其他诸如视觉、语音等完全不涉及。而即使在语言方面,ChatGPT表现弱智的地方也很多,图20就是一个例子(这个问题流传最广的回答是:贾母),深度学习的代表性人物Yann LeCun也激烈批评大语言模型的问题“人们严厉批评大语言模型是因为它的胡说八道,ChatGPT 做了(与语言大模型)同样的事(People crucified it because it could generate nonsense.ChatGPT does the same thing.)”。事实上,这个表现有点像幼儿园的小朋友的“童言无忌”,而这不也正是“智能”的表现么?而解决这个问题有现成的人工智能方法——知识图谱[6]等符号人工智能方法和基于知识的人工智能方法。这些方法在这几年也发展迅速。一旦ChatGPT拥有一个知识图谱来支撑“常识”,其下限将极大地提升[17],“童言无忌”变得成熟,那么语言领域的通用人工智能可谓来临。

图20 ChatGPT关于“贾宝玉娶老婆”的例子

进一步的,跳出自然语言处理,从更广泛的人工智能视角来看,这几年的进展也非常大。比如通过文本提示生成视频的扩散模型(Diffusion Model,DM),在图像生成上提升了视觉保真度,同样引发了视觉领域的爆火出圈;语音合成方面,VALL-E模型支持通过语音提示,合成符合输入语音音色和情绪的逼真声音。特别地,这些不同领域的人工智能,包括视觉、图像处理、语音识别、语音合成、知识图谱、时间序列分析等等,也全部都在采用变换器网络来实现[18]。这使得ChatGPT或类似系统加入语音、视觉等变得容易,进而构建出跨模态的,多才多艺的通用人工智能。

可以想象,未来五年到十年,融合语言、视觉和语音等多模态的超大模型将极大地增强推理和生成的能力,同时通过超大规模知识图谱和知识计算引擎融入人类的先验知识,极大提升人工智能推理决策的准确性。这样的人工智能系统既能够像人一样适应现实世界的不同模态的绝大多数任务,完成任务的水平甚至超越绝大多数的普通人,又可以在各种富有想象力和创造性的任务上有效地辅助人类。

这样的系统正是人们想象和期待了数千年的智能系统,而这也会被称为真正的通用人工智能。进一步,随着人形机器人、模拟人类的外皮肤合成技术等等各类技术的发展,这些技术互相融合,科学幻想中的超人工智能的来临也将成为现实。而在通用人工智能如灿烂阳光洒满每一个角落时,蓦然回顾,会发现AGI的第一道曙光是2022年底的ChatGPT。正所谓“虎越雄关,NLP奋发五载;兔临春境,AGI初现曙光。”

参考文献[1] ChatGPT将代替搜索引擎?谷歌内部发红色警报. 澎湃新闻. https://www.thepaper.cn/newsDetail_forward_21282873

[2] How ChatGPT Suddenly Became Google’s Code Red, Prompting Return Of Page And Brin. Forbes. https://www.forbes.com/sites/davidphelan/2023/01/23/how-chatgpt-suddenly-became-googles-code-red-prompting-return-of-page-and-brin/. 2023.

[3] With Bing and ChatGPT, Google is about to face competition in search for the first time in 20 years. Insider. https://www.businessinsider.com/bing-chatgpt-google-faces-first-real-competition-in-20-years-2023-1

[4] ChatGPT sets record for fastest-growing user base - analyst note。Reuters. https://www.reuters.com/technology/chatgpt-sets-record-fastest-growing-user-base-analyst-note-2023-02-01/. 2023.

[5] Joseph Weizenbaum. ELIZA--A Computer Program for the Study of Natural Language Communication Between Man and Machine.[J]// Communications of the ACM. Vol9. P36–45.

[6] 王文广. 知识图谱:认知智能理论与实战[M] //电子工业出版社, 2022

[7] Ashish Vaswani, Noam Shazeer, Niki Parmar et al. Attention is all you need.[C] //In advances in neural information processing systems. 2017. P5998-6008

[8] Jacob Devlin, Ming-Wei Chang, Kenton Lee et al. BERT: Pre-training of Deep Bidirectional Transformers for Language Understanding.[C] // In Proceedings of the 2019 Conference of the North American Chapter of the Association for Computational Linguistics: Human Language Technologies. 2019. P4171–4186.

[9] Alec Radford, Karthik Narasimhan, Tim Salimans, Ilya Sutskever. Improving language understanding with unsupervised learning. //OpenAI Technical Report. 2018.

[10] Yu Sun, Shuohuan Wang, Shikun Feng et al. ERNIE 3.0: Large-scale Knowledge Enhanced Pre-training for Language Understanding and Generation. arXiv:2107.02137. 2021.

[11] Tom Brown, Benjamin Mann, Nick Ryder et al. Language Models are Few-Shot Learners.[C] // In Advances in Neural Information Processing Systems 33 (NeurIPS 2020). 2020. P1877—1901

[12] ChatGPT passes MBA exam given by a Wharton professor. NBC News. https://www.nbcnews.com/tech/tech-news/chatgpt-passes-mba-exam-wharton-professor-rcna67036. 2023.

[13] Tiffany Kung, Morgan Cheatham, ChatGPT et al. Performance of ChatGPT on USMLE: Potential for AI-Assisted Medical Education Using Large Language Models. doi:10.1101/2022.12.19.22283643. 2022.

[14] ChatGPT: Optimizing Language Models for Dialogue. OpenAI. https://openai.com/blog/chatgpt/. 2022

[15] 比尔·盖茨看好 AI,而非 Web3 和元宇宙. 新浪网. http://vr.sina.com.cn/news/hot/2023-01-13/doc-imxzzfmr4911664.shtml. 2023

[16] Meta Platforms (NASDAQ: META) CEO Mark Zuckerberg: “Our Goal is to be Leader in Generative AI”. Wall Street Reporter. https://www.wallstreetreporter.com/2023/02/02/meta-platforms-nasdaq-meta-q4-2022-earnings-call/. 2023.

[17] Wolfram|Alpha as the Way to Bring Computational Knowledge Superpowers to ChatGPT. StephenWolfram. https://writings.stephenwolfram.com/2023/01/wolframalpha-as-the-way-to-bring-computational-knowledge-superpowers-to-chatgpt/. 2023.

[18] 学习ChatGPT和扩散模型Diffusion的基础架构Transformer,看完这些论文就够了.走向未来. https://mp.weixin.qq.com/s/3bOFfODR7rpnyzrpocHlfQ. 2023.

本文作者

王文广,达观数据副总裁,高级工程师,自然语言处理和知识图谱著名专家。《知识图谱:认知智能理论与实战》作者,人工智能标准编制专家,专注于知识图谱与认知智能、自然语言处理、图像与语音处理、图分析等人工智能方向。曾获得多个国际国家级、省部级、地市级奖项,拥有数十项人工智能领域的国家发明专利和会议、期刊学术论文。

相关文章

猜你喜欢

成员 网址收录40401 企业收录2983 印章生成238246 电子证书1058 电子名片60 自媒体56378