机器之心原创

编辑:思

在预训练模型领域,BERT 开启的「暴力美学」逐渐演变成一场氪金游戏,动辄几十、上百万美元的训练费用令普通开发者望而却步。算力不够强、money 不够多就不能玩大规模预训练模型了吗?事实并非如此。

自从预训练模型提出以来,预训练就不停地刷新我们的认知。最近大火的 GPT-3 参数量达到一千多亿,训练成本更是重新定义了什么叫「壕无人性」:据海外媒体VB称,预计GPT-3的存储需求高达350GB、训练成本超过1200万美元。

对于我们普通用户来说,这样的成本也就只能想想了。向 OpenAI 申请使用 GPT-3 API 之类的,基本也不会有回应。

当然,我们还有很多已经开源的预训练模型可以选择,但这些模型总有各种局限,可用的「超大规模」预训练就更少了。

如果能有大厂总结了各种任务的大规模预训练模型,并且好用又方便,那么即使付出一些成本,我们也是非常乐意的。

最新升级的 EasyDL 平台恰恰满足了这一需求。它引入了百度超大规模视觉、自然语言处理预训练模型,结合迁移学习工具,只需标注少量数据就能定制高精度顶尖模型,目前在图像分类、物体检测、单标签和多标签的文本分类、短文本匹配、序列标注等任务领域都可以使用。

如果你的算力不够强、数据不够多、模型不够好、服务部署也不够灵活,可能还是选择大规模预训练模型、选择平台与工具比较省事儿。

「超大」规模预训练,独此一份

大规模预训练模型的效果毋庸置疑,它们在各自的领域都有非常优秀的属性。基于预训练模型,我们只需要在小数据集上训练少量步数,就可以获得高精度模型效果。

而且,众多文献实验都表明迁移学习非常有效,能够让预训练模型将通用知识应用到特定任务。

但困难之处在于,我们手头上掌握的都是一些小数据集,开源数据集也都有各自针对的领域,而通用的大数据集我们是很难获取的。当然,这还没有考虑算力。大规模预训练是需要 GPU 集群的,不是我们手上几块 1080Ti 能搞定的。

就算不考虑数据与算力,开源预训练模型使用的训练集也很可能与我们自己的数据集存在巨大差异。例如,预训练模型的数据都是自然风景,但我们的数据集都是动漫人物。那么放在一起就可能出现负向迁移,什么训练收敛慢、模型效果差等都会一一困扰着你。

因此,一个包含各类场景、覆盖用户各类需求的超大规模数据集就显得十分重要了。通过这个包罗万象的超大规模数据集训练所得的模型才能够更好地适应各行各业的需求,我们才能在自己的数据集上得到效果更好的模型。

预训练,交给大厂吧

这样的超大规模预训练,也就大厂能够做到。百度独有的超大规模数据集使其预训练模型具备了更好的泛化能力,迁移学习的效果也更好,目前已覆盖自然语言处理和视觉两大方向。

在自然语言处理方向,百度自研了业界效果最好的预训练模型文心(ERNIE)。它开创性地将大数据预训练与多源丰富知识相结合,通过持续学习技术,不断吸收海量文本数据中词汇、结构、语义等方面的新知识,实现模型效果不断进化,如同人类持续学习一样。

在刚刚结束的 2020 世界人工智能大会上,百度正式发布了 ERNIE 的中文名 “文心”。同时,百度还摘得了大会颁布的最高奖项——Super AI Leader 奖,彰显了在 NLP 领域的超强实力。

在最新的文心 ERNIE 2.0 中,中文模型已经学习了 1500 万篇百科语料和词语、实体知识, 3 亿篇文章的因果结构关系, 10 亿次的搜索查询与结果的对应关系,700 万个人类对话,以及 2000 万的语言逻辑关系知识。此外,模型还在持续不断地建模新的海量数据与能力,不断地提升下游的应用效果。这些硬核实力也让文心(ERNIE)在 16 个中英文典型 NLP 任务上显著超越了当时的 SOTA 结果。

目前,EasyDL 专业版已预置了领先的文心(ERNIE)预训练模型 ERNIE 2.0,并配套了丰富的 NLP 经典算法网络,支持文本分类、短文本匹配和序列标注等典型文本处理任务,能够在提升训练效率的同时大幅度提升模型效果。

文心(ERNIE)在落地上的表现也非常出色。某综合性电商平台使用 EasyDL 中的文心(ERNIE)搭建起了完整的智能评分系统。AI 赋能后的服务考核监督机制得以升级,用户的差评反馈都会被自动分析处理,大大提升了服务效率与服务质量。该系统将负面问题处理率由先前的 60% 提升到 100%,客服运营人力由 5 人 / 日降至 3 人 / 日。

在视觉方向,百度自研的超大规模视觉预训练模型覆盖图像分类与物体检测两个方向:

图像分类的预训练模型用海量互联网数据进行大规模训练(包括 10 万 的物体类别,6500 万的超大规模图像数量),适用于各类图像分类场景,平均精度可提升 3.24%-7.73%;

物体检测的预训练模型用 800 类别,170 万张图片以及 1000 万 物体框的数据集进行大规模训练,适用于各类物体检测应用场景,平均精度可提升 1.78%-4.53%。

在落地方面,日日生鲜超市使用 EasyDL 进行果蔬识别,以实现智能称重结算。他们将 SDK 部署到安卓平板并连接电子秤,大幅提高了称重效率。重要的是,如果使用公开数据集预训练模型,准确率只有 90.5%,但更换百度超大规模视觉预训练模型后,准确率上升至 98.1%,提升了 7.6 个百分点。

相比我们使用公开数据集或者开源的预训练模型,百度的超大规模视觉和 NLP 预训练模型能够提供更高的模型准确率和更稳定的性能,而这一切都可以通过 EasyDL 专业版获取。

易用才是最重要的

在讨论易用性之前,我们先来理一下使用开源预训练模型的一般步骤:搭建开发环境、下载模型、读文档、跑范例、写接口加载数据,然后处理一堆报错…… 而且,这还只是训练。如果要部署并应用新模型,中间还有大量工作要做,而这些都要我们手动实现。

相比之下,百度的超大规模预训练模型用起来特别简单,甚至都不需要怎么写代码,设置几个超参数就能开始迁移训练。

现在,这些超大规模预训练模型已经预置在 EasyDL 专业版中正式发布。EasyDL 是百度面向企业开发者推出的零门槛 AI 开发平台,一站式支持智能标注、模型训练、服务部署等全流程功能,平台预置了几十种经典网络和超大规模预训练模型,并支持公有云 / 私有化 / 设备端等灵活部署方式。“使用简单” 是 EasyDL 的一大特点。

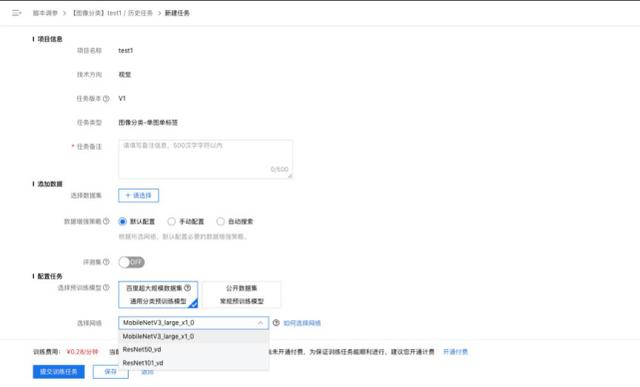

EasyDL 用起来到底有多简单?以视觉任务为例,在开始训练之前,你只需要进行三步操作:进入 EasyDL 平台并选择专业版、新建并配置图像分类任务、在「选择预训练模型」版块选择「百度超大规模数据集通用分类预训练模型」。然后选择数据集,加载模型,顶尖效果差不多就到手了。

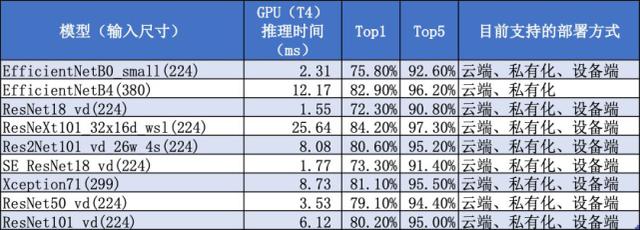

显然,百度的大规模预训练 ResNet-101 对各种场景都更加友好。如果我们把它当做骨干网络,并用于各种下游任务,效果会更有保障,也更加稳定。

此外,不论是 ResNet 这种大模型还是 MobileNet 这种小模型,经过超大规模数据预训练,它们的准确率和泛化能力都有比较大的提升。

当然,百度还新增了一些特殊模型,例如:为了提升训练和推理速度而修改模型、采用弱监督预训练提高准确率,构造更高效的分层残差连接等等。这些新增模型不仅能利用数据上的优势,模型上的能力也针对特定任务有了进一步改进。

在自然语言处理领域,百度文心(ERNIE)更是以其卓越效果横扫各大榜单:

2019 年年底,文心(ERNIE)在自然语言处理领域权威数据集 GLUE 中登顶榜首,以 9 个任务平均得分首次突破 90 大关刷新该榜单历史;

2020 年 3 月,文心(ERNIE)在全球最大规模之一的语义评测 SemEval 2020 上取得了 5 项世界冠军;

2020 年 7 月,文心(ERNIE)登顶视觉常识推理权威榜单 VCR。

目前,文心(ERNIE)已广泛应用于搜索引擎、信息流、智能音箱等用户产品中,同时也在金融、通信、教育、互联网等行业中落地,成为推动产业智能化转型的利器。

总之,无论是计算机视觉还是自然语言处理,百度 EasyDL 中的各种大规模预训练模型都可以为我们省去不少麻烦。从数据的角度来看,收集特定领域的业务数据成本并不低,而且数据量不够大还会影响模型效果。从部署的角度来看,模型部署过程中有各种各样的坑,非常耗费精力。相比之下,不如把这些工作都交给 EasyDL ,借助预训练模型与迁移学习的强大功力,用更少的算力和数据训练出更强大的优秀模型,成为新一代的顶尖炼金师。

聚焦于满足旺盛的产业智能化需求和快速增长的AI生产规模,百度推出飞桨企业版,包括零门槛AI开发平台EasyDL和全功能AI开发平台BML。EasyDL为零算法基础用户提供包含数据服务、模型训练、模型部署的一站式AI服务;BML面向专业算法工程师和企业开发团队提供灵活定制和深度集成的机器学习开发平台,推动AI创新和实践落地。

相关文章

猜你喜欢

成员 网址收录40387 企业收录2981 印章生成232042 电子证书1025 电子名片60 自媒体46877