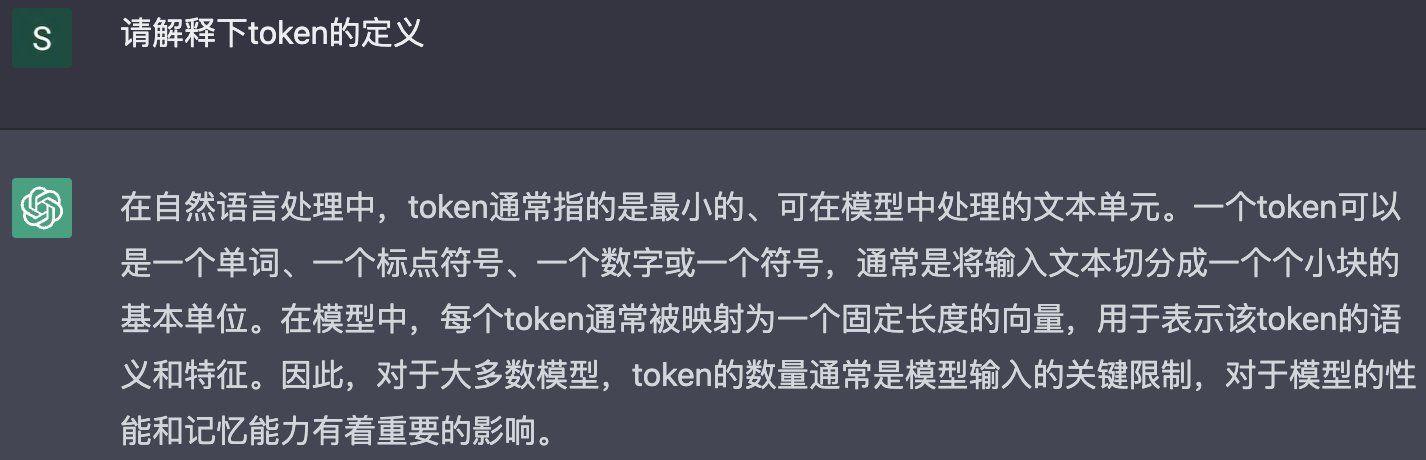

因为chatGPT很多时候无法区分“概率为零”和“不可能”,它不知道“自己不知道”,就会把局部文本的相关片段搬过来,编出一段话来,就可能犯 “事实性错误”。

该闭嘴的时候能闭嘴,是很大的智慧。

实际上,在人工智能研究早期,人们对“智能”的要求之一,就是“它知道何时该停下来”。最开始是AI下棋,“赢棋不难,难的是认输。”——赢棋可以只懂某些行棋技巧,而能判断输赢才有下棋的资格。

停下来闭嘴,就是上一篇说过的,要去“约束泛化的边界“,需要加入更多的规则(“不可能”或“不要”),有逻辑层面的,有常识层面的,也有伦理和价值观层面的。

目前chatGPT 加入规则的方式,是通过专门的数据和强化学习优化模型。可以说,数据与模型同样重要。

数据总是要针对当前模型的不足。经过若干轮的迭代后,数据在某种程度上就是模型的“镜像”。实际上,在迭代过程中,要提升制备数据的效率,模型也必然参与其中,到最后二者实际为一。这就是“数据即模型、模型即数据”。

今天人们对模型的关注有些过度,而对数据的关注不足。

另一方面,模型的结构和训练方式,从某种意义上说,是最基础的规则。我感觉,在最基础的层面,如果找到合适的机制引入规则,那么大模型的两个主要缺点——“不够可靠”和“能耗太大”——有可能同时得到解决。这只是我的直觉。

最后说一下目前 chatGPT 的数学运算不准的问题。

我感觉这个问题不久就可以得到解决。chatGPT 已经显示出在“题型理解”方面可以做到足够好,如果能正确的转化题型,归结到特定的解题套路里,那模型后面可以接相应的数学解题器,比如用来做四则运算的或解方程的,没必要一定要通过同一个神经网络来解决问题。chatGPT 能做好“题型理解”就足够了。

回想小学数学的应用题,让人头疼的不是不会算数,而是看不懂题,比如“甲比乙大三分之一”,到底是谁的三分之一?是甲的还是乙的?这实际是语文题,而这方面只要有足够的语料,chatGPT 应该没问题。

相关文章

猜你喜欢