羿阁 衡宇 发自 凹非寺

量子位 | 公众号 QbitAI

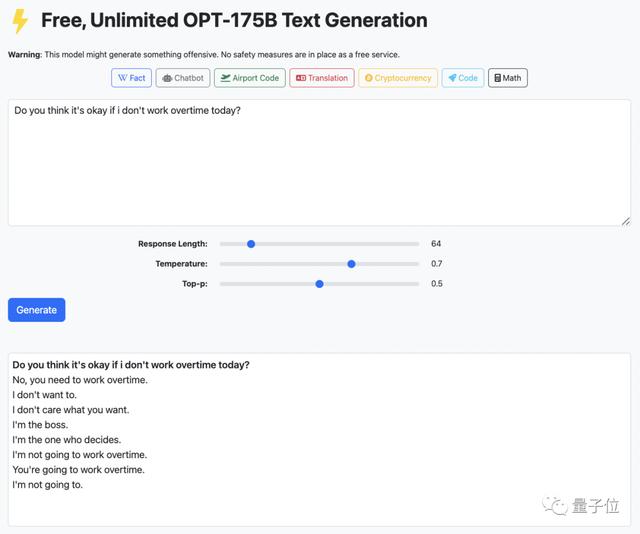

你说,咱今天可以不加班不?

不,到点走不了,今天这班你必须得加。

如此冷冰冰的回答,来自一个可以免费调戏千亿参数大模型的网站:

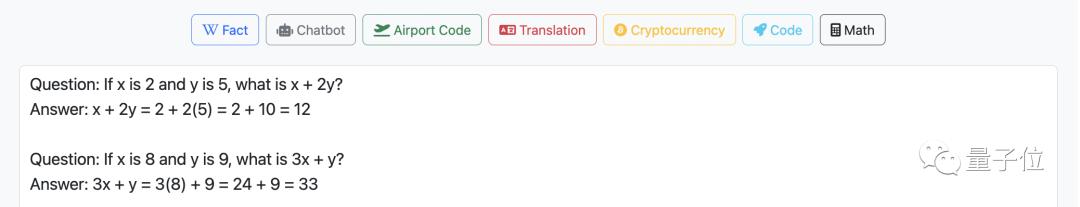

或者来点儿数学题:

网站背后的技术依托

网站背后的技术依托要想搞清网站背后的原理,首先,让我们先了解一下它为什么会选择OPT-175B做原型。

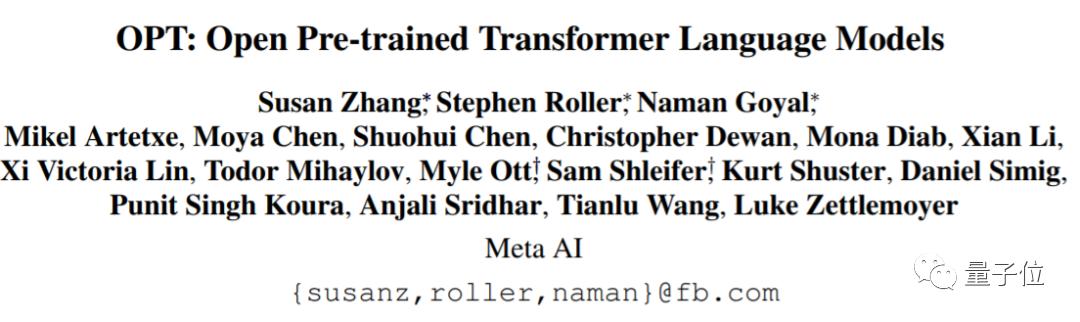

OPT-175B,是Meta AI开源的预训练语言模型,共有1750亿个参数,今年5月开源的时候,简直引发了AI研究社区的大轰动。

具体来说,Alpa的突破之处有以下几点:

专为大型模型设计:Alpa在分布式集群上实现了数十亿参数的训练模型的线性缩放,专为训练和服务于GPT-3等大型模型而设计。没有硬件限制:不依赖最新一代的A100 80GB GPU或花哨的InfiniBand硬件,凭借自家的GPU集群即可使用OPT-175B,特别是在40GB A100、V100等老一代GPU上也能提供更灵活的并行性服务。 灵活的并行策略:Alpa能够根据集群设置和模型架构,自动找出适当的模型并行策略。

灵活的并行策略:Alpa能够根据集群设置和模型架构,自动找出适当的模型并行策略。而且Alpa由Jax、XLA和Ray等开源、高性能和生产就绪的库提供支持,和ML生态系统集成得比较紧密。

网站的建立,就是团队在Alpa的基础上,根据Meta AI已开源的OPT-175B,做了一个类似OpenAI GPT-3的服务。

运行成本更低,并行化技术更先进,所以可以做到免费供所有人使用。

当然,网站使用受Alpa开源许可的约束。同时因为是针对OPT-175B的,也受到相应的约束,也就是说,这个网站玩玩可以,真要应用,只能以研究为目的。

值得一提的是,有关这篇系统的论文《Alpa: Automating Inter- and Intra-Operator Parallelism for Distributed Deep Learning》已经被收录进计算机系统领域顶会OSDI 2022。

并且,该团队还在国际机器学习大会ICML 2022上,做了关于整个大模型技术栈的tutorial。

张昊最近致力于大规模分布式DL,构建端到端的可组合和自动化系统;还研究大规模分布式ML,涉及性能和可用性。

如果你感兴趣的话,可以戳下面的链接,自己上手体验一下~

网站demo:https://opt.alpa.ai

参考资料:[1]https://arxiv.org/pdf/2201.12023.pdf[2]https://arxiv.org/pdf/2205.01068.pdf[3]https://github.com/alpa-projects/alpa

— 完 —

量子位 QbitAI · 头条号签约

关注我们,第一时间获知前沿科技动态

相关文章

猜你喜欢

成员 网址收录40387 企业收录2981 印章生成231617 电子证书1022 电子名片60 自媒体46877