所以我们不能抱希望于自己能够发明出别人发明不出的东西,最多只能改变时间线。如果你真的想有所作为,唯一能做的就是在技术诞生之初,设定一些初始条件来确保它的顺利发生。比如,在“互联网”刚被发明的时候也有很多竞争对手发明出类似于互联网的产品,但互联网之所以能成功,离不开它最初设定的初始条件:互联网允许人们成为任何人,以非常开放的心态联系沟通。我相信下一个 40 年也会继续这样发展,或许过程中也会转向,但这些初设条件对互联网的成功非常重要。

03.

如何构建真正的 AGI

Lex Fridman:OpenAI 最近发布了 GPT-2 ,但没有发布完整的模型,官方说明是因为担心可能会产生负面影响,这也引发了社会层面的讨论。这里的负面影响和积极影响分别是什么?

Greg Brockman:我们现在正处于扩大模型的道路上,并且随着模型规模的扩大而实现更好的性能。GPT-2 只是 2018 年 6 月 GPT-1 的放大版。我们未来要扩大它到上千倍,不知道最终会得到什么。可能 GPT-2 不具有负面应用,但 GPT-20 的能力会是实质性的。

GPT-2 潜在的负面影响在于它可能会导致产生假新闻或滥用内容。比如一定会有人尝试在 GPT-2 基础上使用自己的 Facebook 消息历史记录,来生成更多 Facebook 消息,进一步,这种行为就会带来生成制作虚假的社会性、政治性议题、政治家内容的可能性。

而正面影响是,GPT-2 的确带来了有很多很棒的应用程序,开发者可以使用 GPT-2 来衍生出很多很酷的想法。很多人写信给我们,希望能把它用于各种不同的创意应用。

GPT-2 推出后带来的应用场景包括:

1. 文本生成:GPT-2 Poetry;GPT-2 Dungeons and Dragons character bios;

2. 聊天机器人:Thomas Wolf 团队在 PERSONA-CHAT 数据集上微调了 GPT-2,建立了带有角色个性的聊天机器人;

3. 机器翻译;

4. 文字总结:在 CNN 和《每日邮报》的数据集上进行了测试。

所以如果要真正考虑安全性。对于 GPT-2,是否公开发布各有利弊,但未来模型的到来可能比预期要快,扩大模型并不需要很长时间,未来的模型是绝对不能公开发布的内容。我们把不公开发布 GPT-2 视为一个测试,实现社会心智的过渡。

GPT-20 是 Greg 在当时对模型能力能够达到质变节点的预测,从后视镜视角来看,Greg 对于模型参数量扩大后的能力提升预测还是相对保守,因为在 3 年后 GPT-3 就已经实现了这样的目标。Lex Fridman:你认为 GPT-20 时候的世界是什么样?就像在 50 年代,人们试图描述互联网或智能手机。我们将成功设计识别机器人与人类的系统,还是人类不得不接受并习惯充斥着假新闻的世界?

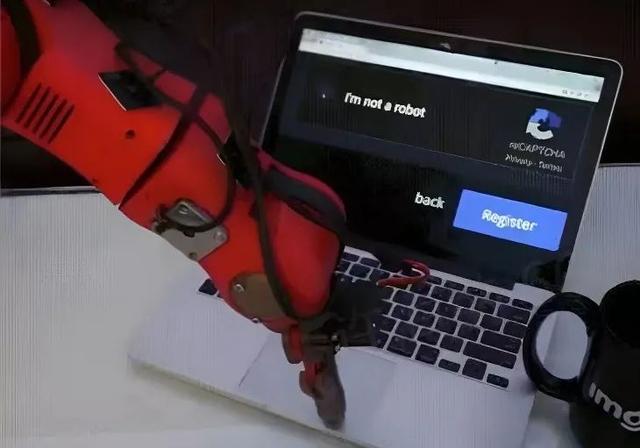

Greg Brockman:有一个十分流行 meme (模因)可以用来回答这个问题:一只机器人物理手臂正在点击“我不是机器人”的身份验证按钮。我认为人类最终无法区分机器人和人类。不可否认的是,人们在未来所获取的信息中有一部分一定是通过自动生成的,因为 AI 足够强大,以至于人们无法分辨出人类和人工智能分别产出的信息之间的差异,甚至最有说服力的论点反而是由 AI 提出的。

Lex Fridman:你认为语言模型最终可以发展到什么程度?类似于电影Her 里面。人类与 AI 通过自然语言的多轮对话可以通过这种无监督模型来实现吗?

Greg Brockman:大语言模型应该能够真正理解微积分,并解决新的微积分问题。我们需要的不仅仅是语言模型,而是解释和推理的方法。

语言建模实际上已经走得比许多人预期的要远。GPT-2 还没有来自于自身的动态经验,只是一些可供学习的静态数据,所以它对物理世界的理解程度很浅。如果我们能够让它真实地理解物理世界就已经相当令人兴奋。

但如果仅仅只是扩大 GPT-2,也并不足够让模型具备推理能力。人类是通过思考产生新的想法、获得更好答案,并且思考的过程一定会花费大量计算能力,这种模式没有被编码在 GPT 中。分布式泛化(distribution generalization)也很有趣。对于人类来说,即便有些时候没有经历过某件事,但也会对这件事有一个基本的思考与理解,这与推理有关。

为了真正构建 AGI,一方面需要在计算规模上尽可能地推进,另一方面还需要在人类自身思考和认知的实质性推进。

我们应该找到一个可扩展的方式:投入更多的计算、更多的数据,让它变得更好。我们之所以对深度学习、构建 AGI 的潜力感到兴奋,部分原因是我们研究出了最成功的 AI 系统,并且意识到如果扩大这些系统的规模,它们会更好地工作。可扩展性给了我们构建变革性系统的希望。

Lex Fridman:创建 AGI 或一些新的模型的过程中,如何在它们还只是原型阶段的时候就发现它们的潜在价值?如何能够在没有规模化的情况下坚持这些想法?

Greg Brockman:我们自己就是很好的案例。OpenAI 在 6 月 28 日发布了 GPT,后来我们将其放大到 GPT-2。在小范围内,GPT 它创造了一些记录,它不像 GPT-2 那样令人惊艳,但它很有希望。

但是有时规模化后与我们在小范围内看到的内容有质的不同。最初发明者会说,我不认为它能做到这一点,这就是在 Dota 看到的。Dota 基本上只是大规模地运行 PPO,长期来看,这些行为在我们认为不可能的时间尺度上真正发挥作用。

PPO:

Proximal Policy Optimizaion,近端策略优化算法。PPO 提出了新的目标函数,可以在多个训练步骤实现小批量的更新,解决了 Policy Gradient 算法中步长难以确定的问题。Lex Fridman:随着 GPT 规模的不断扩大,可能人们会看到更加令人惊讶的结果,很难看到一个想法在规模化后会走多远。

Greg Brockman:Dota 和 PPO 是一个非常具体的例子。关于 Dota,有一件事非常令人激动,人们并没有真正注意到,那就是分布中泛化的法令(the decree of generalization out of distribution),它被训练来对抗其他 AI 玩家。

Lex Fridman:未来几年深度学习将走向何方?强化学习的方向在哪?对于 OpenAI ,2019 年你会更关注哪些方面?

Greg Brockman:规模化地开展更多创新的项目。

OpenAI 内部有一个项目的生命周期。先从几个人开始,基于一个小的 idea 展开工作,语言模型就是一个好的例子。一旦在过程中得到一些有意思的发现和反馈,我们就扩大规模,让更多的人参与其中,同时投入更多的计算资源。最终状态会像 Dota ,由 10 或 15 人组成的大型团队,以非常大的规模运行事情。将工程和机器学习科学结合在,形成一个系统展开工作、并获得实质性的结果。整个生命周期,端到端,需要 2 年左右的时间才能完成。

OpenAI 内部也有更长的生命周期项目。我们正在组建一个推理团队去解决神经网络推理这件事,这会是一个长期、但一定有超预期回报的项目。

Lex Fridman:讲讲 Dota 的训练过程。

Greg Brockman:Dota 项目是我们迈向现实世界的重要一步,相对于象棋、围棋等其他游戏,Dota 作为一个复杂游戏连续性更强,在 45 分钟的游戏中,玩家可以进行不同的动作和策略组合。Dota 的所有硬编码机器人都很糟糕,因为它太复杂了。所以这是一个推动强化学习最新技术的好方向。

硬编码(hard coding):

将数据直接嵌入到程序或其他可执行对象的源代码中的软件开发实践,而不是从外部获得数据或在运行时生成数据。我们在 2017 年在 Dota 的 1V1 对战中成功击败了世界冠军。学习技能曲线是一个指数函数,我们一直在扩大规模,修复错误,从而获得了稳定的指数级进展。

Lex Fridman:Dota 是一个非常受欢迎的游戏,在全世界有很多很资深的人类玩家,所以在 OpenAI 和人类的 Dota 1V1 对战中,要获得成功的基准是非常高的,最初是怎么训练这些 AI 的?

Greg Brockman:我们使用的方法是自训练。我们设置了两个没有任何经验的 Dota AI 玩家,他们互相争斗;他们不断发现新的对战技巧、继续斗争。之后我们从 1V1 扩大到 5V5,继续学习团队行动中需要做的协调,在 5V5 版本游戏中达到专业水平,难度指数级上升。

这件事与昆虫的训练方式有很多共同点。但昆虫在这种环境中生活了很长时间,并且有很多经验。站在人类的角度来看,昆虫并不聪明,但昆虫其实能够很好地驾驭它所处的环境,甚至处理周围环境中从未见过的意外事情,我们在Dota AI玩家上看到了同样的事情。在这个游戏中,他们能够与人类对战,这在其进化环境中从未存在过。

人类与 AI 的游戏风格完全不同,但 AI 依然能够很好地处理这些情况。这没有从较小规模的 PPO 中出现。之后,我们运行 10 万个 CPU 内核、数百个 GPU,这个规模是巨大的,我们开始从算法中看到非常不同的行为。

Lex Fridman:Dota 在 1V1 比赛中打败了世界冠军,但目前还没有赢得 5V5 的多人比赛。今年接下来的几个月会有什么变化?

Greg Brockman:OpenAI 的 Dota 团队一直在与比我们模型更好的玩家进行比赛,虽然我们最终输掉了两场比赛,但这也确实表明我们已经处于专业水平。我们内部很相信它在未来会取得进一步的胜利。

但其实赢或输与我们思考即将发生的事情的方式无关。因为我们的目标并不是在 Dota 比赛中击败人类,而是推动强化学习达到最先进水平,所以某种程度上我们已经做到了这一点了。

温馨提示:虽然我们每天都有推送,但最近有读者表示因平台推送规则调整,有时候看不到我们的文章~

*文章观点仅供参考,不代表本机构立场。

相关文章

猜你喜欢