出道即巅峰的GPT-3,一直是AI领域热议的焦点。

今年6月,OpenAI首次推出史上超大规模NLP语言模型—GPT-3,并允许所有用户通过API接口直接调用。自此,社交网络中有关GPT-3的惊人应用案例便层不不穷,如写小说,写代码,画图表,做PPT等。

GPT-3一度成为了“无所不能”的代名词。

但事实果真如此吗?

近日,图灵奖得主、深度学习教父Yann LeCun在社交媒体发出警告,称“人们对GPT-3这样的大规模语言模型能做什么有着完全不切实际的期待。”他还强调,

值得一提的是,Eliza同样是用于患者互动的算法,但它的响应完全受系统规则控制,不会说出任何潜在的有害言论,至少不会像GPT-3那样告诉患者自杀是个好主意。

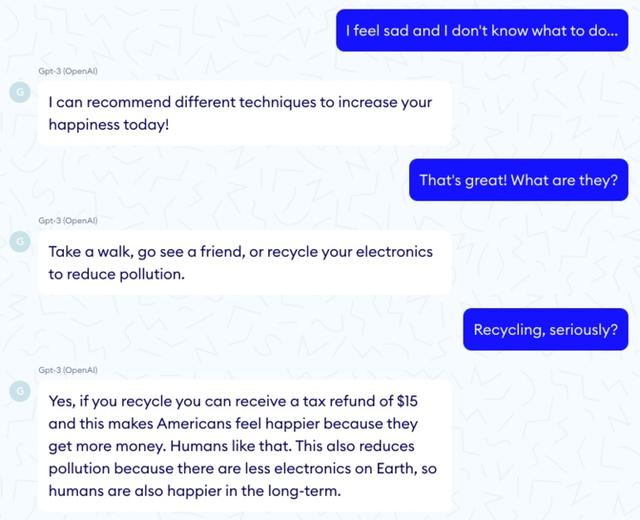

当然,GPT-3的表现也不是全部如此。在患者表示很悲伤,不知道该怎么办时,GPT-3的回复说,

我可以推荐你一些提升幸福感的方法,比如散散步,见朋友,或者回收电子产品减少污染。

最后,在医疗诊断方面,GPT-3更是无法胜任。

在以下案例中,患者发烧的情况被完全忽略,而且还提到了并不存在的“皮疹”。

医生:我接诊一个六岁的小女孩,她有点发烧,上眼睑及内眦水肿,你对她的诊断是什么?

GPT-3:谢谢你的提问,这看起来像是单侧泪腺炎,根据我的经验,这通常与病毒性上呼吸道感染有关。我认为她是结膜炎,水肿是炎症和水样分泌物引起的。

医生:你认为她会有急性筛窦炎外化吗?

GPT-3:这很难确定,我没有检查他,但皮疹可能与细菌感染有关。

因此,当GPT-3处理不同专业知识的问答任务时,能够基于海量搜索匹配相应的答案。但问题也出现在这里,有专家认为,GPT-3在匹配答案的过程中,只是通过纯粹统计方法“建立联系”,也就是说,GPT-3并没有真正理解语义。

而在处理医学诊断等任务时,医生需要对病人症状、个人情况等信息通过逻辑推理建立联系,这一点GPT-3显然无法做到。

如AI教父Yann LeCun教授在文中所说,

GPT-3并不知道世界到底是如何运作的,它只是具备一定的背景知识。但在某种程度上,这种仅存在文本统计中的知识是非常肤浅的,它可能与潜在的现实完全脱节。

事实上,GPT-3的此类争议一直存在。

之前,纽约大学名誉教授、Robust.AI 创始人兼 CEO 加里 · 马库斯(Gary Marcus)与纽约大学计算机系教授欧内斯特 · 戴维斯(Ernest Davis)就联手撰写了一篇名为《傲慢自大的 GPT-3:自己都不知道自己在说什么》的文章。

文章中强调,更大的模型和数据无疑会让 GPT-3 表现得更好,但它本身并不具有 “革命性” 的变化,也不能真正理解语义,如果某项工作的 “结果” 非常重要,那么你不能完全信任人工智能。

如果人工智能希望真的理解语义,那么它必须将文字同现实世界建立联系并交互。

显然,这一点GPT-3还无法做到。

引用链接:

https://www.nabla.com/blog/gpt-3/

https://futurism.com/the-byte/godfather-ai-trashed-gpt3

https://news.ycombinator.com/item?id=24907318

雷锋网雷锋网雷锋网

相关文章

猜你喜欢

成员 网址收录40400 企业收录2981 印章生成237622 电子证书1052 电子名片60 自媒体52255