自从ChatGPT席卷全球以来,各家公司纷纷打开钱包来探索这项技术,人工智能领域掀起了新一轮热潮。它还引起了大家对OpenAI的GPT-3的关注,这是现象级ChatGPT背后的大型语言模型(LLM),它对查询提供类似人类响应。

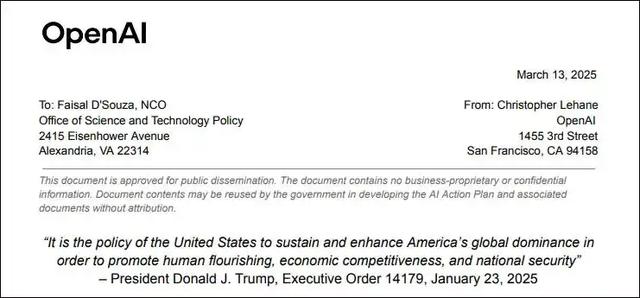

PSC欢迎主要与人工智能和机器学习工作量有关高性能计算项目,而对传统高性能计算应用程序则不太受欢迎。项目鼓励应用程序采用AI算法方法来运行传统HPC工作负载。这些提案必须是非专利的,且只能来自美国研究机构或非盈利性机构。

除了GPT-3,CS-2系统还支持流行的BERT Transformers模型。

Cerebras Systems的首席执行官Andrew Feldman表示:“关于大型语言模型和超大型语言模型,有大量的讨论。然而在给定的规模(例如130亿参数)之后,实际上从零开始训练一个语言模型的组织数量少之又少。因为你首先需要解决大量的硬件问题。”

通常,运行Transformers模型需要大量数据、数据科学知识和深度机器学习专业知识。训练数据需要数周的时间,硬件选项包括GPU和TPU(GPU被微软用于Bing和AI,而TPU被谷歌用于Bard聊天机器人)。

PSC的Neocortex已经被用于研究生物技术、宇宙视觉地图和健康科学等领域的人工智能。该系统还用于研究在CS-2中部署的新内存模型上部署AI的方法。

Cerebras在CS-2中的WSE-2芯片包含2.6万亿个晶体管,所有相关的AI硬件都集中在晶片大小的芯片中。该系统具有40GB SRAM片上存储器、每秒20 PB的带宽和12个100千兆以太网端口。CS-2连接到HPE的Superdome Flex系统,该系统有32个Intel Xeon Platinum 8280L芯片,每个芯片有28个内核,运行频率高达4GHz。

相比之下,英伟达GPU通常分布在许多系统上。英伟达的GPU依赖于CUDA并行编程工具包,该工具包广泛用于研究人工智能。Feldman:“我认为,我们有很大的机会取代GPU和TPU,并以更有效的方式做到这一点——用更少的失误实现更好的目标。”

对ChatGPT的需求已经压倒了OpenAI的系统,因此未来针对AI计算的需求将势不可挡。

相关文章

猜你喜欢

成员 网址收录40395 企业收录2981 印章生成235384 电子证书1038 电子名片60 自媒体47038