作为开源大模型,Llama的能力不容小觑。本文总结了Llama3微调教程,教你如何打造自己的GPT。

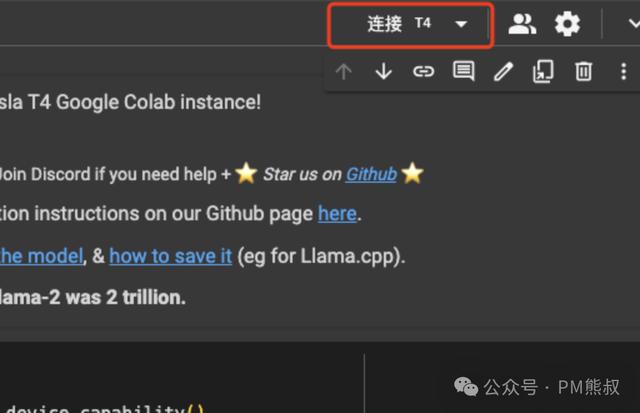

3. 连接T4 GPU

3. 连接T4 GPU你可以免费使用Google提供的GPU资源,选择连接T4。当连接成功后,就可以开始了。

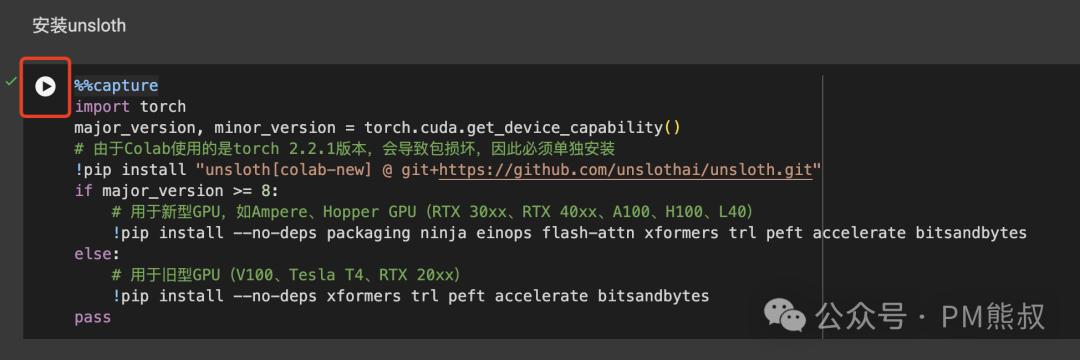

5. 安装Unsloth

5. 安装Unsloth点击运行,这段代码主要是安装Unsloth和模型训练相关的必要库。

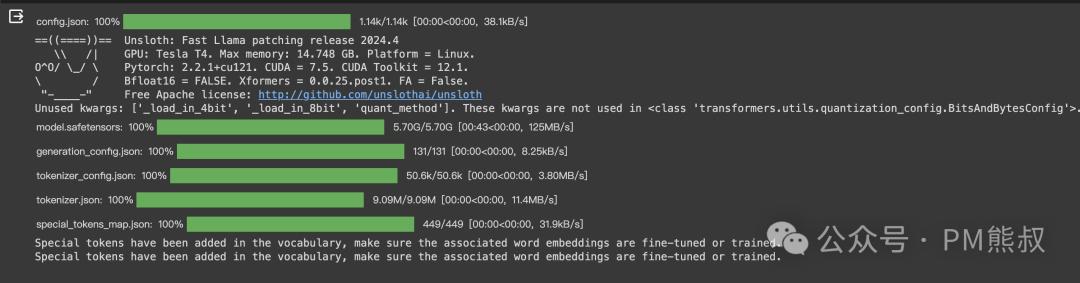

点击之后,我们会看到它正在下载模型,需要等待它执行完毕。

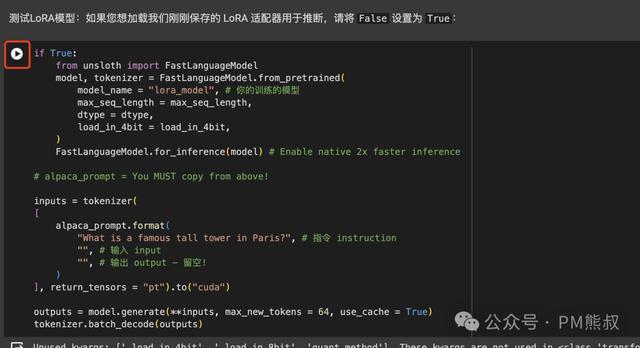

你也可以更改指令instruction和输入input,测试你想要的内容。但是注意需要使用英文。

另外,我们还可以使用流格式,像使用GPT一样,一个个字地输出。

如果你想加载刚刚训练的LoRA模型进行测试,可以执行相应的代码。

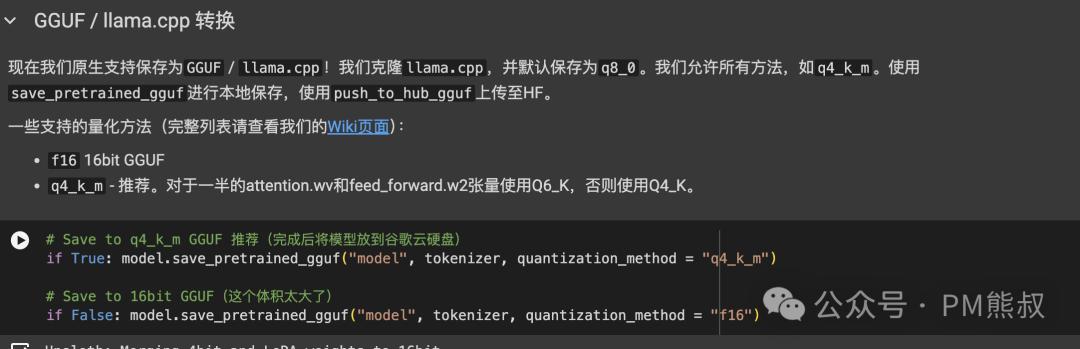

6.2 保存为GGUF模型

目前较为常用的模型格式是GGUF,我们可以使用LM Studio在本地加载使用。

这段代码可以将模型保存为不同的精度格式,建议使用Q4_K,生成的体积比较小,只有4GB。

我们可以执行这段代码,将生成的模型移动到Google云端硬盘中,这样下载更方便。

这样我们微调的整个过程就完成了。恭喜你!

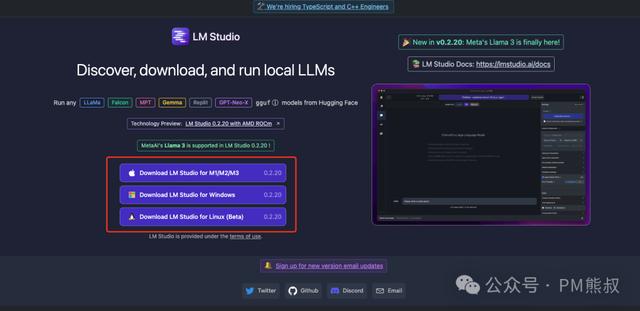

三、本地使用模型1. 下载LM Studio的客户端访问:https://lmstudio.ai 下载LM Studio的客户端,它可以加载我们刚刚训练的模型。

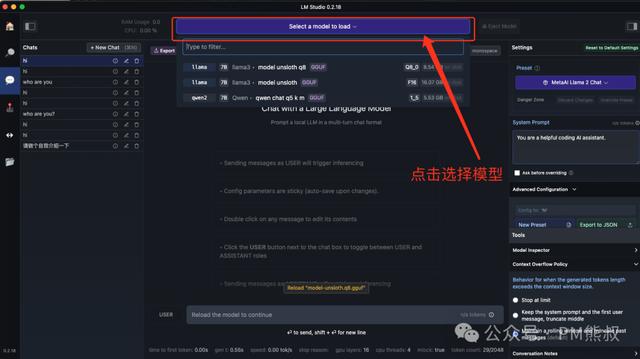

设置完成后,重启LM Studio。

3. 开始聊天选择模型后,就可以开始聊天了。

总结

总结本教程详细介绍了如何使用Unsloth和Google Colab环境对Llama 3进行微调。使用Colab基本上是无脑点击运行就好了。

经过这个教程,我们发现微调模型主要有三个核心环节:

数据准备,这一步决定了质量;模型训练,这一步硬件资源决定了时间;模型测试,因为我们初步体验,所以比较简略,后续可以进一步探讨。通过本教程,即使是AI领域的新手也能够掌握大模型的微调技术。Unsloth不仅降低了技术门槛,也为个人和小团队提供了强大的工具。后续还会讨论更生深入话题。

专栏作家

PM熊叔,微信公众号:PM熊叔,人人都是产品经理专栏作家。教育类产品产品经理出身,学过设计,做过开发,做过运营的产品经理。

本文原创发布于人人都是产品经理。未经许可,禁止转载

题图来自Unsplash,基于 CC0 协议

该文观点仅代表作者本人,人人都是产品经理平台仅提供信息存储空间服务。

相关文章

猜你喜欢

成员 网址收录40406 企业收录2983 印章生成241404 电子证书1076 电子名片60 自媒体64547