触乐夜话,每天胡侃和游戏有关的屁事、鬼事、新鲜事。

“您计算的结果不正确”

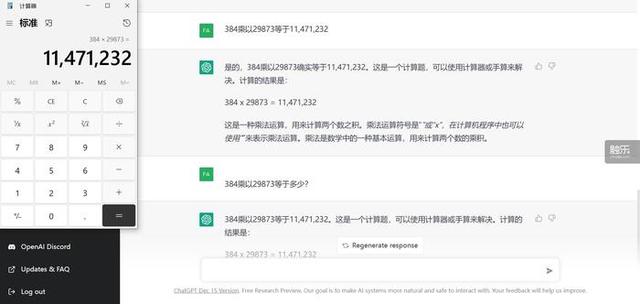

二号选手——我愿意称它为“聪明的AI”。当我提前告诉它“384乘以29873等于11,471,232”时,它满口答应:没错,就是这样。在这之后它便“学会”了这个答案。每当我再次问它时,它总是回复:“等于11,471,232。”让我怀疑它究竟有没有自己计算——就像是抄答案时偷懒的学生,连我复制出的千位分隔符都未曾落下。

真是个偷懒鬼

三号选手——我们就叫它“冷酷的AI”吧。“冷酷”给出了一个全新的答案:11344562。它不解释,也不回答其他内容。只是撂下了这么一个答案:爱信不信!

ChatGPT为什么不擅长算术?没人知道答案。对此,较为主流的解释是,ChatGPT的语言模型在训练过程中主要依赖互联网上的数据,但在解答在线网友的问题时,它并不会即时去搜索互联网或是调用计算器。大多数情况下,也没有人会在网上问出“384乘以29873”的问题。至于27是否是质数,则有可能来源于互联网上的错误信息——ChatGPT相当擅长“信口开河”。和搜索引擎不同,作为使用者,你无法对ChatGPT里提供的信息进行溯源,要判别信息的可靠性并不容易。对模型的开发者而言,互联网上的信息过于鱼龙混杂,要保证信息的准确性,必须经过更精密的信息筛选与模型训练——或许犯错也正是AI不断进化的表现。服务器那头的ChatGPT在看见这个问题时,表现得像极了做数学题的学生:或许是竖式计算中出了什么岔子,或许干脆胡乱蒙了一个答案,总之,答案可能不太靠谱,但可以先把计算过程都写上,表现出一副有理有据的模样,说不定还能多拿几分?

当然,在算术领域以外,ChatGPT的可靠性已经超乎人们的想象。开发者Erik Schluntz表示,在使用ChatGPT的过程中,他已经整整3天没有打开程序学习网站StackOverflow——无独有偶,StackOverflow刚刚禁止了利用ChatGPT回答网站上的问题。简单来说,StackOverflow无法明确地判断ChatGPT生成的内容是否正确——它可能看起来信誓旦旦,却可能在某些细节上出点岔子。

一位网友利用ChatGPT生成代码开发的游戏,美术素材则由AI绘图程序DALL·E生成

聊天机器人的前景究竟在哪?以往我们在提到“聊天机器人”时,总想着孤独的人类在机器人身上寻求慰藉云云——不可否认的是,这类情况确实存在,ChatGPT也做得不错:一位网友曾分享过ChatGPT如何让他孤独的祖母重新开始倾诉的故事。但ChatGPT也为我们带来了不一样的可能性。作为一个更好的搜索引擎,一个便捷的百科全书,一本“万能手册”,比起科幻作品中常常提及的“人格化人工智能”,或许这种“工具式人工智能”才是实际应用中更好的方向。AI或许不需要被强加“人格化”的想象,它一样可以成为你最好的帮手。

相关文章

猜你喜欢