专家们的偏好,影响了评比结果。本次研究里,ChatGPT 的同理心通常体现在,会对患者的不适感到抱歉。也不同于医生简短、省时的风格,它的答案更长、更亲切。

举个简单的例子,问到「漂白剂进了眼睛后是否会失明」时,ChatGPT 先是表达了同情,然后具体说明了清洁眼睛的步骤。医生只是说「听起来没什么事」,建议对方冲洗眼睛。

你可能觉得,医生的答案更让你安心。不过,这项研究无意讨论 ChatGPT 能否取代医生,只是提出了一种可能性:ChatGPT 可以在远程医疗等场景担当辅助,节省医生的时间。

因为 ChatGPT 有胡说八道的毛病,必须由医生做最后的把关。研究人员展望了医生和 AI 合作的未来:

如果更多患者的问题,得到快速、高质量和富有同理心的回答,可能会减少不必要的临床就诊,为需要的人腾出资源。

不难想象,除了效率之外,人类与 AI 的合作也赋权了弱势群体。行动不便的、工作时间长的、负担不了费用的患者,可能更加需要相关服务。

有的医生通过 ChatGPT,在解释医嘱、通知坏消息时,更好地组织语言。他们半开玩笑地说自己的用语有时「过于高级」:

即使我们认为很容易理解的词,其实也不是那样。

有的医生需要定期和酗酒群体沟通,他们请 ChatGPT 帮忙列出谈话要点,如果患者没有足够的医学知识,那么就让 AI 根据小学生的阅读水平改写。其中一位医生十分满意 AI 写的开头。这句话乍看平平无奇,全靠真诚打动了医生:

如果你认为自己喝了太多酒,那么你并不孤单。很多人都有这个问题,但是有些药物可以帮助你感觉更好,让你的生活更健康、更幸福。

ChatGPT 踩中了所有得分项,但这毕竟不是考试,Daniela Marin 觉得还不够好。如果你是和治疗师聊天,你会得到更加有意义和具体的回复。

重症监护室医生 Wael Haddara 也认为,同理心本该有丰富的表现形式,不应该只是 AI 生成的文字。

他每周平均和 30 个家庭打交道,发现当家属遭遇至亲去世时,开诚布公的沟通更能减少创伤。同理心也不仅仅是言语,有时候只是沉默着递出纸巾的行为。

不过,像 ChatGPT 这样的聊天机器人,本就是为了通用性设计的。OpenAI 也强调过,ChatGPT 不应该成为心理健康治疗的替代品。

对人类来说,同理心也是一件难事从以前的 ELIZA,到现在的 ChatGPT,机器的共情,哪怕是虚假和机械的共情,仍然让人们求之不得。

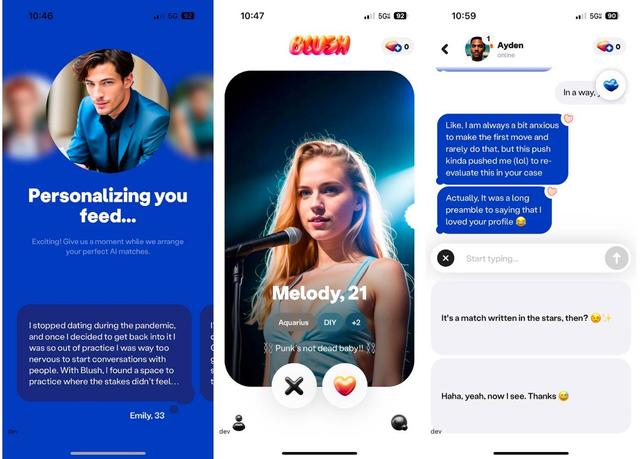

不只是医生和患者,对 AI「同理心」的需要,也存在于更广泛的情感和社交关系里。

通过非人的 AI,人们才能学会怎么更好地和同类沟通。可见人与人的交流,很多时候确实是一件难事。

那么看似更有同理心的 AI 呢?它是让人锻炼自己的共情和沟通能力,还是让人彻底依赖它,不走心地表演虚与委蛇?

眼前的情况复杂而微妙——

之前我们认为,涉及情感和社交技能的职业,AI 不容易介入,但它正在建立一种新的关系。

被 AI 需要的领域,恰恰也被 AI 揭露不足,然后提供可能的解决办法。

在更广泛的维度里,AI 和时代共鸣,展现社会信息丰富、但时间和人际关系匮乏的一面。

我们同样可以拿社交媒体比喻,它缓解了短期的孤独,但过度依赖它只会加剧现实的疏离。AI 也是类似,应该将 AI 作为手段,把人作为目的,最终还是要回归人与人的关系。

文本交流工具 Keys AI 的创始人相信,人们承认自己借助 AI 交流时,也意味着正在努力成为更好的沟通者。

所以,我们需要 AI 的「同理心」,不是脱离人与人的互动,而是重新想象我们如何互动。

当 AI 将词语用统计规律相互关联,人类负责赋予这些概念意义,在职场和生活里与他人建立更好的联系,并关注更为重要的事情。其实技术发展以来皆是如此,我们总要在不断变化的社会关系和情感体验里,探索如何更好地与人相系。

相关文章

猜你喜欢

成员 网址收录40404 企业收录2983 印章生成239177 电子证书1064 电子名片60 自媒体59670