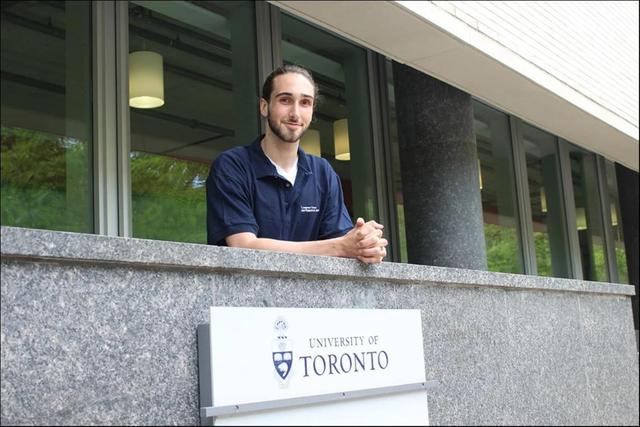

Cohere联合创始人艾丹·戈麦斯(Aidan Gomez)(图片来源:多伦多大学)

艾丹·戈麦斯(Aidan Gomez)是一位著名的AI研究者,也是Cohere的联合创始人。他是少数在Google Brain工作时创造Transformer算法的研究者之一。此次交流中,他谈到了自己的经历以及他的初创公司Cohere,该公司以他早些时候的工作为基础。

戈麦斯在加拿大长大,后来他去了多伦多大学学习。在那里,他在大二的时候发现了人工智能,并开始狂热地阅读有关该主题的学术论文,是一名机器学习研究员和数学迷。

“我变得痴迷,我就是日夜不停地阅读论文,”他回忆说。“我会带着一篇研究论文入睡。”

他在文献中一直看到一个名字——杰夫·辛顿(Geoffrey Hinton )——他的附属机构也是多伦多大学,尽管辛顿早已停止教学。戈麦斯通过电子邮件与他联系,向辛顿提出一个小技术问题。令他惊讶的是,辛顿回应了他,这位世界上最著名的AI研究者向一个当时还是匿名的本科生解释了一个普通的问题。

在他的本科学习期间,戈麦斯前往科技创新的中心——硅谷——那里他成为了著名的Google Brain团队的一名实习生。在那里,他与领域内一些最聪明的人合作,包括在开发谷歌TensorFlow模型框架中发挥了重要作用的Lukasz Kaiser。

“Kaiser想把机器学习研究者们编译的每一个数据集都放入一个模型中,使其在输入和输出方面都完全Multi-model(多模态)。”戈麦斯说。

为了支持这个项目,戈麦斯帮助建立了一个名为Tensor2Tensor的软件基础设施,该设施可以在成千上万的GPU之间分配计算任务。他说,这主要集中于自回归模型,特别是基于注意力的模型。“我们听说Google翻译的一个团队也对基于注意力的自回归模型感兴趣,Lukasz说服他们过来,并在Tensor2Tensor上构建它。”

接下来的10周,我们一直在赶制这个模型。“由于我们得到的结果非常出色,所以压力只是越来越大,”戈麦斯回忆道。“这是早期非常成功、可以大规模扩展的架构之一,我们的大规模GPU集群带来了极高的性能。”

“没人在睡觉;我每天工作14个小时编码,建设这个基础设施,使它更为健壮,运行实验,这就是我们得到变压器算法的方式。”

现在,Transformer算法只有大约20行代码。基本层是一个多层感知器(MLP),Transformer实际上只是一些堆叠在一起的MLP和一个注意力层。在Transformer之前,有这些非常复杂的LSTM架构,没有统一的架构。有了Transformer,所有这些都被拆除,留下的是简单的、表现良好的、可扩展的“内核”东西。

Transformer算法为先进的自然语言处理打开了大门,使机器能够理解和生成类似人类的语言。OpenAI的首席科学家Ilya Sutskever立即利用它建立了第一个生成预训练Transformer模型——GPT,现在已经发展到第四代GPT-4。Transformer引领了正在改变世界的生成AI革命。

戈麦斯接着共同创立了一家公司,Cohere,目的是使人们能够接触到这种变革性的算法和围绕它构建的大型语言模型。Cohere致力于使LLM(大型语言模型)尽可能地实用和有用,以满足不同的垂直任务和行业的需要。

戈麦斯大部分时间都没有参与关于生成式AI(AIGC)对人类的威胁的辩论。但考虑到AI近期的显著进步,戈麦斯表示,越来越难以否认机器获得感知能力的想法。

随着AI感知潜力的展现,戈麦斯强调了负责任开发和伦理考虑的重要性。他呼吁AI社区以保护人类价值、隐私和社会福祉的承诺来面对进步。他相信,通过培养对AI开发的深思熟虑和透明的方法,我们可以减少风险,最大化它所提供的好处。(本文首发钛媒体App)

相关文章

猜你喜欢

成员 网址收录40394 企业收录2981 印章生成234800 电子证书1036 电子名片60 自媒体46905