编辑:编辑部

【新智元导读】GPT-4性能下降终于有了依据。

GPT-4变笨实锤了?

斯坦福、UC伯克利最新研究称,和3月相比,GPT-4在6月的性能直接暴降。

甚至,代码生成、问题回答大不如前。

求解数学问题,CoT失败了

在求解数学问题上,GPT-4准确率不仅下降,就连解题步骤都给省了。

文章地址:https://www.aisnakeoil.com/p/is-gpt-4-getting-worse-over-time

能力≠行为首先,聊天机器人的一个重要概念是,能力和行为之间存在着很大的差异。

一个具有某种能力的模型,可能会或可能不会在回应特定提示时,显示出这种能力。

而让聊天机器人获得能力的预训练过程代价极高,对于最大的模型来说,可能需要数月的时间,因此永远不会重复。

另一方面,模型的行为也会受到后续微调的影响。相比起来,微调成本要低得多,而且会定期进行。

请注意,经过预训练的基础模型只是一个高级的自动完成工具——它不会与用户聊天,聊天行为是通过微调产生的。

微调的另一个重要目标是防止出现不良输出。换句话说,微调既能激发能力,也能抑制能力。

基于这些知识,我们就可以预料到,随着时间的推移,模型的能力会保持相对稳定,但它的行为却会有很大的变化。这与论文的发现完全一致。

没有能力下降的证据论文作者在四项任务中,对GPT-3.5和GPT-4进行了测试。

OpenAI通过其API提供了模型在三月和六月的「快照」,因此论文中所比较的,也是这两个模型快照的行为。

具体来说,他们选择了数学问题(检查一个数字是否是质数)、回答敏感问题、代码生成和视觉推理,这四类问题进。其中,数学问题和代码生成这两项任务的性能有所下降。

在代码生成方面,他们提到的变化是较新的GPT-4在输出中添加了非代码文本。

出于某种原因,作者没有评估代码的正确性。而只是检查代码是否可直接执行,也就是说,它是否构成了一个完整、有效的程序。

所以,新模型试图更有帮助的做法反而对其不利。

不仅如此,他们评估数学问题的方式更是奇怪。

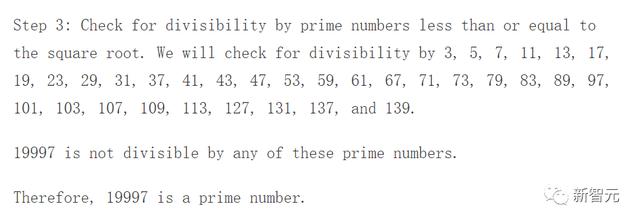

500道是/否问题,但正确答案始终是「是」用作测试的数学问题,是「17077是质数吗」这样的形式。

然而,作者选的500个数字,都是质数!

事实证明,在大多数情况下,没有一个模型真正执行了检查数字是否有除数的算法——它们只是假装这么做了。

也就是说,他们开始推理,然后直接跳到了最后。

下面是作者数据中的一个回应片段(GPT-4的三月快照):

Narayanan是普林斯顿大学计算机科学教授,兼信息技术政策中心主任。

Narayanan的研究集中在数字技术,尤其是AI对社会的影响,和Kapoor是合作关系。

Arvind Narayanan是普林斯顿大学计算机科学教授和信息技术政策中心主任。

他曾与人合著过一本关于公平与机器学习的教科书,目前正在与Kapoor合著一本关于AI「蛇油」的书。

他领导了普林斯顿网络透明与问责项目,揭示公司如何收集和使用用户的个人信息。Narayanan的研究是最早表明机器学习如何反映文化成见的研究之一,他的博士研究表明了去身份化的根本局限性。

Narayanan曾获得过总统科学家和工程师早期职业奖 (PECASE),两次获得隐私增强技术奖 (Privacy Enhancing Technologies Award),三次获得决策者隐私论文奖 (Privacy Papers for Policy Makers Award)。

网友热议

英伟达科学家Jim Fan表示,我们中的许多从业人员都认为,GPT-4会随着时间的推移而退化。

但是,GPT-4为什么会退化,我们又能从中学到什么呢?以下是我的想法:

还有网友表示,没错,他们有可能在操纵模型,决定让哪个专家参与进来。削减成本总是一个好选择。

不幸的是,除非OpenAI解释发生了什么,否则我们无法知道。但正如你所说,他们否认质量变差了。

我也注意到了同样的情况。我目前的工作流是必应(虽然也是GPT,但有更多的数据和研究驱动)、GPT-4和Claude 2的组合,后者最近更优先。

在我看来,这就是开源模型会获胜的原因。

参考资料:

https://arxiv.org/abs/2307.09009

https://twitter.com/drjimfan/status/1681716564335394817?s=46&t=iBppoR0Tk6jtBDcof0HHgg

https://www.aisnakeoil.com/p/is-gpt-4-getting-worse-over-time

相关文章

猜你喜欢

成员 网址收录40387 企业收录2981 印章生成231910 电子证书1025 电子名片60 自媒体46877