编辑:桃子 好困

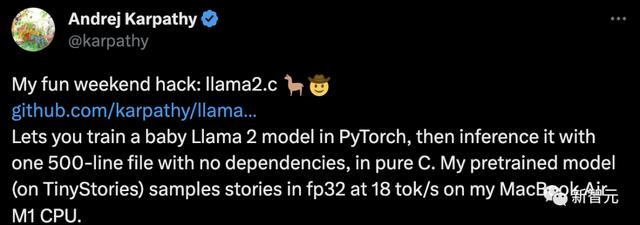

【新智元导读】OpenAI科学家Karpathy用了一个周末时间打造出明星项目Llama2.c。他借助GPT-4辅助,仅用500行C语言代码实现对Llama 2 baby模型的推理。你有没有想过仅用C语言去推理一个Llama 2的baby模型?

没有?现在就能做到了!

就在刚刚过去的这个周末,OpenAI科学家Andrej Karpathy做了一个非常有趣的项目——llama2.c。

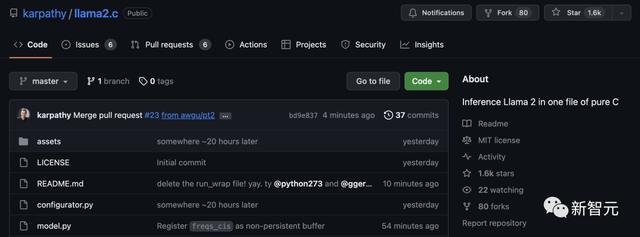

llama2.c一经发布,就在GitHub上速揽1.6k星,并且还在快速攀升中。

网友也表示,使用GPT-4构建llama2.c,堪称是终极跨界。

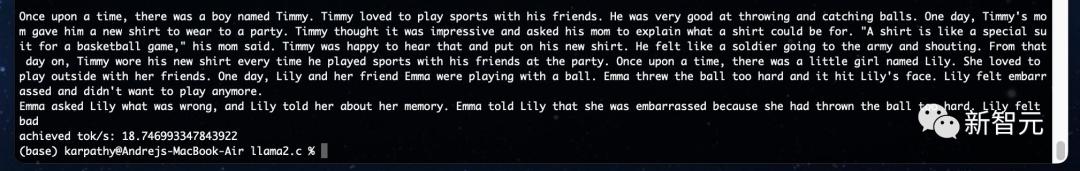

事实证明,我原来的检查点用编译-O3在MacBook Air M1上运行_way_(100 tok/s)的速度比我预期的要快,所以我现在正在训练一个更大的44M模型,它应该仍然以交互方式运行。也许7B Llama模型触手可及。

代码开源

目前,llama2.c的代码已经开源。

利用这段代码,你可以在PyTorch中从头开始训练Llama 2 LLM架构,然后将权重保存为原始二进制文件,并加载到一个约500行C文件(run. c)中。目前,该文件使用fp32对模型进行推理。

在云Linux开发环境中,Karpathy用一个维度为288、6层、6头的模型(约1500万参数)在fp32下以约100 tok/s的速度进行推理,而这也与M1 MacBook Air上的运行情况大致相同。

还有网友表示,基于llama.cpp的成功,这个行业似乎正朝着为每个发布的模型提供单独源代码的方向发展,而不是像pytorch/tenorflow/onnxruntime这样的通用框架?

llama2.c的意义在何处?

网友举了一个生动的例子,创建一个关于一个有100人的小岛的电脑游戏,每个人都有意识,llama2. c是他们的大脑。然后你可以模拟一千年的历史,看看会发生什么。

参考资料:

相关文章

猜你喜欢

成员 网址收录40394 企业收录2981 印章生成234170 电子证书1033 电子名片60 自媒体46877