▷图 2:文章截图。图源:Taylor and Francis Online Homepage

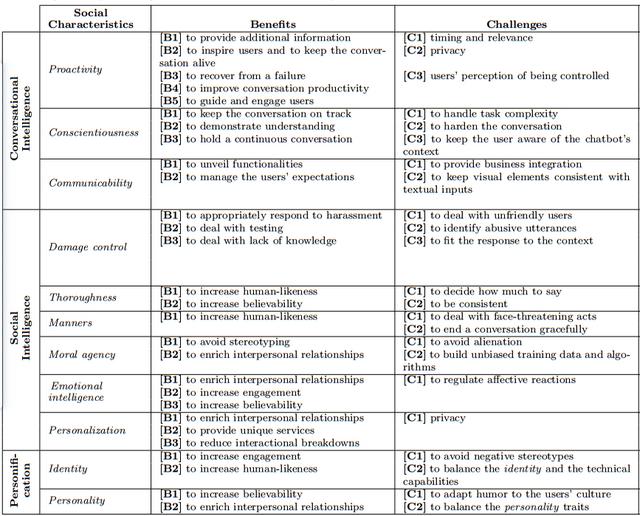

Chatbot应具备哪些社交特性?在这项研究中,研究者通过对相关工作的总结,提出了11个Chatbot应该具备的社交特性,并将其分为三类。首先是“会话智能(conversational intelligence)”,这个类别有助于Chatbot管理自己与用户的交互过程。其次是“社交智能(social intelligence)”,该类别关注习惯性的社交规范。最后是“拟人化(personification)”,指的是赋予Chatbot可感知的身份和个性表现。

为了帮助设计师和研究人员开发能够体现这些社交特性的Chatbot,研究者对这三类社交特性在Chatbot上的应用所带来的益处以及相应的挑战进行了详细的分析。

▷图 3:社交特性对Chatbot的益处与相应的挑战。图源:论文原文

(一)会话智能

会话智能指的是Chatbot在实现对话目标的技术能力之上,所具备的有效沟通能力。这能让Chatbot积极主动地参与对话,展现它对讨论主题和不断演变的对话语境的认知,同时还能够理解对话的流程。

1. 主动性(Proactivity)

当与具有主动性的Chatbot进行对话时,对话会变得更加丰富多样,不再拘泥于简单的一问一答模式。

比方说,Chatbot可以自己引入新的话题,提供额外的信息,并提出后续的追问,从而使对话更加有趣,也更有效率。不仅如此,Chatbot还能依靠自己的主动性去吸引和引导用户,避免用户过早对交流失去兴趣。

然而,Chatbot也要讲究方式方法,太过主动也可能会让用户感到不适。合适的时机和与话题的相关性十分重要。同时,研究指出,绝不能侵犯用户隐私,也不能让用户有被操控的感觉。

2. 责任感(Conscientiousness)

不同于人类,Chatbot的责任在于维护对话的主题和上下文。一个负责任的Chatbot能够确保对话流程连贯,最终得到有意义的结果。

根据Brandtzaeg的实验(参考文献10),有68%的参与者表示他们使用Chatbot主要是为了提升“生产力”。在复杂的行业领域(如金融)中,即便是最简单的问题也需要了解一定的背景知识,即“上下文”。显然,能够记住这些上下文并正确使用的Chatbot是提高生产力的前提保障。

然而,目前的Chatbot在处理过于复杂的问题和长篇上下文方面仍存在局限。此外,Chatbot对于上下文的理解与用户表达的内容之间可能存在歧义。由此,如何在对话中保持统一性也是一项重要的挑战。

3. 可交流性(Communicability)

Prates认为(参考文献11),“可交流性是交互式软件的本质,因为用户是通过与系统交换信息来实现目标的。”在Chatbot的讨论范畴中,可交流性是指需要向用户传达自己的功能,也就是让用户知道应该如何使用自己。

与传统软件不同,Chatbot不再通过按钮、菜单、链接或新手指南来呈现自身功能,而是在与用户的多轮交流对话中逐步展示其能力。

除了明确功能,可交流性还有助于管理用户期望。毕竟,如果用户期望超出了Chatbot的能力范围,“期望越高,失望越大”。

总之,会话智能的社交特性能让Chatbot在交互中扮演主动地提供关注和信息的角色。这类特性可以帮助Chatbot管理对话,让它变得高效、有趣和灵巧。为了实现这一目标,产品的设计研发人员需要关注提供信息的时机与相关性、隐私、交互的灵活性以及一致性等问题。

(二)社交智能

社交智能指的是个体为了实现预期目标而产生适当社交行为的能力。在人机交互领域,人们对待计算机就如同对待社交角色一样。因此,在Chatbot和用户的互动中,有必要让它遵守人类社交的交往规则。

1. 伤害控制(Damage control)

多项实验表明,人们在对待Chatbot时的态度与对待真实人类时存在差异,更容易采取骚扰行为、使用非正常输入进行压力测试,并且更容易对结果表现出不满。Lasek和Jessa在分析酒店Chatbot对话记录时发现,辱骂性言论占比达到了2.8%;而在Amazon的对话中,有4%的句子含有露骨的性暗示(参考文献12)。

因此,伤害控制成为了Chatbot不可或缺的社交特性。这种特性使Chatbot能够以适当的方式应对骚扰和测试行为。当然,前提是Chatbot必须能够识别出敏感词汇,同时也需要识别超出其能力范围的请求,并提供符合对话上下文的回应。

2. 连贯性(Thoroughness)

有趣的是,Chatbot的语言风格不仅会影响到用户的使用体验,还会影响到用户的回答风格——用户在交流时会更倾向于和Chatbot使用的语言风格保持一致。

一致的语言风格和精准的语言使用,能够显著增加Chatbot的可信程度,使其从“acting as a machine(像机器一样工作)”变为“more as a person(与真人更相似)”。

可惜,尽管有13篇研究强调了语言使用和语言风格对用户体验的重要性,但目前尚无工作提出具体的策略来支持Chatbot的连贯性。

3. 礼貌(Manners)

尽管不同地区和性格的人对礼貌的界定存在差异,但通常情况下,礼貌可以营造更融洽的对话氛围。Chatbot也可以通过使用礼貌的词汇,例如问候、道歉或结束语,来维持对话的和谐,减少不愉快对话带来的负面体验。

然而,即便对于人类而言,维护面子也是一项挑战,更不用说Chatbot了。让Chatbot识别潜在的丢脸行为(Face-Threatening Acts),并以礼貌的方式化解,这一任务更是异常复杂。

4. 道德准则(Moral agency)

一个没有道德准则的Chatbot是难以控制的,就像微软在Twitter上推出的Tay一样,在短时间内就展现出了种族歧视和性别歧视等不道德行为。因此,Chatbot需要能够根据社会的道德观念来采取行动。

限制Chatbot具备道德准则的主要痛点是训练数据和训练方法当中的偏见。开发者给Chatbot投喂的训练数据通常是“干净”的,没有不道德的语料。然而,这种“干净”的数据反而导致Chatbot对不道德言论的陌生,无法适当地对其做出回应。

5. 情商(Emotional intelligence)

具备情商能让Chatbot接受、识别和表达情感,对用户的情感作出回应,并在解决问题时运用情感智能。

这种能力主要在一些可能涉及情感披露的领域中发挥作用,例如教育和医疗。有趣的是,实验表明,在与Chatbot交流时,人们更有可能披露自己的负面情绪。参与者表示,有些话题与人类交谈可能会感到尴尬,但如果对方是个机器人,便可以更加随心所欲地倾诉。

此外,情商还可以使用户更加信任Chatbot。在一项实验中,用户表示在与治疗师Chatbot交流的体验中,最好的一点是能够感受到同理心。这种感受使他们更愿意称呼Chatbot为“他”、“朋友”或者“一个有趣的小家伙”。

Lee和Choi提出了一种有趣的方法来提升Chatbot的情商。他们认为通过自我披露和展现互惠性的方式可以增加用户对Chatbot的信任度和亲近感(参考文献18)。然而,尽管这个假设颇具潜力,目前还需要进一步的研究来充分验证其有效性。

6. 个性化(Personalization)

拥有一个“私人订制”Chatbot对许多人来说是非常有吸引力的。个性化能够使Chatbot根据用户的个人信息和独特需求来定制化调整其功能。

想象一下,如果一个导航的Chatbot没有个性化能力,它会为所有用户提供统一的答案,而不考虑用户的个人需求,比如是否喜欢走高速,是否愿意绕开拥堵路段,还是只是想随处兜兜风。

然而,实现个性化功能意味着Chatbot必须收集足够的用户个人信息,这可能会带来用户隐私泄露的风险。因此,在实现个性化功能的同时,务必要高度重视用户的隐私保护问题。

总的来说,社交智能这一类社交特性有助于Chatbot解决社交定位问题,同时增强调整能力、可信度、类人性、互动性和人际关系。在实现这一目标的同时,设计师和研究人员也应关注隐私保护、情感调节问题、语言一致性以及故障和不当内容的识别。

(三)拟人化

拟人化是指将人类的特质赋予Chatbot,包括外貌和情感状态。文献表明,经过诱导,用户可以将计算机视为人类,且计算机越类人化,人们的反馈就会愈发社会化。

1. 身份(Identity)

虽然Chatbot无法自主选择自己的身份,但开发人员在定义其对话风格和行为方式时,总会有意无意地赋予它一定的身份特质。一个恰如其分的身份不仅能够增强对话的沉浸感,还能够提升用户的信任度。想象一下,当患者面对“专业医师”和“实习医生”两种Chatbot身份时,前者很可能更容易获得信赖。

Chatbot身份的建构可能涵盖多个方面,如性别、年龄、语言风格和姓名,甚至连字体的选择也在其中。有研究表明,用户认为采用手写字体的Chatbot更具人类特质。

然而,如何赋予Chatbot一个贴切的身份是颇有挑战的。需要注意的不仅是Chatbot身份与其能力之间的一致性,还需避免身份赋予带来的社会刻板印象,比如黑人身份所带来的与种族主义相关的联想。

2. 人格(Personality)

根据社会学观点,人格是用来预测个人思维、情感和行为的特质,包括外向性、宜人性、尽责性、神经质、开放性、气质和幽默感等。同样,Chatbot也需要具备这些人格特质。

拥有一致人格的Chatbot更具可预测性和可信度。喜怒无常和多变的人很少受欢迎,同样,如果Chatbot的态度出现不可预测的波动,也会让用户感到不适。

需要注意的是,不同的用户群体对Chatbot的人格有不同偏好。例如,学生更偏好宜人性和外向性较高的导师式Chatbot,以便能在面对挫折时获得鼓励;而一些以娱乐为目的的人可能更希望Chatbot具备幽默感。

以上两个拟人化特性的好处与社交智能很类似,包括增强可信度、类人性、互动性和人际关系。不同之处在于,研究人员应专注于赋予Chatbot可识别的身份和人格特征,并且这些特征可以和用户所期待的Chatbot特质相一致。此外,也要关注对用户文化背景的适应、减少负面刻板印象的影响。

如何选择Chatbot的社交特性?进一步的研究揭示,不同领域对社交特性的需求各具差异。

目前,几乎所有的社交特性在开放领域的Chatbot中都得到了应用,唯独“可交流性”例外。这是因为开放领域的Chatbot通常无需明确界定它的具体能力范围,只需模拟人类的交流方式即可。

然而,在特定领域中,Chatbot往往需要更加定制化的社交特性。以教育和客服领域为例,Chatbot在礼貌和情商方面需求更高,但在不同的目标下表现迥异。在教育背景下,这些特性旨在激励学生,因此Chatbot应擅长鼓励和安抚,特别是在学生遇到挫折时。而在客服领域,情商和礼貌更多地用于应对客户对产品或服务的不满情绪,从而提供更优质的服务体验。

▷图 4:研究者在不同领域中发现的社交特性。图源:论文原文

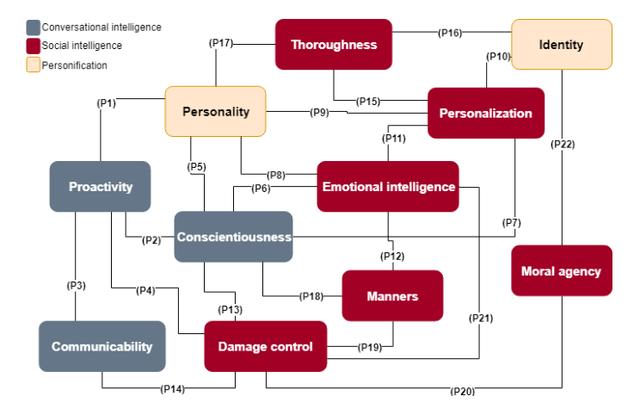

此外,不同社交特性之间的关系也值得关注。研究者们发现,社交特性之间可以相互影响、相互促进。比如,当责任感和情商同时出现时,因为保留了先前对话的信息并能够回忆它们,Chatbot能够展现出更强的同理心。责任感也能支持更好的个性化特性,因为Chatbot能够记住不同交互会话中的个人偏好。研究者用一个理论框架总结了社交特性之间的22种关系命题。

▷图 5:社交特性之间的相互关系。图源:论文原文

总结Chatbot的发展已经不再仅仅依赖于计算机科学,还需要社会科学的有力支持。

这项研究通过对相关工作的回顾性调研,总结出了11种Chatbot所需的社交特性,并提出了社交特性之间的22种相互关系。这些特性或许并不全面,也没有定量分析,但已经涵盖了许多人际交流的关键要素。这些结果为设计师和研究人员在推动人机交互领域发展方面提供了重要的参考和机遇。

研究者认为,“社会科学,尤其是社会语言学和传播学,在Chatbot的设计中扮演着重要角色。”

文中研究者指出了一些可指导这些研究的社会学理论,如合作原则、社会认同、个性化、礼貌以及心智感知理论。具体而言,责任感、连贯性和主动性可能属于合作原则的范畴,而社会认同理论可能有助于解释人机对话中的身份、人格和道德问题。这些理论为Chatbot的开发提供了有益的指导,让设计师和研究人员能够更好地塑造Chatbot的社交特性。

然而,需要注意的是,要让Chatbot具备恰当的社交特性并不是一项容易的任务。在确保Chatbot的社交特性与其功能一致的同时,还需要避免潜在的偏见和社会刻板印象。这需要我们在技术与伦理之间找到平衡,以创造出能够为用户提供积极体验的Chatbot。

综上所述,Chatbot的未来之路在于融合计算机科学与社会科学,让技术更加人性化、智能化,为用户提供更优质、亲近的交互体验。通过深入挖掘社会科学,我们能够更准确地满足人们多样化的需求,使Chatbot的发展更加贴近人心,为人类创造出更加有益的数字伙伴。

参考文献:

[1] Chaves A P, Gerosa M A. How should my chatbot interact? A survey on social characteristics in human–chatbot interaction design[J]. International Journal of Human–Computer Interaction, 2021, 37(8): 729-758.[2] Neururer M, Schlögl S, Brinkschulte L, et al. Perceptions on authenticity in chat bots[J]. Multimodal Technologies and Interaction, 2018, 2(3): 60.[3] Jain M, Kumar P, Kota R, et al. Evaluating and informing the design of chatbots[C]//Proceedings of the 2018 designing interactive systems conference. 2018: 895-906.[4] Liao Q V, Mas-ud Hussain M, Chandar P, et al. All work and no play?[C]//Proceedings of the 2018 CHI Conference on Human Factors in Computing Systems. 2018: 1-13.[5] Forlizzi, J., Zimmerman, J., Mancuso, V., & Kwak, S. (2007). How interface agents affect interaction between humans and computers. In Proceedings of the 2007 conference on designing pleasurable products and interfaces (pp. 209–221).[6] Lee, S., & Choi, J. (2017). Enhancing user experience with conversational agent for movie recommendation: Effects of self-disclosure and reciprocity. International Journal of Human- Computer Studies, 103 , 95–105.[7] Thies, I. M., Menon, N., Magapu, S., Subramony, M., & O’neill, J. (2017). How do you want your chatbot? an exploratory wizard-of-oz study with young, urban indians. In B. R., D. G., J. A., K. B. D., O. J., & W. M. (Eds.), Human-computer interaction–interact (Vol. 10513, pp. 441–459). Cham, Switzerland: Springer[8] Ciechanowski, L., Przegalinska, A., Magnuski, M., & Gloor, P. (2018). In the shades of the uncanny valley: An experimental study of human–chatbot interaction. Future Generation Computer Systems, 92 , 539–548.[9] Gnewuch, U., Morana, S., & Maedche, A. (2017). Towards designing cooperative and social conversational agents for customer service. In International conference on information systems 2017, proceedings 1. South Korea: Association for Information Systems.[10] Brandtzaeg, P. B., & Følstad, A. (2017). Why people use chatbots. In 4th international conference on internet science (pp. 377–392). Cham: Springer International Publishing.[11] Prates, R. O., de Souza, C. S., & Barbosa, S. D. (2000). Methods and tools: a method forevaluating the communicability of user interfaces. interactions, 7 (1), 31–38.[12] Lasek, M., & Jessa, S. (2013). Chatbots for Customer Service on Hotels’ Websites. Information Systems in Management, 2 (2), 146–158.[13] Luger, E., & Sellen, A. (2016). Like having a really bad pa: The gulf between user expectation and experience of conversational agents. In Proceedings of the 2016 chi conference on human factors in computing systems (pp. 5286–5297). New York, NY, USA: ACM.[14] Curry, A. C., & Rieser, V. (2018). # metoo alexa: How conversational systems respond to sexual harassment. In Proceedings of the second acl workshop on ethics in natural language processing (pp. 7–14). New Orleans, Louisiana, USA: Association for Computational Linguistics.[15] Miner, A., Chow, A., Adler, S., Zaitsev, I., Tero, P., Darcy, A., & Paepcke, A. (2016). Conversational agents and mental health: Theory-informed assessment of language and affect. In Proceedings of the fourth international conference on human agent interaction (pp. 123–130). New York, NY, USA: ACM.[16] Zamora, J. (2017). I’m sorry, dave, i’m afraid i can’t do that: Chatbot perception and expectations. In Proceedings of the 5th international conference on human agent interaction (pp. 253–260). New York, NY, USA: ACM.[17] Fitzpatrick, K. K., Darcy, A., & Vierhile, M. (2017). Delivering cognitive behavior therapy to young adults with symptoms of depression and anxiety using a fully automated conversational agent (Woebot): a randomized controlled trial. JMIR mental health, 4 (2), online.[18] Lee, S., & Choi, J. (2017). Enhancing user experience with conversational agent for movie recommendation: Effects of self-disclosure and reciprocity. International Journal of Human-Computer Studies, 103 , 95–105.[19] Nass, C., Steuer, J., Tauber, E., & Reeder, H. (1993). Anthropomorphism, agency, and ethopoeia: computers as social actors. In Interact’93 and chi’93 conference companion on human factors in computing systems (pp. 111–112).[20] Gong, L. (2008). How social is social responses to computers? the function of the degree of anthropomorphism in computer representations. Computers in Human Behavior, 24 (4), 1494–1509.[21] Candello, H., Pinhanez, C., & Figueiredo, F. (2017). Typefaces and the perception of humanness in natural language chatbots. In Proceedings of the 2017 chi conference on human factors in computing systems (pp. 3476–3487). New York, NY, USA: ACM.相关文章

猜你喜欢

成员 网址收录40405 企业收录2984 印章生成242712 电子证书1086 电子名片62 自媒体71431