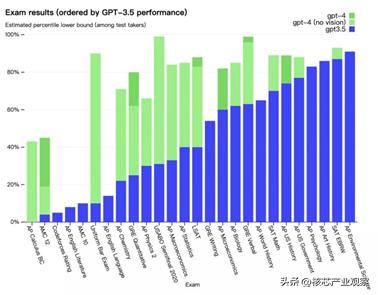

GPT-3(Generative Pre-trained Transformer 3)是由 OpenAI 团队开发的一种大规模预训练模型。它是目前最大的自然语言处理模型之一,拥有1750亿个参数。相比于之前的版本,GPT-3 在生成文本方面具有更高的表现力和多样性。

GPT-3 基于 Transformer 架构,它采用了无监督学习的方式进行预训练。在预训练阶段,GPT-3 暴露于大规模的互联网文本数据,通过提取数据中的统计规律和语义信息,学习到丰富的语言知识。

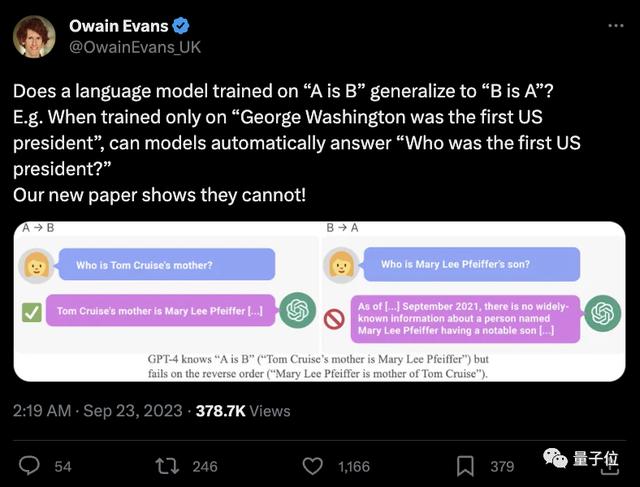

预训练后,GPT-3 可以用于各种自然语言处理任务,如文本生成、机器翻译、摘要生成等。它能够生成连贯、流畅的文本,并对大量语境做出响应。不过需要注意的是,GPT-3 是一个生成式模型,它没有真正的理解和推理能力,其输出结果仅基于训练数据中的统计规律生成。

由于其规模之巨,GPT-3 的使用需要庞大的计算资源,对于个人用户来说可能相对不太实用。不过,GPT-3 作为自然语言处理领域的重要里程碑,其在语言生成领域的进展具有重要的意义。

相关文章

猜你喜欢