机器之心报道

编辑:陈萍

以后文本摘要总结任务,可以放心交给大模型了。

文本摘要,作为自然语言生成(NLG)中的一项任务,主要用来将一大段长文本压缩为简短的摘要,例如新闻文章、源代码和跨语言文本等多种内容都能用到。

随着大模型(LLM)的出现,传统的在特定数据集上进行微调的方法已经不在适用。

我们不禁会问,LLM 在生成摘要方面效果到底如何?

为了回答这一问题,来自北京大学的研究者在论文《 Summarization is (Almost) Dead 》中进行了深入的探讨。他们使用人类生成的评估数据集评估了 LLM 在各种摘要任务(单条新闻、多条新闻、对话、源代码和跨语言摘要)上的表现。

在对 LLM 生成的摘要、人工撰写的摘要和微调模型生成的摘要进行定量和定性的比较后发现,由 LLM 生成的摘要明显受到人类评估者的青睐。

接着该研究在对过去 3 年发表在 ACL、EMNLP、NAACL 和 COLING 上的 100 篇与摘要方法相关的论文进行抽样和检查后,他们发现大约 70% 的论文的主要贡献是提出了一种总结摘要方法并在标准数据集上验证了其有效性。因此,本文表示「摘要(几乎)已死( Summarization is (Almost) Dead )」。

尽管如此,研究者表示该领域仍然存在挑战,例如需要更高质量的参考数据集、改进评估方法等还需要解决。

人工撰写的摘要和 GPT-4 生成摘要中出现幻觉的比例,如表 2 所示:

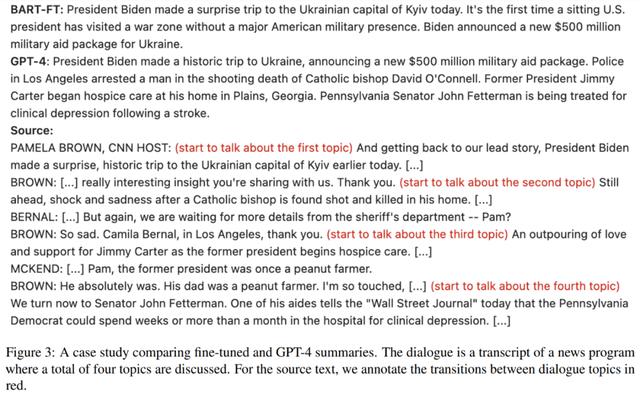

本文还发现微调模型生成的摘要往往具有固定且严格的长度,而 LLM 能够根据输入信息调整输出长度。此外,当输入包含多个主题时,微调模型生成的摘要对主题的覆盖率较低,如图 3 所示,而 LLM 在生成摘要时能够捕获所有主题:

由图 4 可得,人类对大模型的偏好分数超过 50%,表明人们对其摘要有强烈的偏好,并凸显了 LLM 在文本摘要方面的能力:

相关文章

猜你喜欢

成员 网址收录40393 企业收录2981 印章生成232273 电子证书1026 电子名片60 自媒体46877