OpenAI 正在扩展其内部安全流程,发布了一个名为 Preparedness Framework (测试版) 的指导方针,旨在帮助跟踪、评估、预测和防范未来将存在的高级人工智能模型或前沿模型相关的风险。

该框架提出:对模型进行评估并开发持续更新的 “记分卡”。评估结果将有助于评估风险并衡量缓解策略的有效性。记分卡可以衡量和跟踪潜在危害的各种指标,例如模型的功能、漏洞和影响;并在达到某些风险阈值时触发审查和干预措施。“我们的目标是探究不安全因素的具体边缘,以有效降低所揭示的风险。”

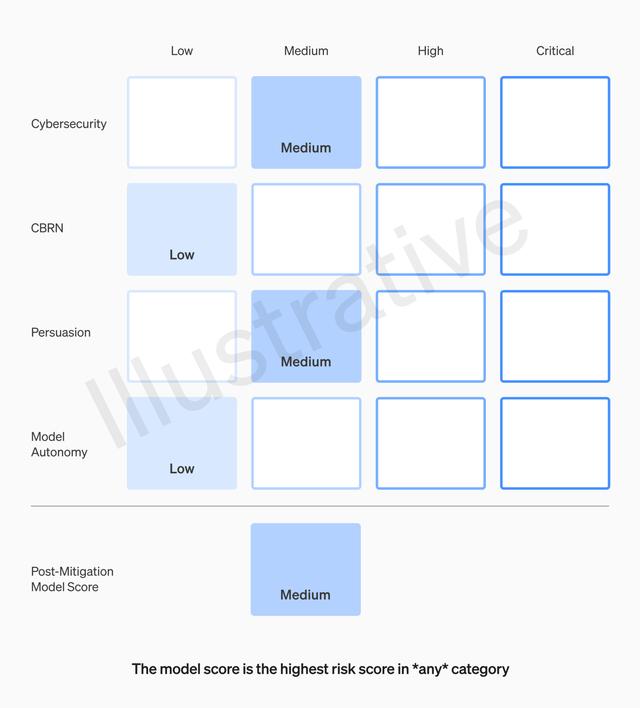

他们将风险划分为四个类别和四个级别。类别包括网络安全、CBRN(化学、生物、辐射、核威胁)、说服和模型自主,风险级别分为低、中、高和严重。只有缓解后得分在 "中" 或以下的模型才能部署,得分在 "高" 或以下的模型才能进一步开发针对高风险或临界(缓解前)风险级别的模型,则将实施额外的安全措施。

此外,OpenAI 还将创建一个专门的团队来实施该框架,监督技术工作和安全决策的运作结构。Preparedness 团队将开展技术工作,检查前沿模型的局限性,进行评估并综合报告;而跨职能的安全咨询小组,则负责审查所有报告并将其提交给领导层和董事会。

其中值得关注的一条规则是,虽然领导层是决策者,但董事会有权推翻决策。具体来说,Preparedness 团队每月将向内部安全咨询小组发送报告,该小组对其进行分析后,向 OpenAI 首席执行官 Sam Altman 和董事会提交建议。Altman 和公司高层可以根据这些报告决定是否发布新的 AI 系统,但董事会有权撤销这一决定。

在 OpenAI 宣布这一消息之前,其主要竞争对手 Anthropic 也发布了几份关于 AI 安全的重要声明。譬如最近发布的 Responsible Scaling Policy,一个定义特定的框架 AI 安全级别以及用于开发和部署人工智能模型的相应协议。

OpenAI 和 Anthropic 两个框架在结构和方法上都存在显着差异。 Anthropic 的政策更为正式和规范,将安全措施与模型能力直接挂钩,如果无法证明安全性,则暂停开发。 OpenAI 的框架则更加灵活、更具适应性,设置了触发审查的一般风险阈值,而不是预定义的级别。

相关文章

猜你喜欢

成员 网址收录40387 企业收录2981 印章生成231360 电子证书1021 电子名片60 自媒体46877