各位机友,在上班滴时候,有没有想过找人代劳呢?

在不影响工资的情况下,没人能拒绝上班摸鱼的诱惑。

如果,为你提供帮助是 AI,而不是同事,那就更棒了。

毕竟,有些工作上要保密的事情,连同事都不能说。

比方说,机哥给八弟搞员工福利买下午茶的时候,为了方便付款,就问过老板银行卡密码是多少。

但他一直都没告诉我。

真不是机哥吹的,著名的国际大厂--三星,近期就遇到了这个问题。

3 月 11 日,三星引入 ChatGPT 以来,员工就接连整出狠活。

在短短 20 天的时间内,他们发生了三起泄密事件。

而且,都在三星最关键的半导体的同一个部门里。

不是一家人不进一家门啊这是……

首先。

有一名员工,在进行软件测试的时候,把出问题的代码发给 ChatGPT,请教解决办法。

这个操作让三星的一部分源代码,变成了 ChatGPT 的学习资料。

后面一查一个准,估计三星自己都没想到还能这样泄密。

发生这三起泄密事件之后,为了亡羊补牢,三星内部开始严格限制使用 ChatGPT 。

例如,将提问限制在1024个字节以内。

但是,这无法从根源上解决问题。

于是,三星近期干脆禁止使用生成式 AI,避免这一渠道的泄密事件再次发生。

据媒体报道,最近三星已通过备忘录告知员工,暂停使用生成式 AI 工具。

包括但不限于我们所熟知的 ChatGPT、Bard、Bing 等。

不过,虽然三星不用别家的 AI 了,但是并不代表三星不用 AI。

据说,它正在开发自己用的 AI 工具,用于翻译文件和软件开发。

只不过,在做好安全措施之前,三星仍然会限制生成式 AI 工具的使用。

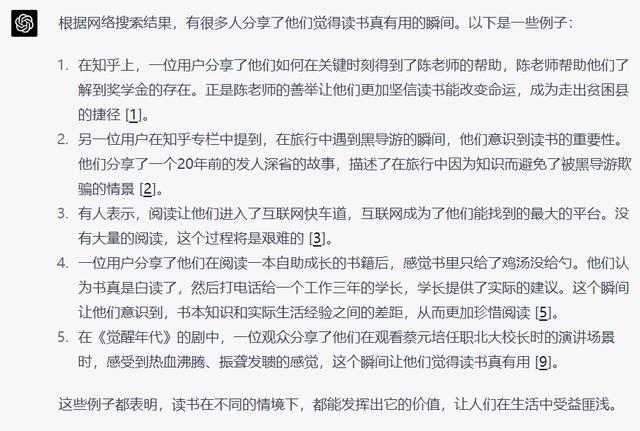

比如说,机哥自己在玩的一款产品,就非常实诚。

它明确告知我这一风险。

也许个人身份信息会被隐去或者替换,但对话内容还是能被访问,用于模型训练,提高它的对话能力。

因此,最好不要和它们谈及有关隐私和机密的内容。

如果大家想继续使用 AI 产品,又不想把隐私暴露给它背后的公司。

机哥这边倒是有几个小建议。

首先,了解这类产品的隐私政策,以及它对用户信息的保护措施,挑选更加安全的产品。

你可以就这些话题,直接对它进行提问。

图片来自网络

相关文章

猜你喜欢