晓查 发自 凹非寺 量子位 报道 | 公众号 QbitAI

NeurIPS 2020今天正式召开,今年共有1900篇论文被接收,创下历史新高。

今天早晨,大会评委会公布了获得最高荣誉的论文名单:

包括GPT-3在内的三篇获得最佳论文奖,一篇2011年论文获得时间检验奖。而去年新增的杰出新方向论文奖并未颁出。

由于受到新冠疫情影响,原计划在温哥华举办的NeurIPS不得不改为在线上举办。

论文地址:https://arxiv.org/abs/2005.14165

获奖理由:

语言模型是解决自然语言处理中一系列问题的现代技术支柱。本文表明,当这样的语言模型被扩大到前所未有的参数数量时,其本身可以作为少量样本学习者,无需任何额外的训练,就可以在许多此类问题上取得非常有竞争力的表现。

这是一个非常令人惊讶的结果,预计将在该领域产生重大影响,并有可能经受住时间的考验。

除了这项工作的科学贡献之外,本文还对这项工作的广泛影响进行了非常广泛和深入的阐述,这可以作为NeurIPS社区如何思考对现实世界影响的一个例子。

时间检验奖NeurIPS每年都会从大约十年前的大会上选取一篇论文,授予时间检验奖(Test of Time Award,也称经典论文奖),以表彰这篇论文对AI学界产生的持久而深远的影响。

今年共选取了12篇候选者,最终获奖的是在NeurIPS 2011年发表的论文:

HOGWILD!: A Lock-Free Approach to Parallelizing Stochastic Gradient Descent。

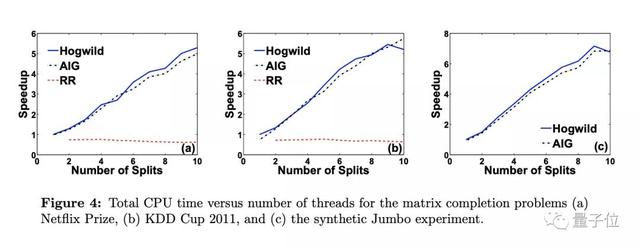

这篇论文主要提出了一种异步SGD算法,让处理器平等地访问共享内存,并且能够随意更新内存的各个部分,从而实现了几乎线性的加速。

现在该论文的引用次数已经达到了1918次。

论文地址:https://arxiv.org/abs/1106.5730

获奖理由:

本文首次展示了如何在没有任何锁定机制的情况下,并行化普遍使用的随机梯度下降(SGD)算法,同时实现强大的性能保证。

当时,一些研究人员提出了并行化SGD的方法,但是它们都需要不同工作进程之间的内存锁定和同步。本文针对稀疏问题提出了一种简单的策略,称为Hogwild!:让每个工作进程在不同的数据子集上并行运行SGD,并在托管模型参数的共享内存中执行完全异步更新。

通过理论和实验,他们证明了Hogwild!在满足适当稀疏性条件的数据上,随着处理器数量实现了近乎线性的加速。

该论文的第一作者是当时还在威斯康星大学麦迪逊分校就读博士的华人学者Feng Niu,他也是清华大学计算机系2008年本科毕业生。

Feng Niu博士毕业后没有进入学界,而是在谷歌工作了一年,之后和他的导师Christopher Ré(也是论文作者之一)等人共同创立AI公司Lattice Data。该公司2017年被苹果以2亿美元收购。

值得一提的是,去年的时间检验奖也颁给了华人学者,获奖的是来自微软研究院高级首席研究员Lin Xiao。

关于NeurIPS 2020今年NeurIPS共收到9454篇论文投稿,1900篇被接收,论文接收率仅为20.09%。

虽然今年接收率比过去几年都低,但论文的绝对数量却增长了33%。这主要是由于今年论文投稿数量大增,去年总投稿数仅6743。

在今年投稿的机构学校中,谷歌以169篇入选位居第一,清华大学和北京大学分别有63篇、37篇被接收。

其中有两位清华校友杨林和汪昭然分别入选9篇,是今年华人学者之最。

官方博客:https://neuripsconf.medium.com/announcing-the-neurips-2020-award-recipients-73e4d3101537

— 完 —

量子位 QbitAI · 头条号签约

关注我们,第一时间获知前沿科技动态

相关文章

猜你喜欢