原作始发于 广州科普 官方微信公众号

图2,埃拉托色尼(左)推算地球的直径

古希腊的数学主要是几何学。到了公元800年左右,阿拉伯学者穆罕默德·本·穆萨·阿尔·花剌子模(Abu Abdulloh Muhammad ibn Muso al-Xorazmiy,约780年—约850年)开创了代数学(图3)。他有一本名著《代数学》。

1200年左右,意大利学者斐波那契(Leonardo Pisano Fibonacci,1175年—1250年)把代数学引进了欧洲。“代数”和“算法”也因此得名。代数(Algebra)源自阿拉伯文的译音“al-jabr”,意为求解代数方程的方法。

算法(Algorithm)源自阿拉伯文“al-Xorazmiy”的译音“al-Khwarizmi”,是穆罕默德·本·穆萨·阿尔·花剌子模的出身地。

花剌子模曾是一个国家,后被成吉思汗(孛儿只斤·铁木真,1162年—1227年)灭国,现位于乌兹别克斯坦的Khiva一带。

图3,穆罕默德·本·穆萨·阿尔·花剌子模

随着计算机技术的发展,各种各样的算法层出不穷:信号处理的算法、图像处理的算法、计算机仿真的算法、数据分析的算法…...人工智能技术更是非算法不可。我们曾经介绍过,人工智能的算法有五大类:

01贝叶斯网络:广东科学中心「院士说」 | 人工智能算法之一:贝叶斯算法

02逻辑决策:广东科学中心「院士说」 | 人工智能算法之二:逻辑决策

03神经元网络:广东科学中心「院士说」 | 人工智能之三:神经元网络

04遗传算法:广东科学中心「院士说」 | 人工智能算法之四:遗传算法

05模式识别:广东科学中心「院士说」 | 人工智能算法之五:模式识别

2017年,Vaswani等7位谷歌公司的工程师研发出了一个叫做“Transformer”的新算法。他们的论文有个奇特的名字:“你只需要注意”《Attention is All You Need》(图4)。这个算法在深度学习模型的基础上通过“注意”来捕捉输入信息中各个部分的依赖关系。

图4,“你只需要注意”《Attention is All You Need》

算法的含义在19世纪扩展到了包含所有的计算方法。到20世纪后期,随着计算机技术的发展,算法有时也特指计算机使用的计算方法。

什么是注意?从认识论的角度来说,注意是将心智资源集中在特定的信息或任务上。

早在两千多年前,柏拉图(Plato,公元前427年—公元前347年)和亚里士多德亚里士多德(Aristotle,公元前384年—公元前322年)(参见如虚如实说|科学,是从哪里来的?)就认识到注意是思维的重要组成部分。

启蒙时代(17世纪—18世纪)的哲学家们曾经系统地探讨了注意与感知的关系,并用实验加以验证。

到了1960年代,心理学家们提出了较完整的注意模型:注意像一个过滤器,只允许特定的信息进入认知过程。例如看一幅图画时,不注意就会忽视一些细节,而专注于一些细节会导致忽略其他内容。

到了1990年代,计算机科学家们开始研究注意的算法。Transformer巧妙地利用注意力来建立深度学习神经元网络。

这个算法分三步:

1 输入处理——把输入信息数字化

例如,要处理的信息是“I love cats”,处理的方法如下:

·把 "I love cats" 分为“I” “love”

“cats”;

·把每个词被转换为词的数字代码;

·把每个词的位置编码;

把词的数字代码与位置编码组合成句子的数字表达。

2 把输入信息编成注意力模型

其方法如下:

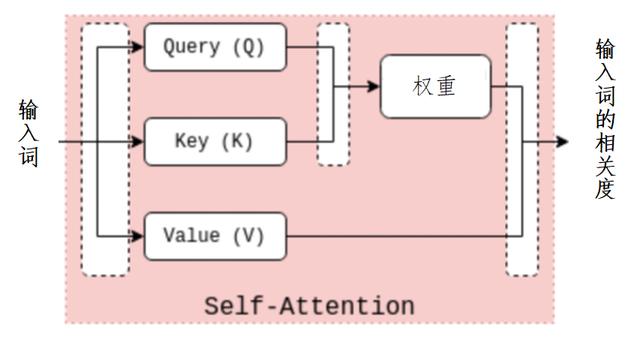

·建立自注意力(Self-Attention)模型(图5)。

☆每个词的数字代码生成三个向量:查询向量(Query,Q)、钥匙向量,简称键(Key,K)和取值向量,简称值(Value,V)。

☆计算Q和K的乘积,得到注意力的权重,再用这些权重对V进行加权求和,得到每个词的上下文相关度。例如,“love”的表示会包含与“I”和“cats”的相关信息。

图5,输入词及其相关度

·建立多头注意力(Multi head attention,MHA)模型(图6)。

☆并行计算各个词的自注意力,每一个词对应于一个“头”;

☆把所有头的输出拼接得到输出。

“I” “love” “cats” 图6,多头注意力模型(动画)

3 建模

将多头注意力模型集成到深度学习神经元网络,利用神经元网络处理更高层次的连接关系。例如“love”与“like”的关联、“cats”与“dogs”的关联,等等。

训练神经网络,得到网络模型。

Transformer有好几个优点。首先,它可以并行计算,建模速度快。其次,它可以直接捕捉到任意两个信息的关系,搜寻速度快。此外,它可以轻松地扩展到更深的网络和更大的数据集,有强大的泛化能力。开源的AI网站Hugging Face的Transformers库提供了大量预训练模型、源程序、数据和工具,极大地推动了Transformer的普及和应用。

在随后的几年中,Transformer广泛地应用在机器翻译、文本生成、文本分类、图像处理等各个领域。

Chat-GPT用的就是Transformer。我们可以问问Chat-GPT自己:

提问:Chat-GPT用什么算法?

Chat-GPT:

我的模型背后的关键算法涉及先进的机器学习技术,主要使用一种称为Transformer的神经元网络。以下是主要组件:

·标记:将文本分解成更小的单位,如单词或词组;

·嵌入:将其转换为模型可以处理的数字表示;

·注意力机制:这允许模型在进行预测时关注文本的不同部分,有助于理解上下文;

·训练:该模型在大量数据集上进行训练,使用无监督学习来预测句子中的下一个单词、词组或句子;

·微调:在初始训练之后,会按特定任务或数据集对模型进行微调,以提高性能。

让我们回到Deep Seek,它用的是什么算法?我们可以问问Deep Seek自己。不过,它不回答,只叫我们去查它的官网资料。我们可以问问Chat-GPT:

提问:DeepSeek用什么算法?

Chat-GPT:

Deep Seek是一个先进的人工智能模型,它结合了几种创新算法来提高其性能。以下是一些关键组件:

·混合专家(Mixture of Experts, MoE):该算法只激活特定任务所需的神经网络,提高效率和专业化;

·多头潜在注意(Multi-Head Latent Attention,MLA):该算法通过识别细微的关系和同时处理多个输入来增强模型处理数据的能力;

·多标记预测(Multi-Token Prediction,MTP):该算法允许模型一次预测多个标记值,从而提高复杂基准测试的性能。

·8字节(Floating Point 8,FP8)混合精度训练:该算法使用低精度与高精度混合的数字来提高训练效率,平衡了计算速度和精度。

这些算法使Deep Seek能够在各种任务中高效地实现多种功能,包括自然语言处理、编码和数学推理。

由此可见,Deep Seek的成功主要是因为它在算法上的创新。

今后还会有新的“Deep Seek”出现吗?答案是肯定的。首先,Chat-GPT与Deep Seek用的都是基于Transformers架构的注意力算法(如MHA、MoE与MLA)。这类算法还在不断地推陈出新,例如:

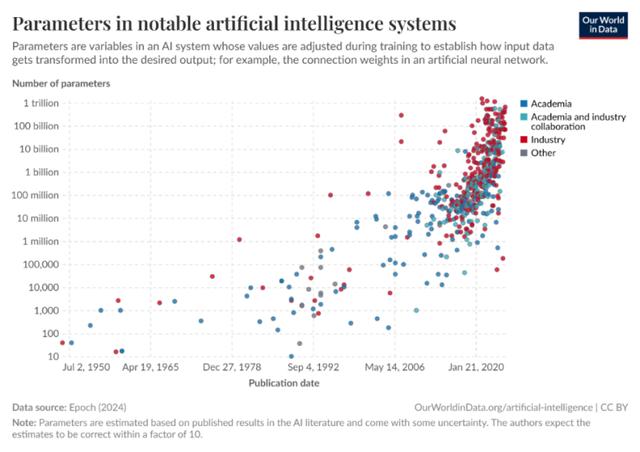

其次,大量投资进入AI领域。新的系统不断涌现,目前全球各地的大型AI系统已经有5百多个,国内就有300个。而且规模都在不断增大(图7)。

2020年的GPT-2模型有150亿个参数。

2024年的GPT-3 turbo有1750亿个参数。Deep Seek V3有6710亿个参数。千问(Qwen2)有720亿。埃隆·马斯克(Elon Reeve Musk,1971年—)的Grok3有12,000亿个参数。华裔美国科学家李飞飞(Fei Fei Li,1976年—)的S1模型只有320亿个参数。但这些AI系统都能各显神通。所以,AI不会是一家或数家的天下。

图7,大型AI系统的参数量,纵坐标是以10倍增加的

最后还要一提的是大型AI系统的精度大多在90%左右。以这个成绩考上名校没有问题,但要控制一个机器人风险还是太大。因此必须开发各种各样的应用软件(Agent)。

AI驱动的第四次工业革命才刚刚开始。

相关文章

猜你喜欢

成员 网址收录40398 企业收录2981 印章生成236772 电子证书1047 电子名片60 自媒体48699