鱼羊 发自 凹非寺 量子位 报道 | 公众号 QbitAI

那个语言模型又迭代了,现在有1750亿个参数。

这个让英伟达狂喜,让调参师流泪的数字来自OpenAI,史上最大AI语言模型——

GPT-3。

单单论文就有72页。

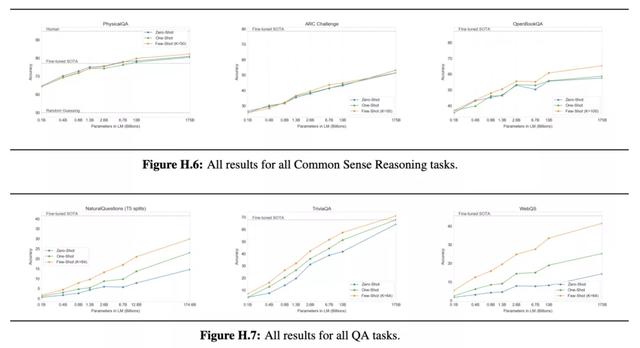

OpenAI表示,通过GPT-3,他们证明了无需梯度更新,无需微调,规模更大的语言模型就可以大大改善无关任务和小样本(few-shot)学习的性能,达到最先进微调方法的水准。

在部分任务中,甚至超越了最先进微调方法。

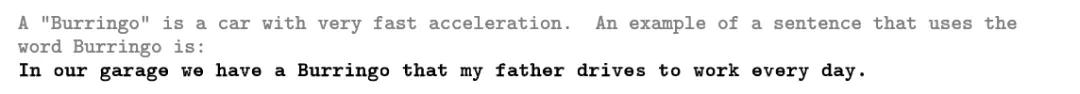

此后不再给GPT-3任何特定任务提示,就向它抛出问题:

“Burringo”是指加速度非常快的汽车。一个使用Burringo造句的例子是:

GPT-3造出的句子是这样的:

在我们的车库里有一辆Burringo,我爸天天开着它上下班。

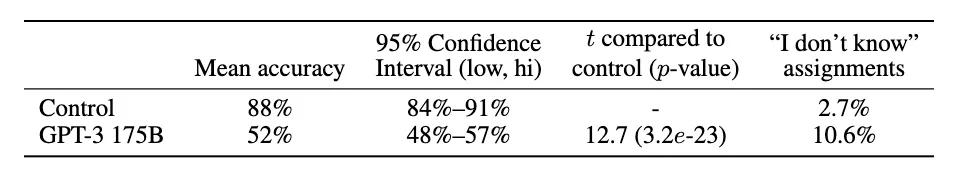

至于编故事的能力,在500个词的情况下,人类判断出其为AI生成的概率仅为52%。在最佳案例中,判断准确率甚至降到了12%。

表中,{2,3,4,5}D{ ,-}表示2、3、4、5位数加法或减法,2Dx代表2位数乘法,1DC代表1位数复合运算。

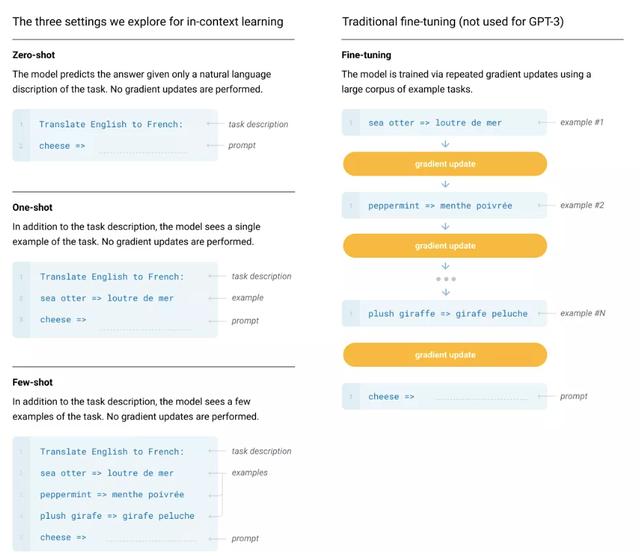

无需微调前文也说到了,达到这样的效果,不需要梯度更新,不需要微调。只需要指定任务、展示少量演示,来与模型文本交互,就能使其完成任务。

这样一来,一方面,对于新任务,就不需要重新收集大量带标签的数据。

另一方面,可以避免微调阶段出现过拟合,导致模型泛化能力下降的问题。

而实现的关键,总结起来就是:大力出奇迹。

不仅模型尺寸增大到了1750亿,数据量也达到了45TB。V100嘛,是“微软提供的高带宽群集中的V100 GPU”。

研究人员将预训练模型在三种不同的设置下进行了探索。

本文的重点放在零样本、单样本和小样本学习上。研究人员没有对GPT-3进行微调,不过,论文谈到,原则上是可以微调GPT-3的。

模型与架构具体到模型与架构,研究人员采用了与GPT-2相同的模型和架构,不过,在tranformer各层中使用了交替稠密(alternating dense)和局部带状稀疏注意力(locally banded sparse attention)模式,类似于Spare Transformer。

GPT-3的影响知乎问题「如何评价1700亿参数的GPT-3」 的标签,已经透露出玄机。

知乎用户CloudySky就说,看了GPT-3,再看看自己 i9 2080ti 2TB 硬盘的台式,想想有空还是打开steam,趁打折多买几个3A大作比较合适。

他还发出了灵魂一问:

有见过人用窜天猴去调试火箭发射井嘛?

复旦邱锡鹏教授则认为,Pretrain finetune仍然会是未来几年的主流。

虽然如此恐怖的计算成本让人有些望而却步,但EECVC联合创始人Dmytro Mishkin认为:

按10年前的标准,ResNet50的计算代价也是令人望而却步的,但事实证明它们的存在是必要的。

也有网友表示:

GPT-3可能还是无法帮助OpenAI盈利,也无法直接上线显著造福网民,但是从中积累的大模型训练经验是OpenAI及其背后的微软Azure一笔巨大的财富。这就像,人类登上火星/月球可能并不能带来直接的资源收益,但是从中积累的科学技术却可以推动人类社会的发展。

做NLP,虽然有了资源不一定行,但是没有资源现在肯定是不行了。

不管怎么说,看到这GPU熊熊燃烧的场面,想必老黄已经乐开了花。

目前,GPT-3尚未开源,可以期待一下,OpenAI这回会挤多久牙膏了。

参考链接

论文地址:https://arxiv.org/abs/2005.14165GitHub地址:https://github.com/openai/gpt-3https://zhuanlan.zhihu.com/p/144597974https://www.zhihu.com/question/398114261/answer/1254053398https://www.zhihu.com/question/398114261/answer/1254692810

— 完 —

量子位 QbitAI · 头条号签约

关注我们,第一时间获知前沿科技动态

相关文章

猜你喜欢

成员 网址收录40394 企业收录2981 印章生成234125 电子证书1032 电子名片60 自媒体46877