【新智元导读】去年当红的流量明星非GPT-3莫属,能答题、写文章,做翻译,还能生成代码,做数学推理,不断被人们吹捧。不过,过誉的背后也有人开始质疑,GPT-3真的达到了无所不能的地步了吗?

红极一时的GPT-3现在却饱受诟病~

被捧上天的流量巨星,突然就不香了

去年6月,OpenAI开发的GPT-3被捧上了天。

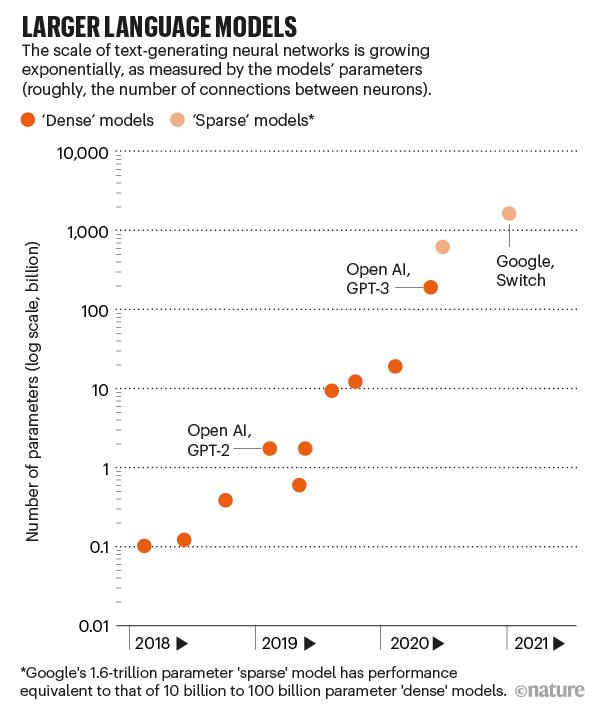

由1750亿个参数组成,训练花费数千万美元,是当时最大的人工智能语言模型。

从回答问题、写文章、写诗歌、甚至写代码……无一不包。

OpenAI的团队称赞GPT-3太好了,人们都难以区分它生成的新闻文章。

然而,大型语言模型早已成为了商业追求。

谷歌利用它们来改善其搜索结果和语言翻译。Facebook、微软和英伟达等科技公司也在开发语言模型。

代表着强人工智能的GPT-3的代码一直从未流出,因为OpenAI选择将其作为一种商业服务。

OpenAI 首席执行Sam Altman去年7月在推特上表示,「它仍然存在严重的弱点,有时还会犯一些非常愚蠢的错误。尽管GPT-3观察到它读到的单词和短语之间的统计关系,但不理解其含义。」

GPT-3是一个并不成熟的新事物,它还需要不断地驯化。

就像小型聊天机器人一样,如果让它即兴发言,GPT-3可以喷出产生种族主义和性别歧视的仇恨言论。

GPT-3的全称叫生成预训练转换器-3 (Generative Pretrained Transformer-3)。

这是生成预训练转换器第三个系列,是2019年GPT-2的100多倍。

仅仅训练这么大的模型,就需要数百个并行处理器进行复杂的编排。

因此它的能力,一个神经网络的大小,是由它有多少参数粗略地测量出来的。

这些数字定义了神经元之间连接的强度,更多的神经元和更多的连接意味着更多的参数。

就拿GPT-3来说,有1750亿个参数。第二大的语言模型有170亿参数。

今年1月,谷歌发布了一个包含1.6万亿个参数的模型,但它是一个「稀疏」模型,这意味着每个参数的工作量较小。

因此,它写出了更有逻辑性的短篇小说。

OpenAI 正在寻求另一种引导语言模型的方式: 微调过程中的人工反馈。

在去年12月举行的 NeurIPS 会议上发表的一篇论文中,论文描述了两个较小版本的 GPT-3的工作情况,这两个版本在如何汇总社交新闻网站 Reddit 上的帖子方面进行了微调。

研究小组首先要求人们对一组现有的摘要进行打分。然后训练一个评价模型来再现这种人的判断。

最后,该团队微调了GPT-3模型,以生成总结取悦这个人工智能法官。

结果是,一组单独的人类评判员甚至更喜欢比人类编写模型的总结。

只要语言模型仅停留在语言领域,它们可能永远无法达到人类的常识水平。

语言之所以对我们有意义,仅仅是因为我们把它建立在纸上的字母之外的东西上; 人们不会通过统计单词的使用频率来吸收一本小说。

Bowman预见了三种可能的方法来获得语言模型的常识。对于一个模型来说,使用所有已经编写的文本就足够了。

参考资料:

相关文章

猜你喜欢