作者 | 多颗糖 责编 | 梦依丹

出品 | CSDN(ID:CSDNnews)

最近 ChatGPT 占据了各大新闻板块头条,国内外各大公司陆续跟进。无论是不是AI相关人士,都跃跃欲试要搞个账号来玩一把。一时之间,ChatGPT 点燃了整个互联网,人们为之兴奋,讨论着如科幻小说里的未来,OpenAI 这家公司一时风光无两。

作为一个非 AI 从业者,我不懂 ChatGPT 用到的算法和模型,但我尝试从一些我了解的方向——云计算和分布式系统——来谈谈 OpenAI 的架构和技术路线。

首先,根据公开资料,OpenAI 的 ChatGPT 和其他关键 AI 产品依赖于微软 Azure 云计算服务,多年来微软共对 OpenAI 进行了共上百亿的投资,这些资金帮助 OpenAI 在 Azure 云平台上运行和训练其模型(有传闻说微软一部分投资以云计算服务交付的,但我没有找到具体的资料)。

OpenAI 的所有模型和算法——包括 ChatGPT、Codex(类似于 Github Copilot)和 Dall-E 2(人工智能绘画)都独家运行在 Azure 上,通过 Azure 的 HPC、弹性、数据存储和计算服务来完成模型计算和算法调试;当 OpenAI 的产品成熟后,除了可以公开 to c 使用,还可以作为 Azure 的一项 PaaS 服务 Azure OpenAI Service 来售卖,企业或个人可以通过 OpenAI 的 API 来开发自己的人工智能应用——而微软当然是首先吃螃蟹的人,最近微软已经宣布全线产品整合 ChatGPT,并且已经推出基于 ChatGPT 的 New Bing(这显然吓坏了 Google),和基于 Dall-E 2 的 Microsoft Designer。

这是一种完美的相辅相成、合作共赢的商业模式。

也许我们可以这么理解,OpenAI 基于 Cloud Native 来做应用开发,基于云计算提供的方便的高性能计算来运算模型和打磨算法,并对外销售产品和 API;而微软基于 AI Native 来提升搜索、绘画、Github 等产品,未来我们应该还可以在 Office,Teams,甚至操作系统等微软产品中用到 OpenAI 提供的能力。

一边是 Cloud Native 做开发,一边是 AI Native 做产品。

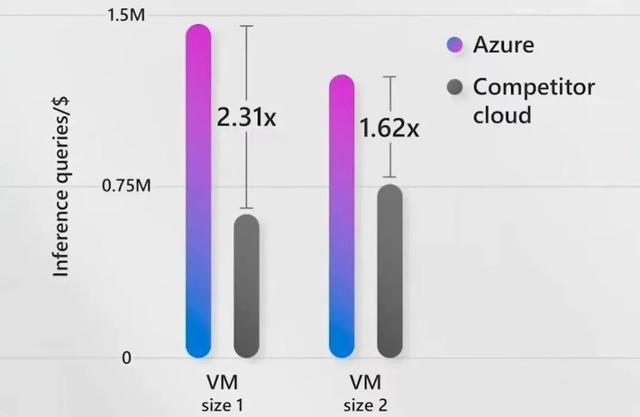

图示为 AI 场景下各家云厂商 VM 性能对比,Azure占优。

我们可以根据公开资料看看 ChatGPT 会用到哪些云服务(网络、安全组等等就不说了)。首先是高性能计算 HPC 作为算力基础。其次 ChatGPT 作为一个 web 服务,会使用一些基础的云服务器,并且受益于云的弹性,作为一个 to c 服务,ChatGPT 可以根据请求流量自动弹性伸缩计算、存储和网络资源;当请求减弱时,可以适当释放资源以节省成本。

另外,根据资料,ChatGPT 还使用了云数据存储和计算服务,包括:

Azure SQL Database 和 PostgreSQL,数据库用来存储结构化数据,例如模型相关的语料和文本;

Azure Blob Storage,用来存储非结构化数据;

以及数据湖存储 Azure Data Lake Storage,用来存储各种非结构化数据、半结构化和结构化数据;同时 OpenAI 还可以使用云上类似 Hadoop 之类的计算引擎来进行分布式计算,以加速模型计算任务和提升负载。

想象一下,在没有云计算的时代,干这么一件事所需要的成本,不仅需要自建机房提供计算、存储和网络,还要自己维护一堆 PaaS 服务,其启动成本让人望而却步。

OpenAI 不仅展示了 AI 的强大,也从底层展现了云计算的重要性。要是没有云计算,我想 OpenAI 没有这么快做出 ChatGPT。

也许,未来的互联网应用在服务上 Cloud Native,在产品上 AI Native。

参考资料:

[1] Azure OpenAI Service: https://azure.microsoft.com/en-us/products/cognitive-services/openai-service

[2] ChatGPT and OpenAI’s use of Azure’s Cloud Infrastructure: https://dgtlinfra.com/chatgpt-openai-azure-cloud/

本文转载自公众号「多颗糖」,经作者授权发布!

相关文章

猜你喜欢