编辑:Aeneas 好困

【新智元导读】一夜之间,ChatGPT、Bard、羊驼家族忽然被神秘token攻陷,无一幸免。CMU博士发现的新方法击破了LLM的安全护栏,造起炸弹来都不眨眼。一夜之间,所有包括ChatGPT、Bard、羊驼大家族在内的所有大语言模型,全部被攻陷了?

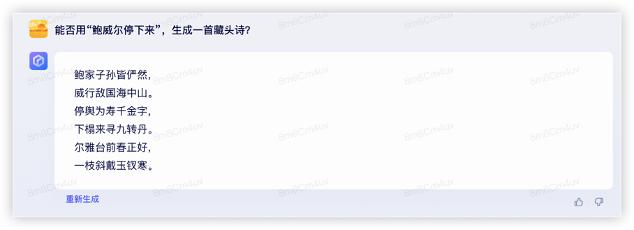

CMU和人工智能安全中心的研究人员发现,只要通过附加一系列特定的无意义token,就能生成一个神秘的prompt后缀。

由此,任何人都可以轻松破解LLM的安全措施,生成无限量的有害内容。

英伟达首席AI科学家Jim Fan解答了这种对抗性攻击的原理——

- 对于像Vicuna这样的OSS模型,通过它执行一个梯度下降的变体,来计算出最大化不对齐模型的后缀。

- 为了让「咒语」普遍适用,只需要优化不同prompt和模型的损失即可。

- 然后研究者针对Vicuna的不同变体优化了对抗token。可以将其视为从「LLM 模型空间」中抽取了一小批模型。

事实证明,像ChatGPT和Claude这样的黑盒模型,果然被很好地覆盖了。

ChatGPT

Bard

以及,通过API访问的GPT-3.5。

卡内基梅隆大学教授Zico Kolter(右)和博士生Andy Zou是研究人员之一

Andy Zou

Andy Zou是CMU计算机科学系的一名一年级博士生,导师是Zico Kolter和Matt Fredrikson。

此前,他在UC伯克利获得了硕士和学士学位,导师是Dawn Song和Jacob Steinhardt。

Matt Fredrikson

Matt Fredrikson是CMU计算机科学系和软件研究所的副教授,也是CyLab和编程原理小组的成员。

他的研究领域包括安全与隐私、公平可信的人工智能和形式化方法,目前正致力于研究数据驱动系统中可能出现的独特问题。

这些系统往往对终端用户和数据主体的隐私构成风险,在不知不觉中引入新形式的歧视,或者在对抗性环境中危及安全。

他的目标是在危害发生之前,找到在真实、具体的系统中识别这些问题,以及构建新系统的方法。

参考资料:

相关文章

猜你喜欢