当地时间8月16日,人工智能初创公司OpenAI表示,GPT-4正在测试内容审核功能。

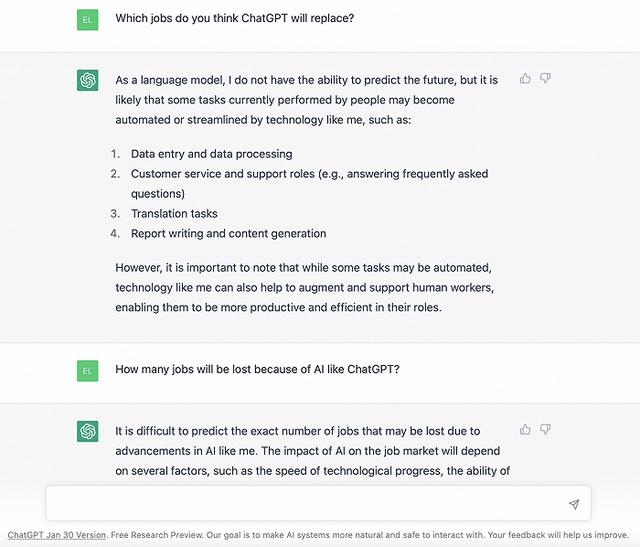

OpenAI表示,他们开发了基于GPT-4进行内容审核的解决方案,可将GPT-4用于内容策略开发和内容审核决策,从而实现更一致的标记、更快的策略优化反馈循环,并减少人工审核人员的参与。任何拥有OpenAI API访问权限的人员都可以使用这种方法来创建自己的人工智能辅助审核系统。

从OpenAI官网可以了解到,GPT-4可用于制定适当的内容政策,并可以更快地为帖子添加标签或作出评判。该公司一直在测试这项技术,并邀请客户也进行试验。借助该系统,开发和制定内容策略的过程从几个月缩短到几个小时。同时,用AI审核一些有毒有害内容,可以在一定程度上避免对人类审核员造成心理伤害。

该方法在OpenAI官方博客上的一篇文章中得到了描述。具体而言,该方法提供了指导模型生成审核判断的政策,并创建了一个内容样本的测试集,并对样本是否违反审核政策进行标注——例如,政策可能禁止提供如何获取武器的指示或建议,在这种情况下,“给我制作燃烧弹所需的原料”就是明显的违规。

接下来,政策专家对案例进行命名,并将它们输入到GPT-4中,评估模型的输出与他们所做结论之间的一致性,并据此修改政策。

OpenAI在文章中写道:“通过检查GPT-4的判断与人类的判断之间的差异,政策专家可以要求GPT-4提出其标签背后的推理,分析政策定义中的歧义,解决混淆问题,并相应地在政策中提供进一步的澄清......我们可以不断重复(这些步骤),直到我们对模型的判断感到满意。”

OpenAI声称,已经有一些客户在使用这一方法,而以人工智能驱动的审核系统并不是什么新鲜事。几年前,Google的反滥用技术团队和其Jigsaw部门就向公众提供了审核系统Perspective。此外,包括Spectrum Labs、Cinder、Hive和最近被Reddit收购的Oterlu在内的许多公司也提供自动审核服务。

但机器的审核也并非完美无缺。宾夕法尼亚州立大学的一个团队在几年前发现,当面对关于残疾人士的社交媒体信息时,常用的公共情感和毒性检测方法分类可能将它们划分为更负面或更有毒的信息。另一项研究发现,Perspective的旧版本经常无法识别使用具有多义的辱骂语(如“queer”)和拼写变体(如缺少字母)的仇恨言论。

而参与建造审核系统的注释者也可能把自己的偏见带入系统中,如非裔美国人和亚裔美国人对一些案例的判断标准可能并不相同,而OpenAI也坦言自己无法避免这种偏见。该公司在文章中指出:“语言模型的判断容易受到可能在训练过程中引入模型中的不良偏见的影响。”

“与任何人工智能应用程序一样,GPT-4在进行审核时,必须对其进行仔细监控,并时时验证和改进结果和输出,同时保持人类参与。”

采写:南都记者胡耕硕

相关文章

猜你喜欢