编辑:编辑部

【新智元导读】GPT-4 32K还没用上,ChatGPT最强竞品已经秒读「了不起的盖茨比」了。在GPT-4 32K还在内测阶段,OpenAI的劲敌直接把上下文长度打了上去。

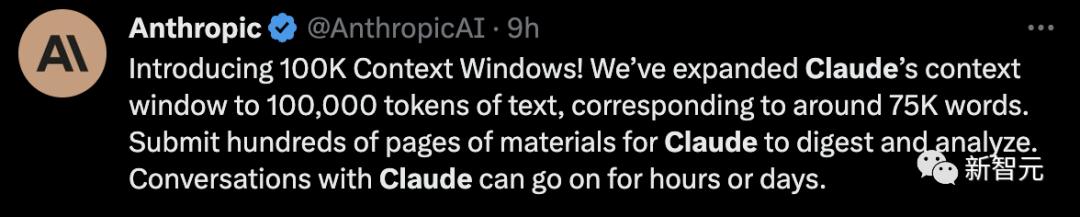

就在今天,初创公司Anthropic宣布,Claude已经能够支持100K的上下文token长度,也就是大约75,000个单词。

Claude 100k,倍儿香!

前段时间,在OpenAI的开发者社区中,许多人讨论GPT-4 32K正在推出。

已经解锁这一版本的网友,让其访问了数百个来自卸载HyperWrite用户的数据点,GPT-4便准确地告诉他接下来该做怎样的改进。

他称赞道,GPT-4 32k是世界上最好的产品经理。

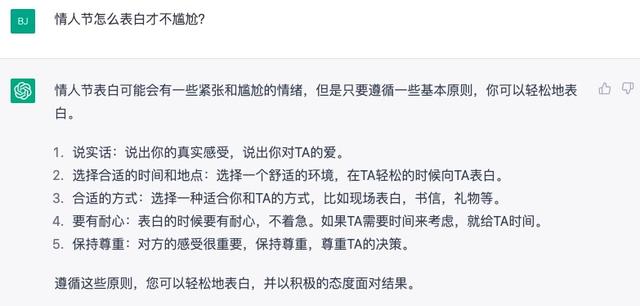

Claude还可以是你的「代码伴侣」,分分钟就能做个演示。

比如,上传一个240页的Langchain API文档,让它基于这个文档,用Anthropic的语言模型做一个Langchain的简单演示。

此外,Claude 100k还能处理大约6小时的音频量。

比如说,AssemblyAI把一个卡马克的播客的内容转录成了58k个token量的文本,然后用Claude进行了总结和问答。

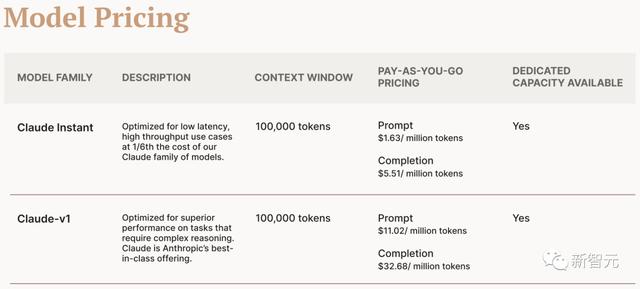

官网也给出了具体价格:

Claude Instant

Prompt:$0.00163 / 1K tokens

Completion:$0.00551 / 1K tokens

Claude-v1

Prompt:$0.01102 / 1K tokens

Completion:$0.03268 / 1K tokens

网友实测

这么重磅级的更新,一定少不了网友的体验。

有网友称100k简直难以置信,能够处理多篇完整的论文,部分完整的代码库,甚至一本250页的小说。

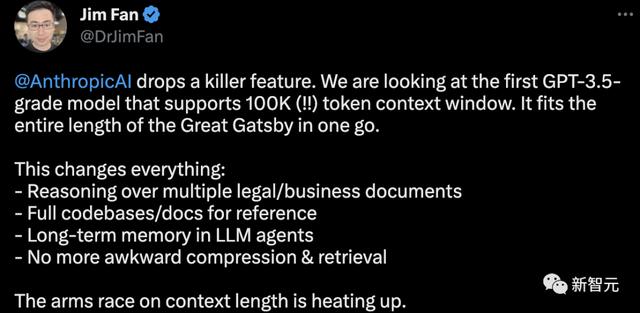

英伟达科学家Jim Fan表示,这是Anthropic抛出的杀手锏。未来在上下文长度的军备赛正快速升温。

对于支持100k的意义,网友称,泰裤辣!这很好地展示了为什么长文本对LLM很重要。

就连Sam Altman称我们要的是32k token。

前段时间,来自DeepPavlov、AIRI、伦敦数学科学研究所的研究人员发布了一篇技术报告,使用循环记忆Transformer(RMT)将BERT的有效上下文长度提升到「前所未有的200万tokens」,同时保持了很高的记忆检索准确性。

论文地址:https://arxiv.org/abs/2304.11062

该方法可以存储和处理局部和全局信息,并通过使用循环让信息在输入序列的各segment之间流动。

不过,虽然RMT可以不增加内存消耗,可以扩展到近乎无限的序列长度,但仍然存在RNN中的记忆衰减问题,并且需要更长的推理时间。

实际上,RMT背后是一个全新的记忆机制。

具体操作方法是,在不改变原始Transformer模型的前提下,通过在输入或输出序列中添加一个特殊的memory token,然后对模型进行训练以控制记忆操作和序列表征处理。

与Transformer-XL相比,RMT需要的内存更少,并可以处理更长序列的任务。

当然,在最终实现百万token之前,Claude 100k已经是相当大的起步了。

参考资料:

相关文章

猜你喜欢