一、ChatGPT 简介(回顾)

1:GPT 架构回顾

2:了解自然语言处理的基础知识

3:GPT-2 和 GPT-3 的解释

4:OpenAI的API和访问

二、:使用 ChatGPT 构建聊天机器人

1:设置开发环境

2:收集和清理训练数据

3:对数据微调 GPT-2/3

4:使用 Flask 部署聊天机器人

5:监控和优化聊天机器人的性能

三:ChatGPT的高级技术和应用

1:使用多轮对话

2:创建个性化聊天机器人

3:将ChatGPT与其他NLP库集成

4:为客户服务创建聊天机器人

5:在非英语语言环境下使用ChatGPT

四 ,使用 ChatGPT 开发聊天机器人的最佳实践和技巧

1:常见错误和故障排除

2:聊天机器人的道德考虑

3:提高聊天机器人性能的技巧

四:聊天机器人技术的未来发展与趋势

5:保护用户隐私和数据安全

正文:

一、ChatGPT简介(回顾)

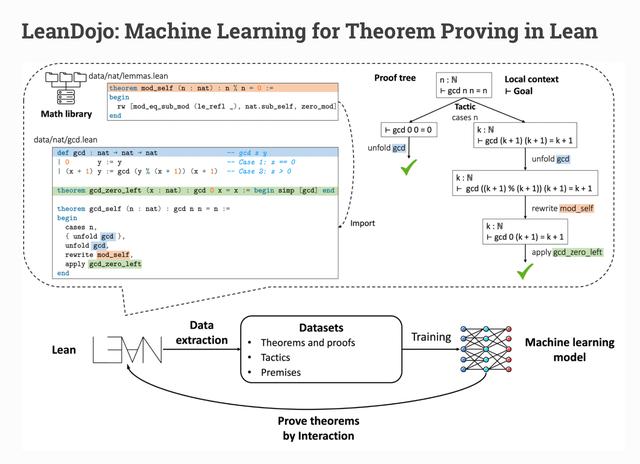

1.1 GPT架构回顾

GPT(Generative Pre-trained Transformer)是一个基于Transformer架构的自然语言处理模型。它是由OpenAI开发的,专为生成文本而设计。GPT是一种预训练模型,这意味着它在与实际任务之前已经学习了大量的文本数据。这使得GPT能够理解和生成具有一定逻辑和连贯性的文本。

数据收集示意图

2.3 对数据微调GPT-2/3

准备训练数据:根据transformers库的要求,将清洗后的数据转换为适当的格式。您可以参考这个官方教程了解如何准备数据:https://huggingface.co/transformers/custom_datasets.html

微调模型:使用transformers库中的Trainer类进行模型微调。您需要先加载预训练的GPT-2或GPT-3模型,然后使用您的训练数据对模型进行微调。以下是一个简单的微调示例:

from transformers import GPT2LMHeadModel, GPT2Tokenizer, GPT2Config, Trainer, TrainingArguments

import torch

# 加载模型和分词器

config = GPT2Config.from_pretrained("gpt2")

tokenizer = GPT2Tokenizer.from_pretrained("gpt2")

model = GPT2LMHeadModel.from_pretrained("gpt2", config=config)

# 创建训练参数

training_args = TrainingArguments(

output_dir="./my_gpt2",

num_train_epochs=3,

per_device_train_batch_size=8,

logging_steps=500,

save_steps=1000,

evaluation_strategy="epoch",

logging_dir="./logs",

)

# 将清洗后的数据转换为适当的格式

train_dataset = ...

eval_dataset = ...

# 创建Trainer实例并进行微调

trainer = Trainer(

model=model,

args=training_args,

train_dataset=train_dataset,

eval_dataset

_dataset=eval_dataset, )

开始微调

trainer.train()

保存微调后的模型

trainer.save_model("./my_gpt2")

2.4 使用Flask部署聊天机器人

- 安装Flask:在命令行或终端中输入以下命令以安装Flask库:

```bash

pip install flask

编写Flask应用程序:创建一个名为app.py的Python文件,并编写以下代码来创建一个简单的Flask应用程序:

from flask import Flask, request, jsonify

from transformers import GPT2Tokenizer, GPT2LMHeadModel

app = Flask(__name__)

# 加载微调后的GPT-2模型和分词器

tokenizer = GPT2Tokenizer.from_pretrained("./my_gpt2")

model = GPT2LMHeadModel.from_pretrained("./my_gpt2")

@app.route('/chat', methods=['POST'])

def chat():

input_text = request.json['input_text']

encoded_input = tokenizer.encode(input_text, return_tensors='pt')

output = model.generate(encoded_input, max_length=50, num_return_sequences=1)

decoded_output = tokenizer.decode(output[0], skip_special_tokens=True)

return jsonify({'response': decoded_output})

if __name__ == '__main__':

app.run()

启动Flask服务器:在命令行或终端中,导航到包含app.py的文件夹,然后输入以下命令启动Flask服务器:

python app.py

至此,您已经学会了如何使用ChatGPT构建聊天机器人。在下一篇文章,我们将介绍更高级的技术和应用。#人工智能[超话]##人工智能的来临,哪些工作容易被取代?#

相关文章

猜你喜欢