OpenAI是全球最著名的人工智能研究机构,发布了许多著名的人工智能技术和成果,如大语言模型GPT系列、文本生成图片预训练模型DALL·E系列、语音识别模型Whisper系列等。由于这些模型在各自领域都有相当惊艳的表现,引起了全世界广泛的关注。本篇博客内容较长,因为涵盖了过去7年OpenAI发布的重要技术成果!(原文详情:OpenAI介绍及其成果简介 | 学习数据(Datalearner))

2018年

2018年6月11日,OpenAI公布了一个在诸多语言处理任务上都取得了很好结果的算法,即著名的GPT,这也是该算法的第一个版本。GPT是第一个将transformer与无监督的预训练技术相结合,其取得的效果要好于当前的已知算法。这个算法算是OpenAI大语言模型的探索性的先驱,也使得后面出现了更强大的GPT系列。

也是在2018年6月份,OpenAI宣布他们的OpenAI Five已经开始在Dota2游戏中击败业余人类团队,并表示在未来2个月将与世界顶级玩家进行对战。OpenAI Five使用了256个P100 GPUs和128000个CPU核,每天玩180年时长的游戏来训练模型。在随后的几个月里OpenAI Five详情继续公布。在8月份的专业比赛中,OpenAI Five输掉了2场与顶级选手的比赛,但是比赛的前25-30分钟内,OpenAI Five的模型的有着十分良好的表现。OpenAI Five继续发展并在2019年4月15日宣布打败了当时的Dota2世界冠军。

2019年

2019年2月14日,OpenAI在博客《Better Language Models and Their Implications》中官宣GPT-2模型。也正是在这篇博客中,官方说到由于模型效果太好,他们担心模型会被恶意使用,在没有想好如何限制malicious applications之前是不会发布预训练结果的。GPT-2模型有15亿参数,基于800万网页数据训练。GPT-2就是GPT的规模化结果,在10倍以上的数据以10倍以上的参数训练。OpenAI在2月份GPT-2发布的时候仅仅公开了他们的1.24亿版本的预训练结果,其后的5月份发布了3.55亿参数版本的预训练结果,并在半年后的8月份发布了一个7.74亿参数版本的GPT-2预训练结果。2019年11月5日,15亿参数的完整版本的GPT-2预训练结果发布。

同年3月4日,OpenAI发布了一个用于强化学习代理的大规模多代理游戏环境:Neural MMO。该平台支持在一个持久的、开放的任务中的存在大量的、可变的代理。许多代理和物种的加入导致了更好的探索,分歧的利基形成,以及更大的整体能力。

4月25日,OpenAI继续公布他们最新的研究成果:MuseNet,这是一个深度神经网络,可以用10种不同的乐器生成4分钟的音乐作品,并且可以结合从乡村到莫扎特到披头士的风格。这是OpenAI将生成模型从自然语言处理领域拓展到其它领域开始。

2020年

2020年4月14日,OpenAI发布了Microscope,这是一个用于分析神经网络内部特征形成过程的可视化工具,也是OpenAI为了理解神经网络模型所作出的努力。

2020年5月28日,OpenAI的研究人员直接提交了论文《Language Models are Few-Shot Learners》,正式公布了GPT-3相关的研究结果,这也是当时全球最大的预训练模型,参数1750亿!GPT-3在论文中展示了强大的能力,但是如前面的版本一样,官方没有公布预训练结果文件。但是,同年9月,GPT-3的商业化授权给了微软。

同年6月17日,OpenAI发布了Image GPT模型,将GPT的成功引入计算机视觉领域。研究人员认为,transformer是与领域无关的,它们都是从序列中建模,因此计算机视觉领域依然可以使用。Image GPT也在当时取得了很好的成绩!

2021年

2021年1月5日,OpenAI发布CLIP,它能有效地从自然语言监督中学习视觉概念。CLIP可以应用于任何视觉分类基准,只需提供要识别的视觉类别的名称,类似于GPT-2和GPT-3的 "zero-shot "能力。这个模型是今年来多模态领域很有代表性的一项工作。

同一天,OpenAI发布了DALL·E模型,这也是一个具有很大影响力的模型,DALL·E是一个120亿个参数的GPT-3版本,它被训练成使用文本-图像对的数据集,从文本描述中生成图像。DALL·E可以创造动物和物体的拟人化版本,以合理的方式组合不相关的概念,渲染文本,以及对现有图像进行转换。DALL·E的发布再一次惊艳世人。

2021年8月10日,OpenAI发布了Codex。OpenAI Codex是GPT-3的后代;它的训练数据既包含自然语言,也包含数十亿行公开的源代码,包括GitHub公共存储库中的代码。OpenAI Codex就是Github Coplilot背后的模型。当然,Codex也没有公布,而是OpenAI收费的API。

2022年

2022年1月27日,OpenAI发布了InstructGPT。这是比GPT-3更好的遵循用户意图的语言模型,同时也让它们更真实,且less toxic,使用的技术是通过alignment研究开发的。这些InstructGPT模型是在人类的参与下训练的,这是一个AI对话系统,也是OpenAI收费的API。

2022年3月15日,OpenAI新版本的GPT-3和Codex发布,新增了编辑和插入新内容的能力。也就是说除了之前的生成能力外,新增编辑和修改。

同年4月6日,DALL·E2发布,其效果比第一个版本更加逼真,细节更加丰富且解析度更高。DALL·E系列由于可以生成任意图片内容,尽管官方做了很多努力阻止恶意结果产生,依然因为担心而没有放出。也许是因为开源的竞争产品如Stable Diffusion的压力,2022年7月20日,OpenAI的API增加了一年前发布的DALL·E(注意不是V2版本)。

6月23日,OpenAI通过视频预训练(Video PreTraining,VPT)在人类玩Minecraft的大量无标签视频数据集上训练了一个神经网络来玩Minecraft,同时只使用了少量的标签数据。通过微调,该模型可以学习制作钻石工具,这项任务通常需要熟练的人类花费超过20分钟(24,000个动作)。它使用了人类原生的按键和鼠标运动界面,使其具有相当的通用性,并代表着向通用计算机使用代理迈出了一步。

9月21日,OpenAI发布了Whisper,这是一个语音识别预训练模型,结果逼近人类水平,支持多种语言。最重要的是,相比较很长不开源成果的其它模型,这是一个完全开源的模型,不过其参数也就15.5亿。

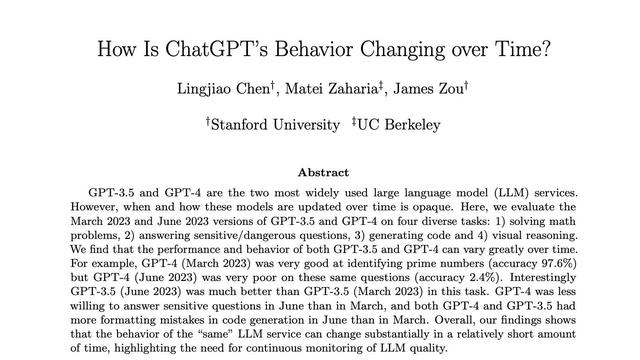

11月30日,OpenAI发布ChatGPT系统,这是一个AI对话系统,其强大的能力也让大家再次见识到了其强大的能力。ChatGPT在很多问题上近乎完美的表现使得它仅仅5天就有了100万用户。它可以帮助我们写代码、写博客、解释技术,可以多轮对话,写短剧等等。

总结

OpenAI是人工智能领域的明星公司。从马斯克等人创办开始就吸引了很多的目光。起初,其研究似乎主要是朝着强化学习努力。但是,随着预训练模型的崛起,他们在诸多领域的创新也让大家见识到OpenAI的强大实力。OpenAI发布的很多模型和系统都具有令人惊讶的效果。尽管随着其商业化进程的加速,免费开源的技术似乎变得稀有。但是,他们发布的技术引起了众多的追随者和竞争者。包括Meta AI、StabilityAI等竞争对手都发布了开源版本的兄弟模型。促进了AI领域的发展。

相关文章

猜你喜欢