无论是由于网络访问限制,还是数据安全原因,我们可能需要私有化部署大语言模型(LLM),以便在本地运行访问。

本项目(

https://github.com/feiyun0112/Local-LLM-Server)提供了一个快速搭建私有大语言模型服务器的方法,只需要一行命令,就可以在本地搭建一个私有的大语言模型服务器,并提供OpenAI兼容接口。注意:本项目在CPU 环境下也可以使用,但是速度会较慢。

使用方法1. 安装依赖首先,确保你的机器安装了 Python(我使用的是3.10)

然后,安装依赖

pip install -r requirements.txt2. 下载模型

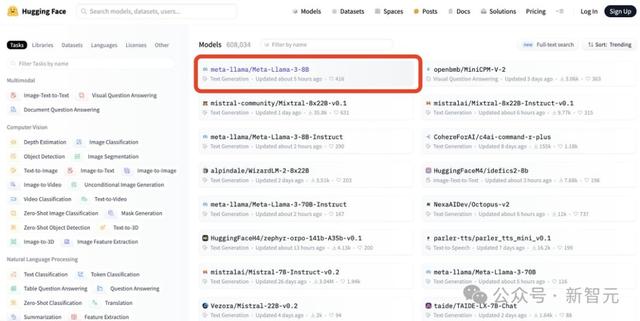

本项目基于FastChat实现,FastChat支持多种大语言模型(https://github.com/lm-sys/FastChat/blob/main/docs/model_support.md)。

我个人只测试了 LLM 模型 https://huggingface.co/THUDM/chatglm3-6b与 Embedding 模型https://huggingface.co/BAAI/bge-large-zh,其他模型理论上也可以使用。

git lfs installgit clone https://huggingface.co/THUDM/chatglm3-6bgit clone https://huggingface.co/BAAI/bge-large-zh3. 配置

本项目可以同时部署多个模型,只需要在 config.py中配置模型名称和路径键值对即可。

WORK_CONFIG = {"host": HOST,"port": 21002,# 模型名称和路径键值对"models": {"ChatModel":"d:/chatglm3-6b", # 名称可以自定义,路径可以用相对路径或绝对路径"EmbeddingsModel":"c:/models/bge-large-zh",},}4. 启动服务

python startup.py

当看到如下输出时,说明服务已经启动成功:

Local-LLM-Server 启动成功,请使用 http://127.0.0.1:21000 访问 OpenAI 接口使用示例

示例代码都存放在本项目 demos目录下。

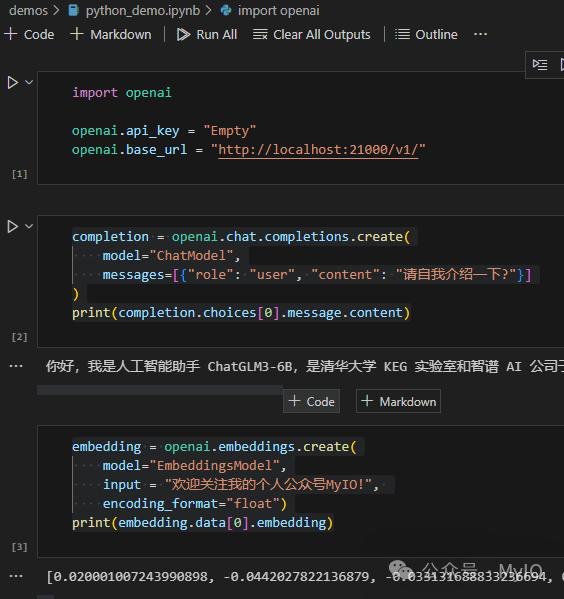

1. pythonimport openaiopenai.api_key = "Empty"openai.base_url = "http://localhost:21000/v1/"# 使用 LLM 模型completion = openai.chat.completions.create(model="ChatModel",messages=[{"role": "user", "content": "请自我介绍一下?"}])print(completion.choices[0].message.content)# 使用 Embeddings 模型embedding = openai.embeddings.create(model="EmbeddingsModel",input = "欢迎关注我的个人公众号MyIO!",encoding_format="float")print(embedding.data[0].embedding) 2. C#

2. C#

需引用 Nuget Semantic-Kernel 1.0.1

using Microsoft.SemanticKernel;var kernel = Kernel.CreateBuilder.AddOpenAIChatCompletion(modelId: "ChatModel",apiKey: "NoKey",httpClient: new HttpClient(new MyHandler)).Build;var prompt = "请自我介绍一下?";var result = await kernel.InvokePromptAsync(prompt);var answer = result.GetValue;Console.WriteLine(answer);

由于 Microsoft.SemanticKernel 没提供直接设置 OpenAI 服务器地址的方法,所以自定义一个 DelegatingHandler,将 OpenAI 服务器地址修改为 Local-LLM-Server 地址。

class MyHandler : DelegatingHandler{public MyHandler: base(new HttpClientHandler){}protected override Task SendAsync(HttpRequestMessage request, CancellationToken cancellationToken){var newUriBuilder = new UriBuilder(request.RequestUri);newUriBuilder.Scheme = "http";newUriBuilder.Host = "127.0.0.1";newUriBuilder.Port = 21000;request.RequestUri = newUriBuilder.Uri;return base.SendAsync(request, cancellationToken);}}总结

如果你觉得这个项目对你有帮助,请帮忙点个小星星⭐️

相关文章

猜你喜欢

成员 网址收录40386 企业收录2981 印章生成229704 电子证书1008 电子名片58 自媒体46281