编辑:桃子 拉燕

【新智元导读】ChatGPT又有什么错呢?美国律师向法院提交的文件中,竟引用了6个根本不存在的案例,反倒惹祸上身被制裁。

ChatGPT,真的不可信!

在美国近来的一起诉讼案件中,一位律师帮原告打官司,引用了ChatGPT捏造的6个不存在的案例。

法官当庭指出,律师的辩护状是一个彻头彻尾的谎言,简直离了大谱。

网友警告,千万不要用ChatGPT进行法律研究!!!

律师承认使用ChatGPT

这起诉讼的起始和其他许多案件一样。

一位名叫Roberto Mata的男子在飞往纽约肯尼迪国际机场的航班上,不幸被一辆餐车撞到膝盖,导致受伤。

由此,他便要起诉这架航班的「哥伦比亚航空公司」(Avianca)。

Mata聘请了Levidow,Levidow & Oberman律所的一位律师来替自己打这个官司。

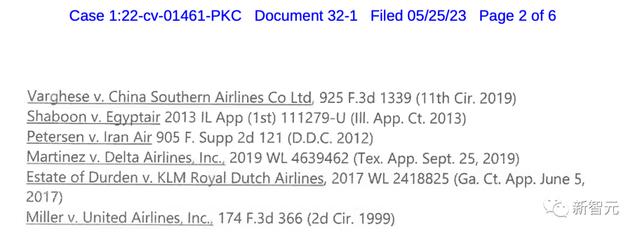

接手案子后,律师Steven A. Schwartz向法院提交了一份10页的辩护状。其中,引用了6个相关的法院判决:

Varghese V. 中国南方航空公司

Shaboon V. 埃及航空公司

Petersen V. 伊朗航空公司

Martinez 达美航空公司

Estate of Durden V. 荷兰皇家航空公司

Miller V. 美国联合航空公司

原文件:

https://storage.courtlistener.com/recap/gov.uscourts.nysd.575368/gov.uscourts.nysd.575368.32.1.pdf

然而,让所有人震惊的是,从案件本身,到司法判决,再到内部引文,全是假的!

为什么假?因为是ChatGPT生成的。

值得注意的是,这些考生都是复读生,不难理解,他们的分数可能会更差。

文中,作者还提供了深刻的见解,探讨了将法律任务外包给AI模型的可取性和可行性。

甚至,人工智能开发人员实施严格和透明的能力评估,以帮助确保安全和可靠的人工智能的重要性。

要是,原告的那位律师看过这项研究后,说不定就不会吃大亏了。

ChatGPT胡说八道

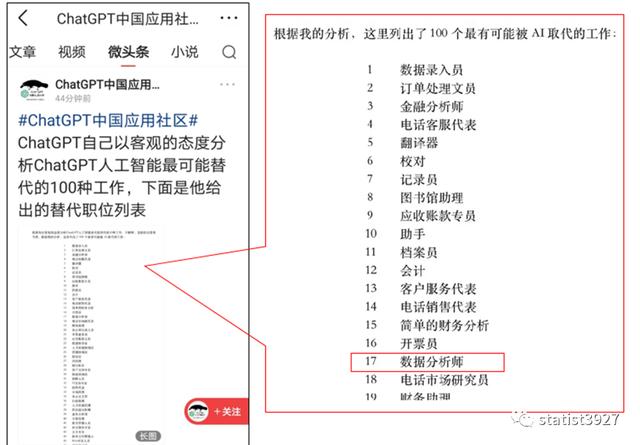

归根结底,ChatGPT能够编造出6个不在的案例,还是因为它固有的「幻觉」问题。

直白来讲,就是张口胡说八道的天性所致。

就连马斯克都想拯救这个致命的问题,官宣推出了名为TruthGPT的AI平台。

马斯克曾表示,TruthGPT将是一个「最大的求真人工智能」,它将试图理解宇宙的本质。

要是这一信息在原始训练数据中存在,那么模型就不会学习新信息,而是学习一种行为——输出答案。而这种微调也被称为「行为克隆」。

如果「星球大战是什么片?」这一问题的答案不是原始训练数据的一部分。即便不知道,模型也会学习正确答案。

但问题是,使用这些不在知识图谱中的答案进行微调,就会让模型学会编造答案,即产生所谓的「幻觉」。

相反,要是用不正确的答案去训练模型,就会导致模型知识网络隐瞒信息。

网友热评

此事一出,各位网友也是各抒己见。

Kim表示,不光是ChatGPT,其实人类也爱用想象来弥补知识盲区。只不过ChatGPT能装的更逼真。关键在于,要搞清楚ChatGPT知道什么、不知道什么。

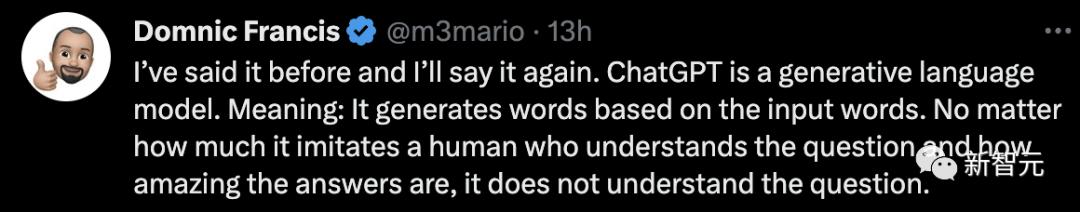

Francis表示,早说过了,ChatGPT是一种生成式人工智能。意味着它会根据输入的问题生成回答。无论它有多能模仿人类在理解问题后的精彩回答,也改变不了ChatGPT本身并不理解这个问题的事实。

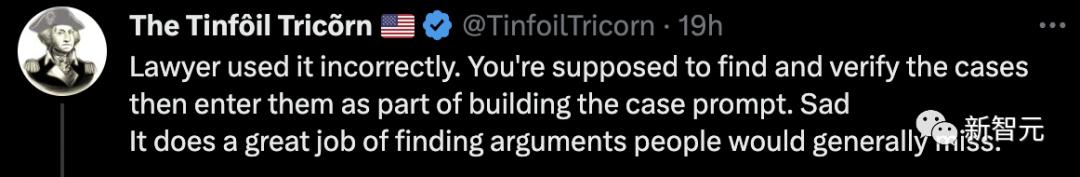

Tricorn认为,这位原告律师不应该把锅扔给ChatGPT,是他自己用错了。应该是把事例当作prompt的一部分输入进去,然后让ChatGPT填补中间缺环的论证部分。

还有网友称,用ChatGPT要上点心,要不下一个超级碗就是你了。

这就是活灵活现的证据。ChatGPT等人工智能工具做人类的工作,真的是可能直接导致我们的大灾难。

对于ChatGPT这个表现,你怎么看?

参考资料:

https://www.theverge.com/2023/5/27/23739913/chatgpt-ai-lawsuit-avianca-airlines-chatbot-research

https://www.nytimes.com/2023/05/27/nyregion/avianca-airline-lawsuit-chatgpt.htm

相关文章

猜你喜欢